La videoconferencia se ha convertido en la piedra angular de cuántos de nosotros trabajamos en estos días, tanto que un servicio líder, Zoom, se ha graduado en estado de verbo debido a cuánto se está usando.

¿Pero eso significa que la videoconferencia funciona tan bien como debería? Hoy, una nueva startup llamada Headroom está saliendo sigilosamente, aprovechando una batería de herramientas de inteligencia artificial (visión por computadora, procesamiento del lenguaje natural y más) con la creencia de que la respuesta a esa pregunta es clara, no hay una mala interrupción de WiFi aquí: ” No.”

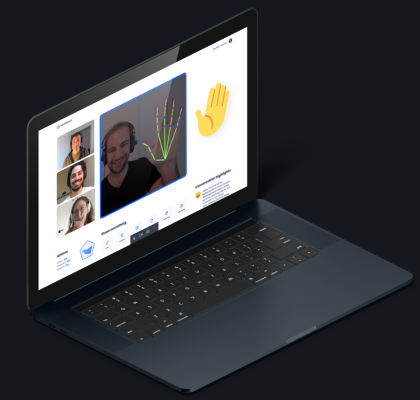

Headroom no solo organiza videoconferencias, sino que luego proporciona transcripciones, resúmenes con aspectos destacados, reconocimiento de gestos, calidad de video optimizada y más, y hoy anuncia que ha recaudado una ronda inicial de $ 5 millones a medida que se prepara para lanzar su servicio freemium en el mundo.

Puede inscribirse en la lista de espera para probarlo y obtener otras actualizaciones aquí.

La financiación proviene de Anna Patterson de Gradient Ventures (el fondo de riesgo de IA de Google); Evan Nisselson de LDV Capital (un especialista en capital de riesgo que respalda a empresas que construyen tecnologías visuales); Jerry Yang, fundador de Yahoo, ahora de AME Cloud Ventures; Ash Patel de Morado Ventures; Anthony Goldbloom, cofundador y director ejecutivo de Kaggle.com; y Serge Belongie, decano asociado de Cornell Tech y profesor de visión artificial y aprendizaje automático.

Es un grupo interesante de patrocinadores, pero eso podría deberse a que los propios fundadores tienen una formación bastante ilustre con años de experiencia en el uso de algunas de las tecnologías visuales más avanzadas para crear otros servicios empresariales y para el consumidor.

Julian Green, un trasplante británico, estuvo más recientemente en Google, donde ejecutó los productos de visión por computadora de la compañía, incluida la API Cloud Vision que se lanzó bajo su supervisión. Llegó a Google mediante la adquisición de su anterior startup Jetpac, que utilizaba el aprendizaje profundo y otras herramientas de inteligencia artificial para analizar fotos y hacer recomendaciones de viaje. En una vida anterior, fue uno de los cofundadores de Houzz, otro tipo de plataforma que depende de la interactividad visual.

Mientras tanto, Andrew Rabinovich, nacido en Rusia, pasó los últimos cinco años en Magic Leap, donde fue jefe de IA, y antes de eso, director de aprendizaje profundo y jefe de ingeniería. Antes de eso, él también estuvo en Google, como ingeniero de software especializado en visión por computadora y aprendizaje automático.

Se podría pensar que dejar sus trabajos para construir un mejor servicio de videoconferencia fue un movimiento oportunista, dado el enorme aumento de uso que ha tenido el medio este año. Green, sin embargo, me dice que se les ocurrió la idea y comenzaron a construirla a fines de 2019, cuando el término “Covid-19” ni siquiera existía.

“Pero ciertamente ha hecho de esta un área más interesante”, bromeó, y agregó que también facilitó significativamente la recaudación de dinero. (La ronda se cerró en julio, dijo).

Dado que Magic Leap había estado durante mucho tiempo en el limbo, AR y VR han demostrado ser increíblemente difíciles de construir negocios, especialmente a corto y mediano plazo, incluso para una startup con cientos de millones de dólares en respaldo de VC, y podría probablemente haya usado algunas ideas más interesantes para pivotar; y que Google es Google, con toda la tecnología con un punto final en Mountain View, también es curioso que la pareja haya decidido emprender por su cuenta para construir Headroom en lugar de lanzar la construcción de la tecnología a sus respectivos empleadores anteriores.

Green dijo que las razones eran dobles. El primero tiene que ver con la eficiencia de construir algo cuando eres pequeño. “Disfruto moviéndome a la velocidad inicial”, dijo.

Y el segundo tiene que ver con los desafíos de construir cosas en plataformas heredadas versus nuevas, desde cero.

“Google puede hacer lo que quiera”, respondió cuando le pregunté por qué no pensó en llevar estas ideas al equipo que trabaja en Meet (o Hangouts si no eres un usuario empresarial). “Pero para ejecutar IA en tiempo real en videoconferencias, es necesario desarrollarla desde el principio. Comenzamos con esa suposición ”, dijo.

De todos modos, es probable que las razones por las que Headroom es interesante también sean las que le planteen grandes desafíos. La nueva ubicuidad (y nuestra vida actual trabajando en casa) podría hacernos más abiertos al uso de videollamadas, pero para bien o para mal, ahora también estamos bastante acostumbrados a lo que ya usamos. Y para muchas empresas, ahora han pagado como usuarios premium a un servicio u otro, por lo que pueden ser reacios a probar plataformas nuevas y menos probadas.

Pero como hemos visto en tecnología tantas veces, a veces vale la pena ser un motor tardío, y los primeros no siempre son los ganadores.

La primera iteración de Headroom incluirá características que tomarán automáticamente las transcripciones de toda la conversación, con la capacidad de usar la repetición del video para editar la transcripción si algo sale mal; ofrecer un resumen de los puntos clave que se hacen durante la llamada; e identificar gestos para ayudar a cambiar la conversación.

Y Green me dice que ya están trabajando en funciones que se agregarán en futuras iteraciones. Cuando la videoconferencia utiliza materiales de presentación complementarios, el motor también puede procesarlos para los aspectos más destacados y la transcripción.

Y otra característica optimizará los píxeles que ve para obtener una calidad de video mucho mejor, lo que debería ser especialmente útil cuando usted o la persona o personas con las que está hablando tienen conexiones deficientes.

“Puedes entender dónde y cuáles son los píxeles en una videoconferencia y enviar los correctos”, explicó. “La mayor parte de lo que ves de mí y de mis antecedentes no cambia, por lo que no es necesario enviarlos todo el tiempo”.

Todo esto aprovecha algunos de los aspectos más interesantes de la visión por computadora sofisticada y los algoritmos de lenguaje natural. La creación de un resumen, por ejemplo, se basa en tecnología que es capaz de detectar no solo lo que está diciendo, sino cuáles son las partes más importantes de lo que usted o alguien más está diciendo.

Y si alguna vez estuvo en una videollamada y le resultó difícil dejar en claro que quería decir algo, sin interrumpir directamente al orador, comprenderá por qué los gestos pueden ser muy útiles.

Pero también pueden ser útiles si un orador quiere saber si está perdiendo la atención de la audiencia: la misma tecnología que usa Headroom para detectar gestos para las personas que desean hablar también se puede usar para detectar cuándo están aburrirse o enfadarse y pasar esa información a la persona que habla.

“Se trata de ayudar con EQ”, dijo, con lo que estoy seguro que fue un poco de su lengua en la mejilla, pero de nuevo estábamos en una reunión de Google, y es posible que lo haya malinterpretado.

Y eso nos lleva a por qué Headroom está aprovechando una oportunidad interesante. En el mejor de los casos, cuando funcionan, herramientas como estas no solo potencian las videoconferencias, sino que también tienen el potencial de resolver algunos de los problemas con los que se puede haber enfrentado en las reuniones cara a cara. La creación de software que en realidad podría ser mejor que el “real” es una forma de asegurarse de que pueda tener un poder de permanencia más allá de las demandas de nuestras circunstancias actuales (que con suerte no serán circunstancias permanentes).