Colaborador Andrea Gagliano

Más publicaciones de este colaborador Compensaciones de IA: Equilibrio de modelos poderosos y sesgos potenciales

A medida que los desarrolladores desbloquean nuevas herramientas de inteligencia artificial, el riesgo de perpetuar sesgos dañinos se vuelve cada vez más alto, especialmente después de un año como 2020, que reinventó muchas de nuestras normas sociales y culturales sobre las que los algoritmos de inteligencia artificial se han entrenado durante mucho tiempo.

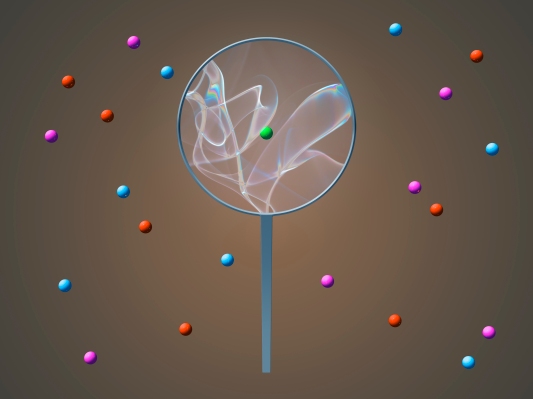

Están surgiendo un puñado de modelos fundamentales que dependen de una magnitud de datos de entrenamiento que los hace intrínsecamente poderosos, pero no están exentos de riesgo de sesgos dañinos, y debemos reconocer colectivamente ese hecho.

El reconocimiento en sí mismo es fácil. Comprender es mucho más difícil, al igual que mitigar los riesgos futuros. Es decir, primero debemos tomar medidas para asegurarnos de que comprendemos las raíces de estos sesgos en un esfuerzo por comprender mejor los riesgos involucrados en el desarrollo de modelos de IA.

Los orígenes furtivos del sesgo

Los modelos de IA de hoy en día a menudo están previamente entrenados y son de código abierto, lo que permite a los investigadores y a las empresas implementar la IA rápidamente y adaptarla a sus necesidades específicas.

Si bien este enfoque hace que la inteligencia artificial esté más disponible comercialmente, hay una desventaja real, a saber, que un puñado de modelos ahora sustenta la mayoría de las aplicaciones de inteligencia artificial en todas las industrias y continentes. Estos sistemas están cargados de sesgos no detectados o desconocidos, lo que significa que los desarrolladores que los adaptan para sus aplicaciones están trabajando desde una base frágil.

Según un reciente estudio por el Centro de Investigación de Modelos Fundamentales de Stanford, cualquier sesgo dentro de estos modelos fundacionales o los datos sobre los que están construidos son heredados por quienes los usan, creando potencial para la amplificación.

Por ejemplo, YFCC100M es un conjunto de datos disponible públicamente de Flickr que se usa comúnmente para entrenar modelos. Cuando examine las imágenes de personas dentro de este conjunto de datos, verá que la distribución de imágenes en todo el mundo es fuertemente sesgado hacia los EE. UU., lo que significa que hay una falta de representación de personas de otras regiones y culturas.

Estos tipos de sesgos en los datos de entrenamiento dan como resultado modelos de IA que tienen sesgos de representación insuficiente o excesiva en su salida, es decir, una salida que es más dominante para las culturas blancas u occidentales. Cuando se combinan varios conjuntos de datos para crear grandes conjuntos de datos de formación, hay una falta de transparencia y puede resultar cada vez más difícil saber si tiene una mezcla equilibrada de personas, regiones y culturas. No es de extrañar que los modelos de IA resultantes se publiquen con sesgos atroces contenidos en ellos.

Además, cuando se publican modelos de IA fundamentales, normalmente se proporciona poca o ninguna información sobre sus limitaciones. El usuario final debe probar el descubrimiento de posibles problemas, un paso que a menudo se pasa por alto. Sin transparencia y una comprensión completa de un conjunto de datos en particular, es un desafío detectar las limitaciones de un modelo de IA, como un rendimiento más bajo para mujeres, niños o países en desarrollo.

En Getty Images, evaluamos si el sesgo está presente en nuestros modelos de visión por computadora con una serie de pruebas que incluyen imágenes de experiencias reales y vividas, incluidas personas con diferentes niveles de habilidades, fluidez de género y condiciones de salud. Si bien no podemos captar todos los prejuicios, reconocemos la importancia de visualizar un mundo inclusivo y sentimos que es importante comprender los que pueden existir y enfrentarlos cuando podamos.

Aprovechar los metadatos para mitigar los sesgos

¿Entonces como hacemos esto? Cuando trabajamos con IA en Getty Images, comenzamos revisando el desglose de personas en un conjunto de datos de entrenamiento, incluida la edad, el género y la etnia.

Afortunadamente, podemos hacer esto porque necesitamos una versión modelo para el contenido creativo que licenciamos. Esto nos permite incluir información autoidentificada en nuestros metadatos (es decir, un conjunto de datos que describen otros datos), lo que permite a nuestro equipo de inteligencia artificial buscar automáticamente en millones de imágenes e identificar rápidamente los sesgos en los datos. Los conjuntos de datos de código abierto a menudo están limitados por la falta de metadatos, un problema que se agrava cuando se combinan conjuntos de datos de múltiples fuentes para crear un grupo más grande.

Pero seamos realistas: no todos los equipos de IA tienen acceso a metadatos expansivos, y el nuestro tampoco es perfecto. Existe una compensación inherente: datos de entrenamiento más grandes que conducen a modelos más poderosos a expensas de comprender los sesgos y los sesgos en esos datos.

Como industria de la inteligencia artificial, es crucial que encontremos una manera de superar esta compensación, dado que las industrias y las personas a nivel mundial dependen de ella. La clave es aumentar nuestro enfoque en modelos de IA centrados en datos, un movimiento que comienza a tomar fuerza.

¿A dónde vamos desde aquí?

Enfrentar los prejuicios en la IA no es poca cosa y requerirá la colaboración de toda la industria tecnológica en los próximos años. Sin embargo, existen medidas de precaución que los profesionales pueden tomar ahora para realizar cambios pequeños pero notables.

Por ejemplo, cuando se publican modelos fundamentales, podríamos publicar los correspondientes ficha de datos describiendo los datos de entrenamiento subyacentes, proporcionando estadísticas descriptivas de lo que hay en el conjunto de datos. Hacerlo proporcionaría a los usuarios posteriores una idea de las fortalezas y limitaciones de un modelo, lo que les permitiría tomar decisiones informadas. El impacto podría ser enorme.

Lo antes mencionado estudio sobre los modelos fundamentales plantea la pregunta: “¿Cuál es el conjunto correcto de estadísticas sobre los datos para proporcionar una documentación adecuada, sin que sea demasiado costoso o difícil de obtener?” Para datos visuales específicamente, los investigadores idealmente proporcionarían las distribuciones de edad, género, raza, religión, región, habilidades, orientación sexual, condiciones de salud y más. Pero estos metadatos son costosos y difíciles de obtener en grandes conjuntos de datos de múltiples fuentes.

Un enfoque complementario sería que los desarrolladores de inteligencia artificial tuvieran acceso a una lista actualizada de sesgos conocidos y limitaciones comunes para los modelos fundamentales. Esto podría incluir el desarrollo de una base de datos de pruebas de fácil acceso para los sesgos a los que los investigadores de IA podrían contribuir regularmente, especialmente teniendo en cuenta cómo las personas usan estos modelos.

Por ejemplo, Twitter facilitó recientemente una competencia que desafió a los expertos en inteligencia artificial a exponer sesgos en sus algoritmos (¿recuerdan cuando dije que el reconocimiento y la conciencia son clave para la mitigación?). Necesitamos más de esto, en todas partes. Practicar el crowdsourcing como este de forma regular podría ayudar a reducir la carga de los profesionales individuales.

Aún no tenemos todas las respuestas, pero como industria, debemos analizar detenidamente los datos que utilizamos como solución para modelos más potentes. Hacerlo tiene un costo (amplificar los sesgos) y debemos aceptar el papel que desempeñamos dentro de la solución. Necesitamos buscar formas de comprender más profundamente los datos de entrenamiento que estamos usando, especialmente cuando los sistemas de IA se usan para representar o interactuar con personas reales.

Este cambio de pensamiento ayudará a las empresas de todos los tipos y tamaños a detectar rápidamente los sesgos y contrarrestarlos en la etapa de desarrollo, atenuando los sesgos.

Source link