La última creación extraña pero fascinante de OpenAI es DALL-E, que a modo de resumen apresurado podría denominarse “GPT-3 para imágenes”. Crea ilustraciones, fotos, renders o cualquier método que prefiera, de cualquier cosa que pueda describir de manera inteligible, desde “un gato con pajarita” hasta “un rábano daikon con tutú paseando a un perro”. Pero no escribas los obituarios de fotografías e ilustraciones todavía.

Como de costumbre, la descripción de OpenAI de su invención es bastante legible y no demasiado técnica. Pero vale la pena contextualizar un poco.

Lo que los investigadores crearon con GPT-3 fue una IA que, dada una indicación, intentaría generar una versión plausible de lo que describe. Entonces, si dice “una historia sobre un niño que encuentra una bruja en el bosque”, intentará escribir una, y si presiona el botón nuevamente, la escribirá nuevamente, de manera diferente. Y una y otra vez y otra vez.

Algunos de estos intentos serán mejores que otros; de hecho, algunos serán apenas coherentes, mientras que otros pueden ser casi indistinguibles de algo escrito por un humano. Pero no genera basura ni errores gramaticales graves, lo que lo hace adecuado para una variedad de tareas, como las nuevas empresas y los investigadores están explorando en este momento.

DALL-E (una combinación de Dali y WALL-E) lleva este concepto más allá. Los agentes de inteligencia artificial llevan años convirtiendo texto en imágenes, con un éxito variable pero en constante aumento. En este caso, el agente utiliza la comprensión del lenguaje y el contexto proporcionados por GPT-3 y su estructura subyacente para crear una imagen plausible que coincida con un mensaje.

Como dice OpenAI:

GPT-3 demostró que el lenguaje se puede utilizar para instruir a una gran red neuronal para que realice una variedad de tareas de generación de texto. Image GPT mostró que el mismo tipo de red neuronal también se puede utilizar para generar imágenes con alta fidelidad. Extendemos estos hallazgos para mostrar que la manipulación de conceptos visuales a través del lenguaje está ahora al alcance.

Lo que quieren decir es que un generador de imágenes de este tipo se puede manipular de forma natural, simplemente diciéndole qué hacer. Por supuesto, podría indagar en sus entrañas y encontrar la ficha que representa el color y decodificar sus vías para poder activarlas y cambiarlas, de la misma manera que podría estimular las neuronas de un cerebro real. Pero no harías eso cuando le pidas a tu ilustrador personal que haga algo azul en lugar de verde. Simplemente dices “un coche azul” en lugar de “un coche verde” y lo entienden.

Lo mismo ocurre con DALL-E, que entiende estas indicaciones y rara vez falla de manera seria, aunque hay que decir que incluso cuando se mira el mejor de cien o mil intentos, muchas imágenes que genera son más que un poco … apagado. De los cuales más tarde.

En la publicación de OpenAI, los investigadores dan abundantes ejemplos interactivos de cómo se le puede decir al sistema que haga variaciones menores de la misma idea, y el resultado es plausible y, a menudo, bastante bueno. La verdad es que estos sistemas pueden ser muy frágiles, ya que admiten que DALL-E lo es de alguna manera, y decir que “un bolso de cuero verde con forma de pentágono” puede producir lo que se espera, pero “un bolso de gamuza azul con forma de pentágono” podría producir combustible de pesadilla. ¿Por qué? Es difícil de decir, dada la naturaleza de caja negra de estos sistemas.

Créditos de imagen: OpenAI

Pero DALL-E es notablemente robusto a tales cambios y produce de manera confiable prácticamente cualquier cosa que pida. Un toro de guacamole, una esfera de cebra; un gran bloque azul asentado sobre un pequeño bloque rojo; una vista frontal de un carpincho feliz, una vista isométrica de un carpincho triste; y así sucesivamente y así sucesivamente. Puedes jugar con todos los ejemplos en la publicación.

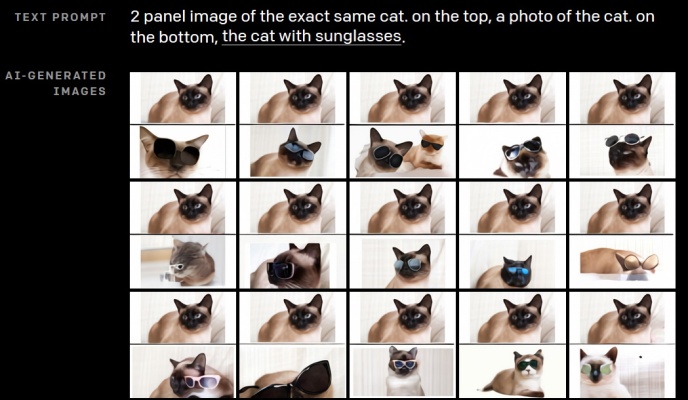

También exhibió algunos comportamientos no deseados pero útiles, utilizando lógica intuitiva para comprender solicitudes como pedirle que hiciera varios bocetos del mismo gato (inexistente), con el original en la parte superior y el boceto en la parte inferior. No hay codificación especial aquí: “No anticipamos que esta capacidad surgiría, y no hicimos modificaciones a la red neuronal o al procedimiento de entrenamiento para fomentarla”. Esto esta bien.

Curiosamente, se utilizó otro nuevo sistema de OpenAI, CLIP, junto con DALL-E para comprender y clasificar las imágenes en cuestión, aunque es un poco más técnico y más difícil de entender. Puede leer sobre CLIP aquí.

Las implicaciones de esta capacidad son muchas y variadas, tanto que no intentaré entrar en ellas aquí. Incluso los despejes de OpenAI:

En el futuro, planeamos analizar cómo modelos como DALL · E se relacionan con problemas sociales como el impacto económico en ciertos procesos de trabajo y profesiones, el potencial de sesgo en los resultados del modelo y los desafíos éticos a largo plazo que implica esta tecnología.

En este momento, como GPT-3, esta tecnología es asombrosa y, sin embargo, es difícil hacer predicciones claras al respecto.

En particular, muy poco de lo que produce parece realmente “final”, es decir, no podría decirle que haga una imagen principal para cualquier cosa que haya escrito últimamente y esperar que publique algo que pueda usar sin modificaciones. Incluso una breve inspección revela todo tipo de rarezas de la IA (La especialidad de Janelle Shane), y aunque estas asperezas se eliminarán con el tiempo, está lejos de ser seguro, la forma en que el texto GPT-3 no puede enviarse sin editar en lugar de la escritura humana.

Ayuda a generar muchos y elegir los primeros, como muestra la siguiente colección:

Los ocho primeros de un total de X generados, con X aumentando a la derecha. Créditos de imagen: OpenAI

Eso no quita mérito al logro de OpenAI aquí. Este es un trabajo fabulosamente interesante y poderoso, y al igual que los otros proyectos de la compañía, sin duda se convertirá en algo aún más fabuloso e interesante en poco tiempo.