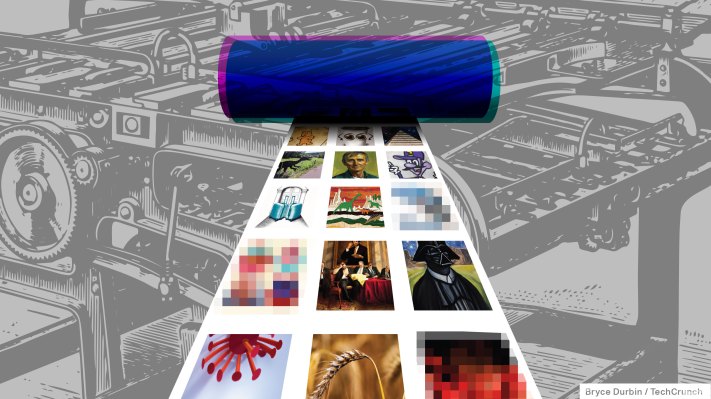

A nuevo generador de imágenes de IA de código abierto capaz de producir imágenes realistas a partir de cualquier mensaje de texto, ha tenido una aceptación asombrosamente rápida en su primera semana. La difusión estable de Stability AI, de alta fidelidad pero capaz de ejecutarse en hardware de consumo estándar, ahora la utilizan los servicios de generación de arte como Artbreeder, Pixelz.ai y más. Pero la naturaleza sin filtrar del modelo significa que no todo el uso ha sido completamente legítimo.

En su mayor parte, los casos de uso han sido honestos. Por ejemplo, NovelAI ha estado experimentando con Stable Diffusion para producir arte que pueda acompañar las historias generadas por IA creadas por los usuarios en su plataforma. Midjourney ha lanzado una versión beta que aprovecha Stable Diffusion para un mayor fotorrealismo.

Pero Stable Diffusion también se ha utilizado para fines menos sabrosos. En el infame foro de discusión 4chan, donde la modelo se filtró temprano, varios hilos están dedicados al arte generado por IA de celebridades desnudas y otras formas de pornografía generada.

Emad Mostaque, director ejecutivo de Stability AI, calificó de “desafortunado” que el modelo se filtró en 4chan y enfatizó que la empresa estaba trabajando con “especialistas en ética y tecnologías líderes” en seguridad y otros mecanismos relacionados con la publicación responsable. Uno de estos mecanismos es una herramienta de IA ajustable, Safety Classifier, incluida en el paquete de software Stable Diffusion general que intenta detectar y bloquear imágenes ofensivas o indeseables.

Sin embargo, el Clasificador de seguridad, aunque está activado de forma predeterminada, se puede desactivar.

Stable Diffusion es un territorio muy nuevo. Otros sistemas de generación de arte de IA, como DALL-E 2 de OpenAI, han implementado filtros estrictos para material pornográfico. (Los licencia porque el código abierto Stable Diffusion prohíbe ciertas aplicaciones, como la explotación de menores, pero el modelo en sí no está limitado en el nivel técnico). Además, muchos no tienen la capacidad de crear arte de figuras públicas, a diferencia de Stable Diffusion. Esas dos capacidades podrían ser riesgosas cuando se combinan, permitiendo a los malos actores crear “falsificaciones profundas” pornográficas que, en el peor de los casos, podrían perpetuar el abuso o implicar a alguien en un crimen que no cometió.

Un deepfake de Emma Watson, creado por Stable Diffusion y publicado en 4chan.

Las mujeres, desafortunadamente, son las más propensas a ser las víctimas de esto. Un estudio realizado en 2019 reveló que, del 90% al 95% de las falsificaciones profundas que no son consensuadas, alrededor del 90% son mujeres. Eso es un mal augurio para el futuro de estos sistemas de IA, según Ravit Dotan, especialista en ética de la IA de la Universidad de California, Berkeley.

“Me preocupan otros efectos de las imágenes sintéticas de contenido ilegal, que exacerbarán los comportamientos ilegales que se representan”, dijo Dotan a TechCrunch por correo electrónico. “Por ejemplo, ¿el niño sintético [exploitation] aumentar la creación de niños auténticos [exploitation]? ¿Aumentará el número de ataques de pederastas?”.

El investigador principal del Instituto de Ética de la IA de Montreal, Abhishek Gupta, comparte esta opinión. “Realmente necesitamos pensar en el ciclo de vida del sistema de IA, que incluye el uso y el monitoreo posteriores a la implementación, y pensar en cómo podemos visualizar controles que puedan minimizar los daños incluso en los peores escenarios”, dijo. “Esto es particularmente cierto cuando una poderosa capacidad [like Stable Diffusion] entra en la naturaleza que puede causar un trauma real a aquellos contra quienes se podría usar dicho sistema, por ejemplo, mediante la creación de contenido objetable en la semejanza de la víctima”.

Algo de un avance se desarrolló durante el año pasado cuando, siguiendo el consejo de una enfermera, un padre tomó fotografías del área genital hinchada de su hijo pequeño y se las envió por mensaje de texto al iPhone de la enfermera. Se realizó una copia de seguridad automática de la foto en Google Photos y los filtros de IA de la empresa la marcaron como material de abuso sexual infantil, lo que resultó en la desactivación de la cuenta del hombre y en una investigación por parte del Departamento de Policía de San Francisco.

Si una foto legítima pudiera disparar un sistema de detección de este tipo, dicen expertos como Dotan, no hay razón para que las falsificaciones profundas generadas por un sistema como Stable Diffusion no puedan, y a escala.

“Los sistemas de inteligencia artificial que crean las personas, incluso cuando tienen las mejores intenciones, pueden usarse de formas dañinas que no anticipan ni pueden prevenir”, dijo Dotan. “Creo que los desarrolladores e investigadores a menudo subestimaron este punto”.

Por supuesto, la tecnología para crear deepfakes existe desde hace algún tiempo, impulsada por IA o no. Un 2020 reporte de la empresa de detección de deepfake Sensity descubrió que cada mes se cargaban cientos de videos deepfake explícitos con celebridades femeninas en los sitios web de pornografía más grandes del mundo; el informe estimó el número total de deepfakes en línea en alrededor de 49,000, más del 95% de los cuales eran porno. Actrices como Emma Watson, Natalie Portman, Billie Eilish y Taylor Swift han sido objeto de falsificaciones profundas desde que las herramientas de intercambio de rostros impulsadas por IA entraron en la corriente principal hace varios años, y algunas, incluida Kristen Bell, se han pronunciado en contra de lo que ven como explotación sexual.

Pero Stable Diffusion representa una nueva generación de sistemas que pueden crear imágenes falsas increíblemente convincentes, si no perfectas, con un trabajo mínimo por parte del usuario. También es fácil de instalar, ya que no requiere más que unos pocos archivos de configuración y una tarjeta gráfica que cuesta varios cientos de dólares en el extremo superior. Se está trabajando en versiones aún más eficientes del sistema que pueden ejecutarse en una MacBook M1.

Un deepfake de Kylie Kardashian publicado en 4chan.

Sebastián Berns, un Ph.D. El investigador del grupo de IA de la Universidad Queen Mary de Londres cree que la automatización y la posibilidad de ampliar la generación de imágenes personalizadas son las grandes diferencias con sistemas como Stable Diffusion y los principales problemas. “La mayoría de las imágenes dañinas ya se pueden producir con métodos convencionales, pero son manuales y requieren mucho esfuerzo”, dijo. “Un modelo que puede producir imágenes casi fotorrealistas puede dar paso a ataques de chantaje personalizados contra individuos”.

Berns teme que las fotos personales extraídas de las redes sociales puedan usarse para condicionar Stable Diffusion o cualquier modelo similar para generar imágenes pornográficas específicas o imágenes que representen actos ilegales. Ciertamente hay un precedente. Después de informar sobre la violación de una niña cachemir de ocho años en 2018, la periodista de investigación india Rana Ayyub convertirse el objetivo de los trolls nacionalistas indios, algunos de los cuales crearon pornografía falsa con su rostro en el cuerpo de otra persona. El deepfake fue compartido por el líder del partido político nacionalista BJP, y el acoso que recibió Ayyub como resultado se volvió tan grave que las Naciones Unidas tuvieron que intervenir.

“Stable Diffusion ofrece suficiente personalización para enviar amenazas automáticas contra las personas para que paguen o se arriesguen a que se publiquen imágenes falsas pero potencialmente dañinas”, continuó Berns. “Ya vemos personas extorsionadas después de que se accedió a su cámara web de forma remota. Ese paso de infiltración podría no ser necesario nunca más.”

Con Stable Diffusion en la naturaleza y ya se está utilizando para generar pornografía, algunos no consensuados, podría ser necesario que los anfitriones de imágenes tomen medidas. TechCrunch contactó a una de las principales plataformas de contenido para adultos, OnlyFans, pero no recibió respuesta al momento de la publicación. Un vocero de Patreon, que también permite contenido para adultos, señaló que la compañía tiene una política contra las falsificaciones profundas y no permite imágenes que “reutilicen las semejanzas de las celebridades y coloquen el contenido que no es para adultos en un contexto para adultos”.

Sin embargo, si la historia sirve de indicación, aplicación probablemente será desigual, en parte porque pocas leyes protegen específicamente contra la falsificación profunda en lo que respecta a la pornografía. E incluso si la amenaza de una acción legal hace que algunos sitios dedicados a contenido inaceptable generado por IA se hundan, no hay nada que impida que aparezcan otros nuevos.

En otras palabras, dice Gupta, es un mundo nuevo y valiente.

“Los usuarios creativos y maliciosos pueden abusar de las capacidades [of Stable Diffusion] para generar contenido objetable subjetivamente a escala, utilizando recursos mínimos para ejecutar inferencias, que es más barato que entrenar todo el modelo, y luego publicarlos en lugares como Reddit y 4chan para generar tráfico y piratear la atención”, dijo Gupta. “Hay mucho en juego cuando tales capacidades escapan “a la naturaleza”, donde los controles como los límites de tasa de API, los controles de seguridad sobre los tipos de salidas devueltas por el sistema ya no son aplicables”.