“Si AI es tan fácil, ¿por qué no hay nadie en esta sala? “, pregunta Ali Farhadi, fundador y CEO de Xnor, gesticulando alrededor de la sala de conferencias con vista a Lake Union en Seattle. Y es cierto: a pesar de un puñado de pantallas, teléfonos y otros dispositivos, las únicas cosas realmente capaces de hacer cualquier tipo de trabajo de tipo AI son los teléfonos que cada uno de nosotros ha puesto sobre la mesa. Sin embargo, siempre estamos escuchando cómo la IA es tan accesible ahora, tan flexible, tan ubicua.

Y, en muchos casos, incluso aquellos dispositivos que no pueden emplear técnicas de aprendizaje automático, sino que envían datos a la nube donde se puede hacer de manera más eficiente. Debido a que los procesos que conforman la “IA” a menudo requieren muchos recursos, consumen el tiempo de CPU y la energía de la batería.

Ese es el problema que Xnor intentó resolver, o al menos mitigar, cuando se escindió del Instituto Allen de Inteligencia Artificial en 2017. Su gran avance fue hacer que la ejecución de modelos de aprendizaje profundo en dispositivos de vanguardia fuera tan eficiente que una Raspberry Pi Zero de $ 5 pudiera Realice procesos de visión de computadora de vanguardia casi tan bien como una supercomputadora.

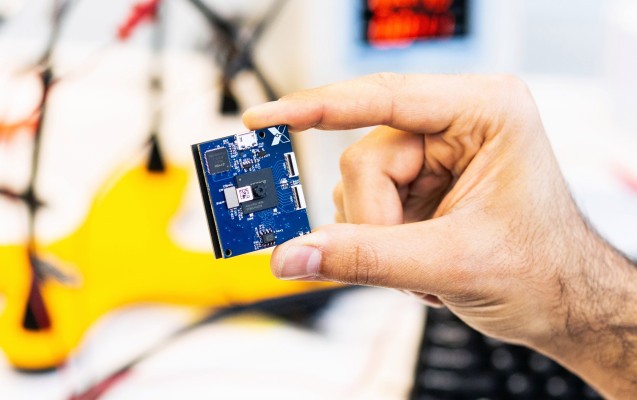

El equipo logró eso y los modelos de ML hipereficaces de Xnor ahora están integrados en una variedad de dispositivos y negocios. Como seguimiento, el equipo establece sus miras más altas o más bajas, dependiendo de su perspectiva.

Farhadi, respondiendo a su propia pregunta sobre la escasez de dispositivos habilitados para la IA, señaló el paquete de baterías en el dispositivo de demostración que hicieron para mostrar la plataforma Pi Zero, Farhadi explicó: “Esto está justo aquí. Poder.”

La energía fue el cuello de botella que superaron para obtener AI en los dispositivos con CPU y de energía limitada, como los teléfonos y el Pi Zero. Así que al equipo se le ocurrió una meta loca: ¿por qué no hacer una plataforma de inteligencia artificial que no necesite una batería? Menos de un año después, lo habían hecho.

El dispositivo Farhadi y el jefe de ingeniería de hardware Saman Naderiparizi me mostraron que es muy simple, y necesariamente así. Una pequeña cámara con una resolución de 320 × 240, un FPGA cargado con el modelo de reconocimiento de objetos, un poco de memoria para manejar la imagen y el software de la cámara, y una pequeña célula solar. Una configuración inalámbrica muy simple le permite enviar y recibir datos a una velocidad muy modesta.

“Esta cosa tiene no poder. “Es una computadora de dos dólares con una cámara súper crappy, y puede ejecutar el reconocimiento de objetos de última generación”, comentó Farhadi, claramente más que complacido con lo que el equipo de Xnor ha creado.

Para referencia, este video del debut de la compañía muestra el tipo de trabajo que está haciendo dentro:

Mientras la celda se encuentre en algún tipo de luz significativa, alimentará el procesador de imágenes y el algoritmo de reconocimiento de objetos. Necesita alrededor de cien milivoltios para funcionar, aunque en niveles más bajos podría tomar imágenes con menos frecuencia.

Puede funcionar solo con esa corriente, pero por supuesto no es práctico no tener algunos tipo de almacenamiento de energía; para ese fin, este dispositivo de demostración tiene un supercapacitador que almacena suficiente energía para mantenerlo funcionando toda la noche, o simplemente cuando su fuente de luz está oculta.

Como demostración de su eficiencia, digamos que decidió equiparlo con, digamos, una batería de reloj. Naderiparizi dijo que probablemente podría funcionar con eso a un fotograma por segundo durante más de 30 años.

No es un producto

Por supuesto, el avance no es realmente que ahora hay una cámara inteligente con energía solar. Eso podría ser útil, claro, pero no es realmente lo que vale la pena decir aquí. Es el hecho de que un sofisticado modelo de aprendizaje profundo puede ejecutarse en una computadora que cuesta unos centavos y usa menos energía que su teléfono cuando está inactivo.

“Esto no es un producto”, dijo Farhadi sobre la pequeña plataforma de hardware. “Es un facilitador”.

La energía necesaria para realizar procesos de inferencia como el reconocimiento facial, el procesamiento del lenguaje natural, etc. pone límites duros a lo que se puede hacer con ellos. Una bombilla inteligente que se enciende cuando se lo pide no es realmente una bombilla inteligente. Es una placa en un recinto de bombilla que transmite su voz a un concentrador y probablemente a un centro de datos en algún lugar, que analiza lo que dice y devuelve un resultado, encendiendo la luz.

Eso no solo es complicado, sino que introduce la latencia y todo un espectro de lugares donde el proceso podría romperse o ser atacado. ¡Y mientras tanto se requiere una fuente de energía constante o una batería!

Por otro lado, imagina una cámara que pegas en la maceta de una planta de la casa, o te pegas a una pared, o la colocas en la parte superior del librero, o cualquier otra cosa. Esta cámara no requiere más potencia que la luz que la ilumina; puede reconocer comandos de voz y analizar imágenes sin tocar la nube en absoluto; realmente no puede ser hackeado porque apenas tiene una entrada en absoluto; y sus componentes cuestan tal vez $ 10.

Solo una de estas cosas puede ser verdaderamente ubicua. Solo este último puede escalar a miles de millones de dispositivos sin requerir una inmensa inversión en infraestructura.

Sorprendentemente, el costo de energía de la plataforma no se acerca al fondo. El FPGA utilizado para realizar el cómputo en esta unidad de demostración no es particularmente eficiente por la potencia de procesamiento que proporciona. Si tuvieran un chip personalizado horneado, podrían obtener otro orden de magnitud o dos, reduciendo el costo de trabajo para la inferencia al nivel de microjoules. El tamaño está más limitado por la óptica de la cámara y el tamaño de la antena, que debe tener ciertas dimensiones para transmitir y recibir señales de radio.

Y nuevamente, no se trata de vender un millón de estos pequeños widgets en particular. Como ya lo ha hecho Xnor con sus clientes, la plataforma y el software que se ejecutan pueden personalizarse para proyectos individuales o hardware. Uno incluso quería que un modelo se ejecutara en MIPS, así que ahora lo hace.

Al reducir drásticamente la potencia y el espacio necesarios para ejecutar un motor de inferencia autónomo, se pueden crear categorías de productos completamente nuevas. ¿Serán espeluznantes? Probablemente. Pero al menos no tendrán que llamar a casa.