Fotos y videos de testigos presenciales distribuidos por el noticiero Reuters ya pasamos por un exhaustivo proceso de verificación de medios. Ahora el editor aportará esa experiencia a la lucha contra la desinformación en Facebook. Hoy lanza la nueva unidad de negocios y el blog Reuters Fact Check, anunciando que se convertirá en uno de los socios externos encargados de desacreditar las mentiras difundidas en la red social.

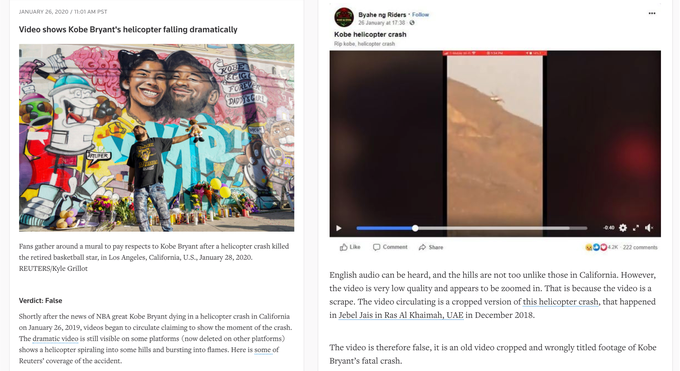

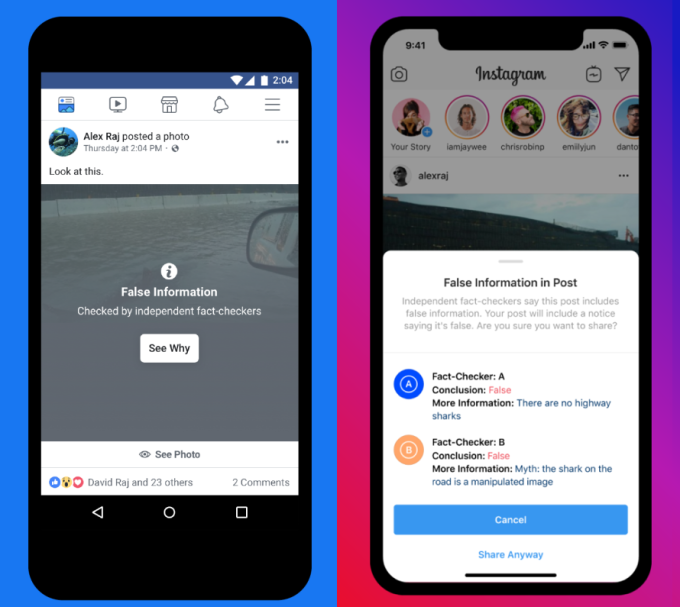

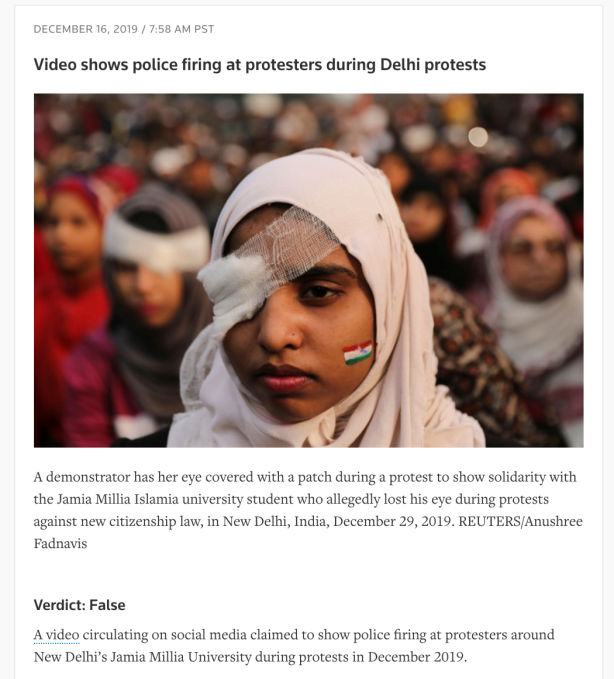

El equipo de cuatro personas de Reuters revisará videos y fotos generados por los usuarios, así como titulares de noticias y otro contenido en inglés y español enviado por Facebook o marcado por el equipo editorial más amplio de Reuters. Luego publicarán sus hallazgos en el nuevo blog Reuters Fact Check, enumerando el reclamo principal y por qué es falso, parcialmente falso o verdadero. Facebook usará esas conclusiones para etiquetar las publicaciones de información errónea como falsas y las reducirá en el algoritmo de News Feed para limitar su propagación.

“No puedo revelar más acerca de los términos del acuerdo financiero, pero puedo confirmar que sí pagan por este servicio”, la Directora de Alianzas Globales de Reuter, Jessica April, me cuenta sobre el acuerdo con Facebook. Reuters se une a la lista de socios de verificación de hechos de EE. UU. Que incluyen The Associated Press, PolitiFact, Factcheck.org y otros cuatro. Facebook ofrece verificación de hechos en más de 60 países, aunque a menudo con un solo socio como las sucursales locales de Agence France-Presse.

Reuters tendrá dos empleados que verifican los hechos en Washington D.C. y dos en la Ciudad de México. Como referencia, Reuters tiene más de 25,000 empleados. Hazel Baker, director global de noticias de UGC de Reuters, dijo que el equipo de verificación de datos podría crecer con el tiempo, ya que planea asociarse con Facebook durante las elecciones de 2020 y más allá. Los verificadores de hechos funcionarán por separado del equipo de verificación de medios de 12 personas, aunque con los aprendizajes obtenidos.

Reuters Fact Check revisará el contenido en todo el espectro de formatos de información errónea. “Tenemos una escala. En un extremo está el contenido que no se manipula pero que ha perdido contexto: videos viejos y reciclados ”, me dice Baker, haciendo referencia a las lecciones del curso que fue coautora al detectar información errónea. A continuación, la escala son fotos y videos editados de manera simplista que pueden ralentizarse, acelerarse, empalmarse o filtrarse. Luego están los medios escenificados que han sido representados o falsificados, como un clip de audio grabado y atribuido maliciosamente a un político. Lo siguiente son imágenes generadas por computadora que pueden inventar contenido o publicitar cosas falsas en un video real. “Y finalmente hay un video sintético o Deepfake” que Baker dijo que toma más trabajo producir.

Baker reconoció las críticas sobre lo lento que es Facebook para dirigir engaños y desinformación a los verificadores de hechos. Si bien Facebook afirma que puede reducir la propagación de este contenido en un 80% utilizando el downranking una vez que el contenido se considera falso, eso no tiene en cuenta todas las vistas que recibe antes de que se envíe y los verificadores de datos lo alcanzan entre las colas profundas de publicaciones sospechosas para ellos a moderar. “Una cosa que tenemos como ventaja de Reuters es la comprensión de la importancia de la velocidad”, insiste Baker. Eso es en parte por qué el equipo revisará el contenido que Reuters elija, no solo lo que Facebook ha enviado.

Desafortunadamente, una cosa que no abordarán es la crítica generalizada sobre la política de Facebook de negarse a verificar los anuncios políticos, incluso si combinan información errónea sensacionalista y difamatoria junto con llamadas para donar a una campaña. “No haríamos ningún comentario sobre esa política de Facebook. Eso depende de ellos “, le dice Baker a TechCrunch. Llamamos a Facebook para prohibir los anuncios políticos, verificarlos o al menos los de los candidatos presidenciales, limitar el microtargeting y / o solo permitir anuncios de campaña que usen formatos estandarizados sin espacio para hacer reclamos potencialmente engañosos.

El problema de la desinformación se avecina a medida que ingresamos a las primarias antes de las elecciones de 2020. En lugar de estar motivados económicamente, cualquiera, desde trolls individuales hasta campañas sospechosas o agentes de inteligencia extranjeros, puede encontrar incentivos políticos para burlarse de la democracia. Idealmente, una organización con la experiencia y la legitimidad de Reuters tendría la financiación para poner a más de cuatro empleados a trabajar protegiendo a cientos de millones de usuarios de Facebook.

Desafortunadamente, Facebook está esforzando su balance para compensar años de negligencia en torno a la seguridad. Los grandes gastos en moderadores de contenido, ingenieros de seguridad y mejoras en las políticas deprimieron su crecimiento de ingresos netos del 61% interanual a fines de 2018 a solo el 7% a partir del último trimestre. Ese es un compromiso cuantificado de mejora. Sin embargo, claramente los problemas persisten.

Facebook pasó años aplastando sus informes de ganancias con ganancias rápidas en el recuento de usuarios, ingresos y ganancias. Pero resulta que lo que parecían increíbles márgenes impulsados por software fueron respaldados por una ausencia en el gasto en salvaguardas. El repentino despertar al precio de proteger a los usuarios ha afectado a otras compañías tecnológicas como Airbnb, que según el Wall Street Journal cae de una ganancia anual de $ 200 millones a fines de 2018 a una pérdida de $ 332 millones un año más tarde mientras combate el robo y el vandalismo. y discriminación.

Pagar a Reuters para que ayude es otro paso en la dirección correcta para Facebook que ahora lleva dos años en su incursión en la verificación de hechos. Es una pena que haya empezado tan lejos.