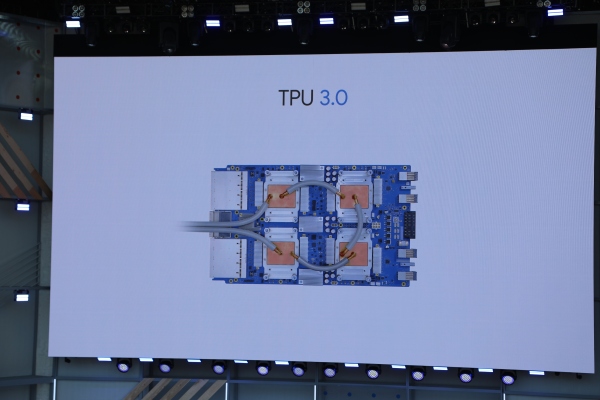

A medida que se intensifica la guerra por la creación de hardware de IA personalizado, Google anunció en Google I/O 2018 que está lanzando su tercera generación de silicio, la Unidad de Procesador Tensor 3.0.

El CEO de Google, Sundar Pichai, dijo que el nuevo pod de TPU es ocho veces más potente que el año pasado, con un rendimiento de hasta 100 petaflops. Google se une a casi todas las demás empresas importantes en la búsqueda de crear silicio personalizado para manejar las operaciones de su máquina. Y aunque han surgido múltiples marcos para desarrollar herramientas de aprendizaje automático, incluidos PyTorch y Caffe2, este está optimizado para TensorFlow de Google. Google está buscando hacer de Google Cloud una plataforma omnipresente a la escala de Amazon, y ofrecer mejores herramientas de aprendizaje automático se está convirtiendo rápidamente en una apuesta en la mesa.

Amazon y Facebook están trabajando en su propio tipo de silicio personalizado. El hardware de Facebook está optimizado para su marco Caffe2, que está diseñado para manejar los gráficos de información masiva que tiene sobre sus usuarios. Puede pensar que toma todo lo que Facebook sabe sobre usted (su cumpleaños, su gráfico de amigos y todo lo que se incluye en el algoritmo de suministro de noticias) en un marco complejo de aprendizaje automático que funciona mejor para sus propias operaciones. Eso, al final, puede haber terminado requiriendo un enfoque personalizado del hardware. Sabemos menos sobre los objetivos de Amazon aquí, pero también quiere poseer el ecosistema de infraestructura en la nube con AWS.

Todo esto también ha generado un ecosistema de inicio cada vez más grande y bien financiado que busca crear una pieza de hardware personalizada dirigida al aprendizaje automático. Hay nuevas empresas como Cerebras Systems, SambaNova Systems y Mythic, con media docena más o menos también (sin incluir la actividad en China). Cada uno busca explotar un nicho similar, que es encontrar una manera de superar a Nvidia en precio o rendimiento para tareas de aprendizaje automático. La mayoría de esas nuevas empresas han recaudado más de $ 30 millones.

Google presentó su procesador TPU de segunda generación en I/O el año pasado, por lo que no fue una gran sorpresa que veríamos otro este año. Habíamos escuchado de fuentes durante semanas que se avecinaba, y que la compañía ya está trabajando arduamente para descubrir qué viene después. Google en ese momento promocionó el rendimiento, aunque el objetivo de todas estas herramientas es hacerlo un poco más fácil y agradable en primer lugar.

Google también dijo que esta es la primera vez que la compañía ha tenido que incluir refrigeración líquida en sus centros de datos, dijo el director ejecutivo Sundar Pichai. La disipación de calor es un problema cada vez más difícil para las empresas que buscan crear hardware personalizado para el aprendizaje automático.

Sin embargo, hay muchas preguntas sobre la construcción de silicio personalizado. Puede ser que los desarrolladores no necesiten una pieza de silicio súper eficiente cuando una tarjeta Nvidia que tiene algunos años puede hacer el truco. Pero los conjuntos de datos son cada vez más grandes, y tener el mejor y más grande conjunto de datos es lo que crea una defensa para cualquier empresa en estos días. Solo la perspectiva de hacerlo más fácil y más barato a medida que las empresas escalan puede ser suficiente para que adopten algo como GCP.

Intel también está buscando entrar aquí con sus propios productos. Intel también ha estado tocando el tambor en FPGA, que está diseñado para ser más modular y flexible a medida que las necesidades de aprendizaje automático cambian con el tiempo. Pero nuevamente, el problema es el precio y la dificultad, ya que la programación para FPGA puede ser un problema difícil en el que no muchos ingenieros tienen experiencia. Microsoft también está apostando por FPGA y reveló lo que llama Brainwave ayer en su conferencia BUILD para su plataforma en la nube Azure, que es una parte cada vez más importante de su potencial futuro.

Google más o menos parece querer poseer toda la pila de cómo operamos en Internet. Comienza en la TPU, con TensorFlow en capas encima. Si logra tener éxito allí, obtiene más datos, hace que sus herramientas y servicios sean cada vez más rápidos y, finalmente, llega a un punto en el que sus herramientas de inteligencia artificial están demasiado adelantadas y bloquea a los desarrolladores y usuarios en su ecosistema. Google es en esencia un negocio de publicidad, pero se está expandiendo gradualmente a nuevos segmentos comerciales que requieren operaciones y conjuntos de datos sólidos para conocer el comportamiento humano.

Ahora, el desafío será tener el mejor argumento para que los desarrolladores no solo los introduzcan en GCP y otros servicios, sino que también los mantengan bloqueados en TensorFlow. Pero a medida que Facebook busca desafiar cada vez más eso con marcos alternativos como PyTorch, puede haber más dificultad de lo que se pensaba originalmente. Facebook presentó una nueva versión de PyTorch en su principal conferencia anual, F8, el mes pasado. Tendremos que ver si Google es capaz de responder adecuadamente para mantenerse a la vanguardia, y eso comienza con una nueva generación de hardware.

Source link