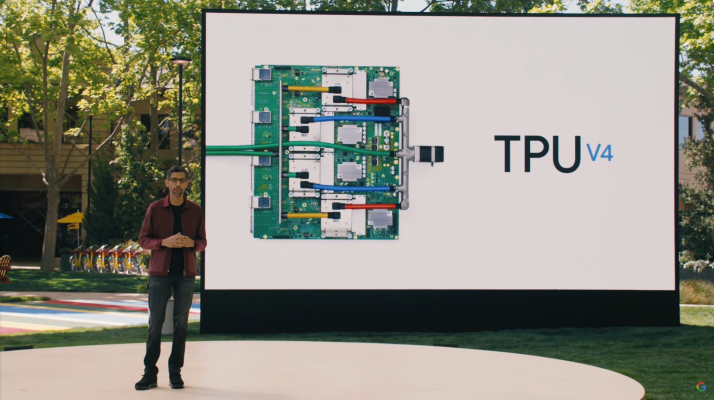

En su conferencia de desarrolladores de E / S, Google anunció hoy la próxima generación de sus chips AI personalizados de unidades de procesamiento de tensor (TPU). Esta es la cuarta generación de estos chips, que según Google son dos veces más rápidos que la última versión. Como señaló el CEO de Google, Sundar Pichai, estos chips luego se combinan en pods con 4.096 v4 TPU. Un solo módulo ofrece más de un exaflop de potencia informática.

Google, por supuesto, utiliza los chips personalizados para impulsar muchos de sus propios servicios de aprendizaje automático, pero también pondrá esta última generación a disposición de los desarrolladores como parte de su Plataforma de Google Cloud.

“Este es el sistema más rápido que hemos implementado en Google y un hito histórico para nosotros”, dijo Pichai. “Anteriormente, para obtener un exaflop, necesitabas construir una supercomputadora personalizada, pero ya tenemos muchas de estas implementadas hoy y pronto tendremos docenas de pods de TPUv4 en nuestros centros de datos, muchos de los cuales operarán con un 90% o casi libre de carbono. energía. Y nuestros pods de TPUv4 estarán disponibles para nuestros clientes de la nube a finales de este año “.

Los TPU estuvieron entre los primeros chips personalizados de Google. Mientras que otros, incluido Microsoft, decidieron optar por FPGA más flexibles para sus servicios de aprendizaje automático, Google hizo una apuesta temprana por estos chips personalizados. Tardan un poco más en desarrollarse y se vuelven obsoletos rápidamente a medida que cambian las tecnologías, pero pueden ofrecer un rendimiento significativamente mejor.