Google se ha apresurado a eliminar aplicaciones de terceros que llevaron a los usuarios a grupos de intercambio de pornografía infantil en WhatsApp a raíz del informe de TechCrunch sobre el problema la semana pasada. Nos pusimos en contacto con Google con el nombre de una de estas aplicaciones y evidencia que ésta y otras ofrecieron enlaces a los grupos de WhatsApp para compartir imágenes de explotación infantil. Tras la publicación de nuestro artículo, Google eliminó de la tienda Google Play esa aplicación y al menos a cinco les gusta. Varias de estas aplicaciones tenían más de 100,000 descargas y aún funcionan en dispositivos que ya las descargaron.

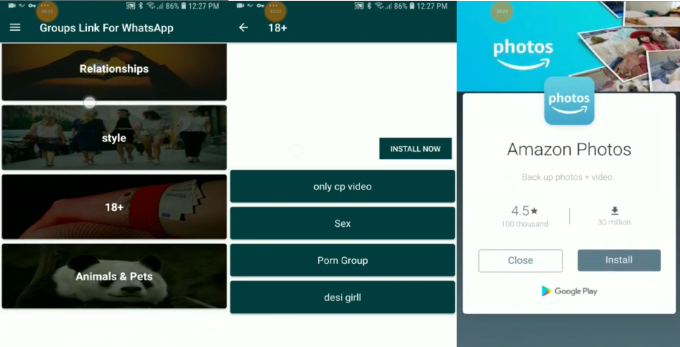

Una captura de pantalla de principios de este mes de grupos de explotación infantil ahora prohibidos en WhatsApp . Números telefónicos y fotos redactadas.

WhatsApp no pudo controlar adecuadamente su plataforma, lo que confirma a TechCrunch que solo está moderada por sus propios 300 empleados y no por Facebook. 20,000 empleados dedicados de seguridad y moderación. Está claro que los sistemas de inteligencia artificial escalables y eficientes no están a la altura de la tarea de proteger a la comunidad de 1.500 millones de usuarios de WhatsApp, y las empresas como Facebook deben invertir más en investigadores humanos que no puedan escalar.

Pero ahora, la nueva investigación proporcionada exclusivamente a TechCrunch por el inicio del algoritmo anti-acoso AntiToxin muestra que estas aplicaciones eliminadas que albergaban enlaces de pornografía infantil en WhatsApp eran compatibles con los anuncios de las redes de anuncios de Google y Facebook. AntiToxin encontró que seis de estas aplicaciones ejecutaban Google AdMob, una ejecutaba Google Firebase, dos ejecutaban Facebook Audience Network y una ejecutaba StartApp. Estas redes publicitarias obtuvieron un recorte en el gasto en marketing de las marcas al tiempo que permitieron que las aplicaciones monetizaran y sustentaran sus operaciones al hospedar anuncios para Amazon, Microsoft, Motorola, Sprint, Sprite, Western Union, Dyson, DJI, Gett, Yandex Music, Q Link Wireless , Tik Tok y más.

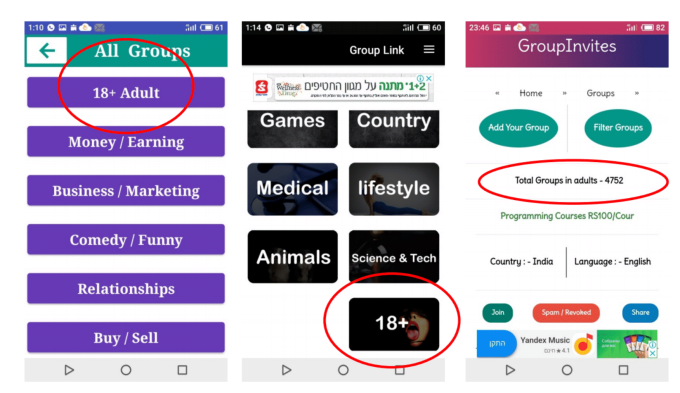

La situación revela que los gigantes tecnológicos no solo no logran detectar contenido ofensivo en sus propias aplicaciones, sino también en aplicaciones de terceros que alojan sus anuncios y que les hacen ganar dinero. Mientras que estas aplicaciones como "Enlaces de grupo para lo que" por Lisa Studio Permitir que las personas descubran enlaces benignos a los grupos de WhatsApp para compartir contenido legal y discutir temas como negocios o deportes, TechCrunch descubrió que también albergaban enlaces con títulos como “Pornografía infantil solo no adv” y “Videos de pornografía infantil” que llevaron a los grupos de WhatsApp con nombres como “Niños ???”O“ videos cp ”: una abreviatura conocida de“ pornografía infantil ”.

En un video proporcionado por AntiToxin que se ve a continuación, la aplicación "Group Links For Whats by Lisa Studio "que ejecutó Google AdMob muestra un anuncio intersticial para Q Link Wireless antes de proporcionar los resultados de la búsqueda grupal de WhatsApp para" child ". Aparece un grupo descrito como" NICE FBI POLICE ", y cuando aparece la invitación. se hace clic en el enlace, se abre dentro de WhatsApp a un grupo utilizado para compartir imágenes de explotación infantil. (No se muestran imágenes ilegales en este video o artículo. TechCrunch omitió el final del video que mostraba una URL de un grupo ilegal y los números de teléfono de sus miembros).

Otro video muestra la aplicación "Group Link For whatsapp por Video Status Zone" que ejecutó Google AdMob y la Red de audiencia de Facebook muestra un enlace a un grupo de WhatsApp descrito como "solo video de cp". Cuando se toca, la aplicación primero muestra un anuncio intersticial para Amazon Photos antes de revelar un botón para abrir el grupo dentro de WhatsApp. Estos videos muestran lo alarmantemente fácil que fue para las personas encontrar grupos de intercambio de contenido ilegal en WhatsApp, incluso sin la ayuda de WhatsApp.

La tolerancia cero no significa cero contenido ilegal

En respuesta, un portavoz de Google me dice que estas aplicaciones de descubrimiento de grupo violaron sus políticas de contenido y que continúa buscando más como ellas para prohibir. Cuando son identificados y eliminados de Google Play, también suspende su acceso a sus redes publicitarias. Sin embargo, se negó a revelar cuánto dinero ganaron estas aplicaciones y si reembolsaría a los anunciantes. La compañía proporcionó esta declaración:

Google tiene un enfoque de tolerancia cero al material de abuso sexual infantil y hemos invertido en tecnología, equipos y asociaciones con grupos como el Centro Nacional para Niños Desaparecidos y Explotados, para abordar este problema durante más de dos décadas. Si identificamos una aplicación que promueve este tipo de material que nuestros sistemas aún no han bloqueado, informamos a las autoridades relevantes y lo eliminamos de nuestra plataforma. Estas políticas se aplican a las aplicaciones enumeradas en Play Store, así como a las aplicaciones que utilizan los servicios de publicidad de Google.

| Aplicación | Desarrollador | Red publicitaria | Instalaciones estimadas | Último día clasificado |

| Enlaces ilimitados de grupos sin límite de Whats | Jack Rehan | Google AdMob | 200,000 | 18/12/2018 |

| Enlaces de grupo ilimitados para Whatsapp | NirmalaAppzTech | Google AdMob | 127,000 | 18/12/2018 |

| Invitación de grupo para Whatsapp | Cerebro villano | Google Firebase | 126,000 | 18/12/2018 |

| Grupo Público para WhatsApp | Construcción de bits | Google AdMob, red de audiencia de Facebook | 86,000 | 18/12/2018 |

| Enlaces de grupo para Whats – Encuentra amigos para Whats | Estudio lisa | Google AdMob | 54,000 | 19/12/2018 |

| Enlaces de grupo ilimitados para Whatsapp 2019 | Natalie Pack | Google AdMob | 3,000 | 20/12/2018 |

| Enlace de grupo para WhatsApp | Zona de estado de video | Google AdMob, red de audiencia de Facebook | 97,000 | 13/11/2018 |

| Enlaces de grupo para Whatsapp – Uniones gratis | Desarrolladores.pk | StartAppSDK | 29,000 | 5/5/2018 |

Mientras tanto, Facebook culpó a Google Play, diciendo que la elegibilidad de las aplicaciones para sus anuncios de Facebook Audience Network estaba ligada a su disponibilidad en Google Play y que las aplicaciones se eliminaron de FAN cuando se iniciaron desde la tienda de aplicaciones de Android. La compañía fue más cercana y le dijo a TechCrunch que reembolsará a los anunciantes cuyas promociones aparecieron en estas aplicaciones abominables. También está sacando a Audience Network de todas las aplicaciones que permiten a los usuarios descubrir los Grupos de WhatsApp.

Un portavoz de Facebook le dice a TechCrunch que "La elegibilidad de monetización de Audience Network está estrechamente vinculada a la revisión de la tienda de aplicaciones (en este caso, Google). Fueron trasladados El[Grupo público para WhatsApp por Bit-Build] cuando Google lo hizo, actualmente no se está monetizando en la red de audiencia. Nuestras políticas están en nuestro sitio web y por precaución, nos aseguramos de que Audience Network no admita ninguna aplicación de enlace de invitación de grupo. "Esta aplicación obtuvo muy pocos ingresos (menos de $ 500), que estamos reembolsando a todos los anunciantes afectados". WhatsApp ya ha prohibido todos los grupos ilegales que TechCrunch informó la semana pasada.

Facebook también proporcionó esta declaración sobre la postura de WhatsApp sobre los grupos de intercambio de imágenes ilegales y las aplicaciones de terceros para encontrarlos:

WhatsApp no proporciona una función de búsqueda para personas o grupos, y WhatsApp no fomenta la publicación de enlaces de invitación a grupos privados. WhatsApp se involucra regularmente con Google y Apple para hacer cumplir sus términos de servicio en aplicaciones que intentan fomentar el abuso en WhatsApp. Después de los informes a principios de esta semana, WhatsApp le pidió a Google que eliminara todas las aplicaciones conocidas para compartir enlaces de grupo. Cuando las aplicaciones se eliminan de Google Play store, también se eliminan de la red de audiencia.

Una aplicación con enlaces para descubrir WhatsApp Groups ilegal publica un anuncio para Amazon Photos

Las ONG israelíes Netivei Reshet y Screen Savers trabajaron con AntiToxin para proporcionar un informe publicado por TechCrunch sobre la gran cantidad de imágenes de explotación infantil que encontraron en WhatsApp. Facebook y WhatsApp siguen esperando que los grupos trabajen con la policía israelí para realizar su investigación completa, por lo que WhatsApp puede eliminar los grupos ilegales que descubrieron y cancelar las cuentas de usuario que se unieron a ellos.

AntiToxin desarrolla tecnologías para proteger el acoso a la red en línea, la intimidación, la vergüenza, el comportamiento depredador y la actividad sexual explícita. Fue co-fundado por Zohar Levkovitz, que vendió Amobee a SingTel por $ 400 millones, y Ron Porat, quien fue el CEO del bloqueador de anuncios Shine. [Disclosure: The company also employs Roi Carthy, who contributed to TechCrunch from 2007 to 2012.] "La toxicidad en línea se encuentra en niveles sin precedentes, a una escala sin precedentes, con riesgos sin precedentes para los niños, por lo que se debe aplicar un pensamiento completamente nuevo a las soluciones tecnológicas que ayudan a los padres a mantener a sus hijos seguros", me dice Levkovitz. La compañía está presionando a Apple para que retire WhatsApp de la App Store hasta que se solucionen los problemas, citando cómo Apple suspendió temporalmente a Tumblr debido a la pornografía infantil.

Las redes publicitarias deben ser monitoreadas

El cifrado ha demostrado ser un impedimento para que WhatsApp impida la propagación de imágenes de explotación infantil. WhatsApp no puede ver lo que se comparte dentro de los chats grupales. En su lugar, tiene que depender de los pocos datos públicos y no cifrados, como nombres de grupos y fotos de perfil, además de las fotos de perfil de sus miembros, en busca de nombres sospechosos o imágenes ilegales. La compañía hace coincidir esas imágenes con una base de datos de PhotoDNA de fotos de explotación infantil conocidas para administrar las prohibiciones, y los moderadores humanos investigan si las imágenes aparentemente ilegales aún no están archivadas. Luego reporta sus hallazgos a la policía y al Centro Nacional para Niños Desaparecidos y Explotados. El cifrado fuerte es importante para proteger la privacidad y la disidencia política, pero también frustra la detección de contenido ilegal y, por lo tanto, requiere más moderación manual.

Con solo 300 empleados en total y solo un subconjunto que trabaja en seguridad o moderación de contenido, WhatsApp no cuenta con suficiente personal para administrar una base de usuarios tan grande. Se ha tratado de depender de AI para salvaguardar a su comunidad. Sin embargo, esa tecnología aún no puede realizar las investigaciones matizadas necesarias para combatir la explotación. WhatsApp se ejecuta semi-independientemente de Facebook, pero podría contratar a más moderadores para investigar las aplicaciones de descubrimiento de grupos que llevan a la pornografía infantil si Facebook asigna más recursos para su adquisición.

Las aplicaciones de descubrimiento de grupos de WhatsApp incluyeron secciones para adultos que contenían enlaces a grupos de imágenes de explotación infantil. Google y Facebook, con sus vastos recuentos y sus márgenes de ganancia, están descuidando la correcta vigilancia de quién hospeda sus redes publicitarias. Las compañías han intentado obtener ingresos adicionales mediante la publicación de anuncios en otras aplicaciones, pero no han asumido la responsabilidad necesaria para garantizar que esas aplicaciones no faciliten los delitos. Deben administrarse exámenes más estrictos del contenido de la aplicación antes de que una aplicación sea aceptada en las tiendas de aplicaciones o redes publicitarias, y periódicamente una vez que se estén ejecutando. Y cuando no se pueden implementar sistemas automatizados, como puede ser el caso con la vigilancia de aplicaciones de terceros, se debe asignar personal humano a pesar del costo.

Cada vez es más claro que las redes sociales y las redes publicitarias que se benefician del contenido de otras personas no pueden ser vacas comerciales de bajo mantenimiento. Las empresas deben invertir mucho dinero y mano de obra para salvaguardar cualquier propiedad que ejecute o monetice, incluso si hace que las oportunidades sean menos lucrativas. La extracción minera de internet sin tener en cuenta las consecuencias debe terminar.