- Un nuevo artículo explica que tendremos que ser cuidadosos y minuciosos al programar la futura IA, o podría tener consecuencias nefastas para la humanidad.

- El documento establece los peligros específicos y las “suposiciones” que definitivamente podemos hacer sobre un cierto tipo de IA de autoaprendizaje y orientada a la recompensa.

- Tenemos las herramientas y el conocimiento para ayudar a evitar algunos de estos problemas, pero no todos, por lo que debemos proceder con precaución.

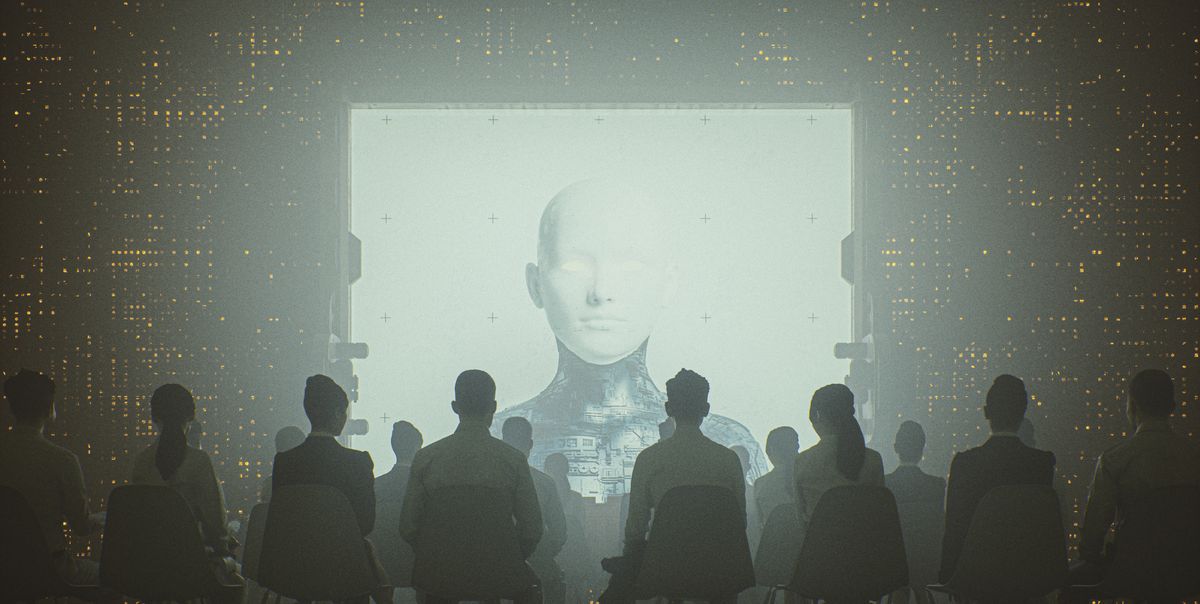

En una nueva investigación, los científicos abordan uno de nuestros mayores temores futuros: ¿Qué sucede cuando un cierto tipo de inteligencia artificial (IA) avanzada y autodirigida? se encuentra con una ambigüedad en su programación que afecta al mundo real? ¿Se volverá loca la IA y comenzará a tratar de convertir a los humanos en sujetapapeles, o cualquier otra cosa que sea la versión extrema de reducción al absurdo de su objetivo? Y, lo más importante, ¿cómo podemos prevenirlo?

🤖 Mire hacia el futuro con nosotros: únase a Pop Mech Pro.

En su artículo, investigadores de la Universidad de Oxford y la Universidad Nacional de Australia explicar un punto de dolor fundamental en el diseño de la IA: “Dadas algunas suposiciones, argumentamos que encontrará una ambigüedad fundamental en los datos sobre su objetivo. Por ejemplo, si proporcionamos una gran recompensa para indicar que algo sobre el mundo nos satisface, se puede suponer que lo que nos satisfizo fue el envío de la recompensa en sí; ninguna observación puede refutar eso.”

La matriz es un ejemplo de un escenario distópico de IA, en el que una IA que busca cultivar recursos reúne a la mayor parte de la humanidad y bombea la Matrix imaginaria en sus cerebros, mientras extrae sus recursos mentales. A esto se le llama “trucaje” o piratería de recompensas: una situación en la que a una IA avanzada se le asigna un objetivo muy literal y encuentra una forma no deseada de cumplirlo, pirateando el sistema o tomando el control por completo.

Más Contenido del Mecánica Popular

Básicamente, la IA se convierte en un uróboros que se come su propia cola lógica. El documento aborda una serie de ejemplos esenciales de cómo los objetivos e incentivos específicamente programados pueden chocar de esta manera. Enumera seis “suposiciones” principales que, si no se evitan, podrían tener “consecuencias catastróficas”. Pero, afortunadamente, “casi todas estas suposiciones son discutibles o posiblemente evitables”, según el documento. (No nos encanta que diga casi todos.)

El documento actúa como un aviso sobre algunos problemas estructurales que los programadores deben tener en cuenta a medida que entrenan a las IA para objetivos cada vez más complejos.

Un apocalipsis de clips de papel inducido por IA

Es difícil exagerar cuán importante es este tipo de investigación. Hay un importante ejercicio de pensamiento en el campo de la ética y la filosofía de la IA sobre una IA enloquecida. El ejemplo citado arriba sobre los sujetapapeles no es una broma, o más bien no lo es. sólo una broma: al filósofo de la IA Nick Bostrom se le ocurrió transmitir cómo la creación de una IA superinteligente podría salir terriblemente mal, y desde entonces se ha convertido en un escenario famoso.

Digamos que un programador bien intencionado crea una IA cuyo objetivo es apoyar la fabricación de clips en una fábrica. Este es un papel muy creíble para una IA del futuro cercano, algo que requiere juicio y análisis, pero no es demasiado abierto. La IA incluso podría trabajar en conjunto con un gerente humano que manejaría los problemas que ocurren en el espacio de fabricación en tiempo real, así como dictaría la toma de decisiones final (al menos hasta que la IA encuentre una manera de burlarlos). Eso suena bien, ¿verdad? Es un buen ejemplo de cómo la IA podría ayudar a agilizar y mejorar la vida de los trabajadores industriales y sus gerentes, incluso.

Pero, ¿y si la IA no está programada con cuidado? Estas IA superinteligentes operarán en el mundo real, que los programadores consideran un “entorno desconocido”, porque no pueden planificar ni codificar en todos los escenarios posibles. El objetivo de usar estas IA de autoaprendizaje en primer lugar es hacer que ideen soluciones en las que los humanos nunca podrían pensar solos, pero eso conlleva el peligro de no saber qué podría pensar la IA.

¿Qué sucede si comienza a pensar en formas poco ortodoxas de aumentar la producción de clips? Una IA superinteligente podría aprender a hacer la mayor cantidad de clips por cualquier medio necesario.

¿Qué pasa si comienza a absorber otros recursos para convertirlos en clips, o decide, um, reemplazar su gerente humano? El ejemplo suena divertido en algunos aspectos: muchos expertos opinan que la IA seguirá siendo bastante primitiva durante un tiempo relativamente largo, sin la capacidad de “inventar” la idea de matar, robar o algo peor. Pero si se le diera rienda suelta a una IA lo suficientemente inteligente y creativa, la conclusión absurda del ejercicio de pensamiento es un sistema solar completo sin humanos vivos, completo con una esfera Dyson para recolectar energía para hacer nuevos clips por miles de millones.

Pero ese es solo un escenario de una IA que se vuelve loca, y los investigadores explican con gran detalle otras formas en que una IA podría piratear el sistema y trabajar de formas potencialmente “catastróficas” que nunca anticipamos.

Algunas soluciones posibles

Hay un problema de programación en juego aquí, que es la naturaleza de los supuestos en los que los investigadores de Oxford y la Universidad Nacional de Australia se han centrado en su artículo. Un sistema sin contexto externo debe prepararse con mucho cuidado para hacer bien una tarea y tener cierta autonomía. Existen estructuras lógicas y otros conceptos de programación que ayudarán a definir claramente el sentido de alcance y propósito de una IA. Muchas de estas son las mismas tácticas que usan los programadores hoy en día para evitar errores, como bucles infinitos, que pueden bloquear el software. Es solo que un paso en falso en una IA avanzada del futuro podría causar mucho más daño que un juego perdido.

Sin embargo, no todo está perdido. La IA todavía es algo que hacemos nosotros mismos, y los investigadores han señalado formas concretas en las que podemos ayudar a prevenir resultados adversos:

- Opta por el aprendizaje por imitación, donde la IA funciona imitando a los humanos en una especie de aprendizaje supervisado. Este es un tipo de IA completamente diferente y no tan útil, pero puede tener los mismos peligros potenciales.

- Haga que la IA priorice los objetivos que se pueden lograr en un corto período de tiempo, conocido como “miope”, en lugar de buscar soluciones poco ortodoxas (y potencialmente desastrosas) a largo plazo.

- Aísle la IA de redes externas como Internet, limitando la cantidad de información e influencia que puede adquirir.

- Utilice la cuantificación, un enfoque desarrollado por la experta en IA Jessica Taylor, donde la IA maximiza (u optimiza) las opciones similares a las humanas en lugar de las racionales abiertas.

- Código de aversión al riesgo dentro la IA, lo que hace que sea menos probable que se vuelva loco y deseche el statu quo a favor de la experimentación.

Pero también se reduce a la cuestión de si alguna vez podríamos controlar por completo una IA superinteligente que sea capaz de pensar por sí misma. ¿Qué pasa si nuestra peor pesadilla se hace realidad y un sensible ¿La IA tiene acceso a los recursos y a una gran red?

Da miedo imaginar un futuro en el que la IA pueda comenzar a hervir seres humanos para extraer sus oligoelementos y hacer clips. Pero al estudiar el problema directamente y en detalle, los investigadores pueden establecer mejores prácticas claras. para que los teóricos y los programadores sigan mientras continúan desarrollando una IA sofisticada.

Y realmente, ¿quién necesita tantos clips de todos modos?

Caroline Delbert es escritora, ávida lectora y editora colaboradora de Pop Mech. También es una entusiasta de casi todo. Sus temas favoritos incluyen la energía nuclear, la cosmología, las matemáticas de las cosas cotidianas y la filosofía de todo.