- En una carta al Congreso del 8 de junio, el CEO de IBM, Arvind Krishna, dijo que la compañía detendría toda investigación de reconocimiento facial, más la venta de software relacionado existente.

- Los departamentos de policía tienen acceso a estas herramientas gracias a firmas como Clearview AI, e IBM se pregunta si esas intervenciones son necesarias o no.

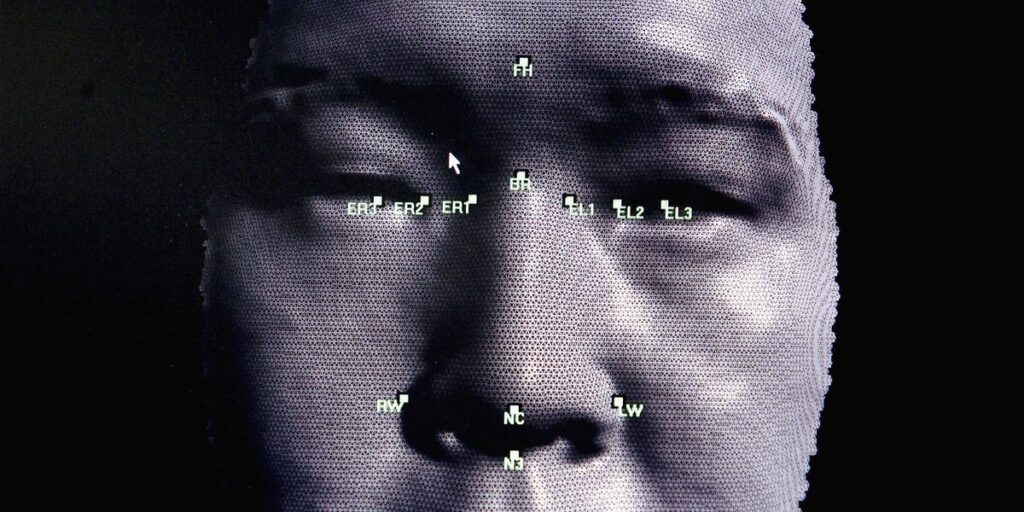

- Los algoritmos utilizados en el software de reconocimiento facial tienen una larga historia de prejuicios raciales.

IBM detendrá de inmediato toda investigación de reconocimiento facial y detendrá todas las ventas de su software relacionado existente, según una carta que el CEO Arvind Krishna envió al Congreso el lunes.

“IBM ya no ofrece software de análisis o reconocimiento facial IBM de propósito general”, escribió Krishna. “IBM se opone firmemente y no tolerará el uso de ninguna tecnología, incluida la tecnología de reconocimiento facial ofrecida por otros proveedores, para la vigilancia masiva, el perfil racial, las violaciones de los derechos humanos y las libertades básicas, o cualquier propósito que no sea coherente con nuestros valores y Principios de Confianza y transparencia. Creemos que ahora es el momento de comenzar un diálogo nacional sobre si las agencias nacionales de aplicación de la ley deberían emplear la tecnología de reconocimiento facial y cómo hacerlo “.

La medida se produce durante la tercera semana de protestas de Black Lives Matter en los Estados Unidos, provocada por el asesinato policial de George Floyd, un hombre negro que vive en Minneapolis, el 25 de mayo. Las autoridades que monitorean esas manifestaciones tienen acceso a herramientas de reconocimiento facial como el controvertido Clearview Plataforma de inteligencia artificial, e IBM está lidiando con si la policía debería o no poder usar el software.

Clearview AI cayó bajo un intenso escrutinio a principios de este año después de Los New York Times publicó una exposición que alegaba que la Oficina Federal de Investigaciones —y cientos de otras oficinas de aplicación de la ley— contrataron con la firma herramientas de vigilancia. Clearview AI presenta una base de datos de más de 3 mil millones de imágenes extraídas de sitios web como Facebook, Twitter e incluso Venmo, lo que significa que su rostro puede aparecer en el registro, incluso sin su permiso.

Estas herramientas de software también tienen una larga historia de sesgo algorítmico, lo que significa que la IA identifica erróneamente los rostros humanos debido a la raza, el género o la edad, según un informe de diciembre de 2019 del Instituto Nacional de Estándares y Tecnología. Ese estudio encontró que “la mayoría de los algoritmos de reconocimiento facial exhiben diferencias demográficas”.

El estudio NIST evaluó 189 algoritmos de software de 99 desarrolladores, que representan a la mayoría de la industria tecnológica invertida en software de reconocimiento facial. Los investigadores ponen los algoritmos en dos tareas: un ejercicio de correspondencia “uno a uno”, como desbloquear un teléfono inteligente o revisar un pasaporte; y un escenario de “uno a muchos”, en el que el algoritmo prueba una cara en una foto contra una base de datos.

Algunos de los resultados fueron inquietantes. En los ejercicios uno a uno, el NIST notó una mayor tasa de falsos positivos para los rostros asiáticos y afroamericanos en comparación con los rostros blancos. “Los diferenciales a menudo oscilaban entre un factor de 10 a 100 veces, dependiendo del algoritmo individual”, señalaron los autores. También vieron tasas más altas de falsos positivos para las mujeres afroamericanas, lo cual es “particularmente importante porque las consecuencias podrían incluir acusaciones falsas”.

Mientras tanto, un estudio de enero de 2018 evaluó tres plataformas comerciales de software de reconocimiento facial de IBM, Microsoft y Face ++. Al identificar rostros por género, cada oferta parecía funcionar bien, pero tras una inspección más cercana, los autores del estudio encontraron un sesgo desenfrenado. Por un lado, las compañías identificaron rostros masculinos con mucha más precisión, representando un diferencial de 8.1 por ciento a 20.6 por ciento.

Ese abismo se amplió aún más al identificar rostros femeninos de piel oscura. “Cuando analizamos los resultados por subgrupos interseccionales: machos más oscuros, hembras más oscuras, machos más claros, hembras más claras, vemos que todas las empresas tienen peores resultados en las hembras más oscuras”, dijeron los autores. IBM y Face ++ solo identificaron correctamente esas caras aproximadamente el 65 por ciento de las veces. Como resultado de ese estudio, IBM lanzó una declaración sobre su plataforma Watson Visual Recognition, prometiendo mejorar su servicio.

Para ser claros, el sesgo algorítmico no existe en un vacío de investigación, pero ya se ha abierto camino en el mundo real. Uno de los ejemplos más condenatorios proviene de un 2016 ProPublica Análisis del sesgo contra los acusados negros en las puntuaciones de riesgo penal, que se supone que predicen la reincidencia futura. En lugar, ProPublica descubrió que la fórmula utilizada por los tribunales y las juntas de libertad condicional está “escrita de una manera que garantiza que los acusados negros serán identificados incorrectamente como futuros delincuentes con más frecuencia que sus homólogos blancos”.

Y solo esta semana, el editor de noticias de inteligencia artificial de Microsoft, que está destinado a reemplazar a los humanos que ejecutan MSN.com, ilustró erróneamente una historia sobre el grupo de pop británico Little Mix. En la historia, la cantante Jade Thirlwall reflexionó sobre su propia experiencia con el racismo, pero irónicamente, la IA eligió una foto del otro miembro de la raza mixta, Leigh-Anne Pinnock.

“La inteligencia artificial es una herramienta poderosa que puede ayudar a la policía a mantener seguros a los ciudadanos”, dijo Krishna en su carta al Congreso. “Pero los vendedores y usuarios de los sistemas de Al tienen una responsabilidad compartida para garantizar que se realice una prueba de sesgo de Al, en particular cuando se utiliza en la aplicación de la ley, y que dichas pruebas de sesgo se auditen e informen”.

No se sabe si otras compañías que venden software de reconocimiento facial seguirán su ejemplo, pero es poco probable que alguna empresa que se especialice en el espacio, como Face ++, lo haga. Sin embargo, dado el silencio de Big Tech en medio de las protestas de George Floyd, la decisión de IBM de salir de la ecuación es un paso en la dirección correcta.

Este contenido es creado y mantenido por un tercero, e importado a esta página para ayudar a los usuarios a proporcionar sus direcciones de correo electrónico. Es posible que pueda encontrar más información sobre este y contenido similar en piano.io

Esta sección de comentarios es creada y mantenida por un tercero, e importada a esta página. Es posible que pueda encontrar más información en su sitio web.

Source link