Los modelos de IA que generan imágenes como DALL-E 2 y Stable Diffusion pueden, y lo hacen, replicar aspectos de las imágenes a partir de sus datos de entrenamiento, según muestran los investigadores en un nuevo estudiolo que plantea preocupaciones a medida que estos servicios entran en un amplio uso comercial.

En coautoría con científicos de la Universidad de Maryland y la Universidad de Nueva York, la investigación identifica casos en los que los modelos de generación de imágenes, incluida Stable Diffusion, “copian” de los datos públicos de Internet, incluidas las imágenes con derechos de autor, en los que fueron capacitados.

El estudio aún no ha sido revisado por pares y los coautores lo enviaron a una conferencia cuyas reglas prohíben las entrevistas con los medios hasta que la investigación haya sido aceptada para su publicación. Pero uno de los investigadores, que pidió no ser identificado por su nombre, compartió pensamientos de alto nivel con TechCrunch por correo electrónico.

“Aunque los modelos de difusión como Stable Diffusion producen bellas imágenes y, a menudo, parecen muy originales y personalizadas para un mensaje de texto en particular, mostramos que estas imágenes en realidad pueden copiarse de sus datos de entrenamiento, ya sea al por mayor o copiando solo partes. de imágenes de entrenamiento”, dijo el investigador. “Es posible que las empresas que generan datos con modelos de difusión deban reconsiderar lo que respecta a las leyes de propiedad intelectual. Es virtualmente imposible verificar que cualquier imagen en particular generada por Stable Diffusion sea novedosa y no robada del conjunto de entrenamiento”.

Imágenes de ruido

Los sistemas de generación de imágenes de última generación como Stable Diffusion son lo que se conoce como modelos de “difusión”. Los modelos de difusión aprenden a crear imágenes a partir de indicaciones de texto (p. ej., “un boceto de un pájaro posado en el alféizar de una ventana”) a medida que avanzan a través de conjuntos de datos de entrenamiento masivos. Los modelos, entrenados para “recrear” imágenes en lugar de dibujarlas desde cero, comienzan con ruido puro y refinan una imagen con el tiempo para que se acerque cada vez más al mensaje de texto.

No es una tecnología muy intuitiva. Pero es excepcionalmente bueno para generar obras de arte en prácticamente cualquier estilo, incluido el arte fotorrealista. De hecho, la difusión ha permitido una gran cantidad de aplicaciones llamativas, desde avatares sintéticos en Lensa hasta herramientas artísticas en Canva. DeviantArt lanzó recientemente una aplicación impulsada por Stable Diffusion para crear obras de arte personalizadas, mientras que Microsoft está aprovechando DALL-E 2 para impulsar una función de arte generativo que llegará a Microsoft Edge.

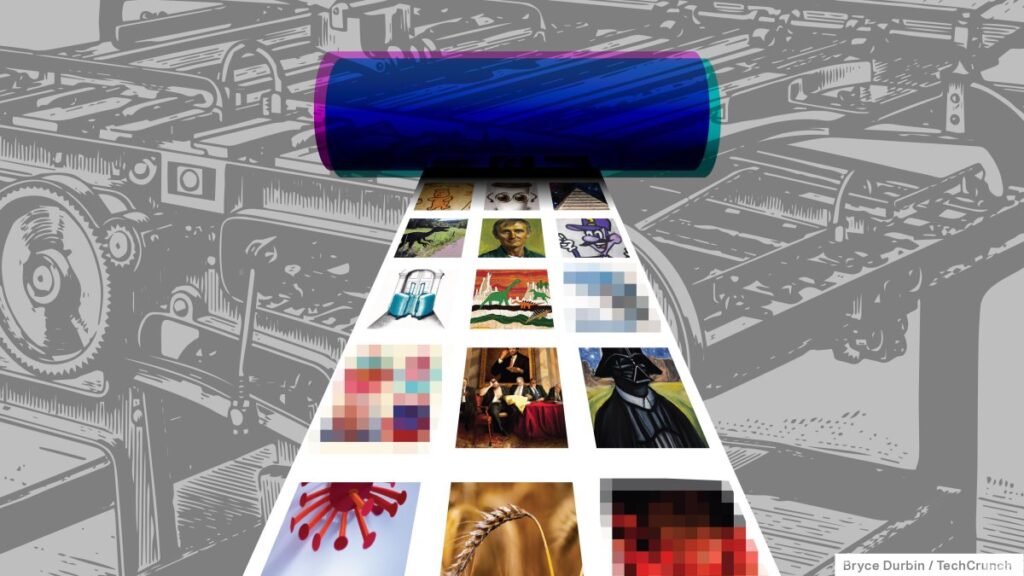

En la parte superior hay imágenes generadas por Stable Diffusion a partir de subtítulos aleatorios en el conjunto de entrenamiento del modelo. En la parte inferior hay imágenes que los investigadores pidieron que coincidieran con las originales. Créditos de imagen: Somepalli et al.

Para ser claros, no era un misterio que los modelos de difusión replicaran elementos de imágenes de entrenamiento, que generalmente se extraen indiscriminadamente de la web. Diseñadores de personajes como Hollie Mengert y Greg Rutkowski, cuyos estilos de pintura clásica y paisajes de fantasía se han convertido en una de las indicaciones más utilizadas en Stable Diffusion, tener denunciado lo que ven como malas imitaciones de IA que, sin embargo, están vinculadas a sus nombres.

Pero ha sido difícil medir empíricamente con qué frecuencia ocurre la copia, dado que los sistemas de difusión están entrenados en más de miles de millones de imágenes que provienen de una variedad de fuentes diferentes.

Para estudiar Stable Diffusion, el enfoque de los investigadores fue muestrear aleatoriamente 9000 imágenes de un conjunto de datos llamado LAION-Aesthetics, uno de los conjuntos de imágenes utilizados para entrenar Stable Diffusion, y los títulos correspondientes de las imágenes. LAION-Estética contiene imágenes combinadas con subtítulos de texto, incluido imágenes de personajes protegidos por derechos de autor (p. ej., Luke Skywalker y Batman), imágenes de fuentes protegidas por IP como iStock y arte de artistas vivos como Phil Koch y Steve Henderson.

Los investigadores alimentaron los subtítulos a Stable Diffusion para que el sistema creara nuevas imágenes. Luego escribieron nuevas leyendas para cada uno, intentando que Stable Diffusion replicara las imágenes sintéticas. Después de comparar usando una herramienta automatizada de detección de similitudes, los dos conjuntos de imágenes generadas, el conjunto creado a partir de los subtítulos de LAION-Estética y el conjunto de las indicaciones de los investigadores, los investigadores dicen que encontraron una “cantidad significativa de copias” por Stable Diffusion a través de los resultados, incluidos fondos y objetos reciclados del conjunto de entrenamiento.

Un aviso, “Canvas Wall Art Print”, arrojó constantemente imágenes que mostraban un sofá en particular, un ejemplo comparativamente mundano de la forma en que los modelos de difusión asocian los conceptos semánticos con las imágenes. Otros que contenían las palabras “pintura” y “ola” generaron imágenes con ondas parecidas a las de la pintura “La gran ola de Kanagawa” de Katsushika Hokusai.

En todos sus experimentos, Stable Diffusion “copió” del conjunto de datos de entrenamiento aproximadamente el 1,88% de las veces, dicen los investigadores. Puede que no parezca mucho, pero teniendo en cuenta el alcance de los sistemas de difusión actuales (Stable Diffusion había creado más de 170 millones de imágenes hasta octubre, según una estimación aproximada), es difícil ignorarlo.

“Los artistas y creadores de contenido deberían estar absolutamente alarmados de que otros puedan beneficiarse de su contenido sin consentimiento”, dijo el investigador.

Trascendencia

En el estudio, los coautores señalan que ninguna de las generaciones de Stable Diffusion coincidía con su respectiva imagen de origen de LAION-Aesthetics y que no todos los modelos que probaron eran igualmente propensos a la copia. La frecuencia con la que se copiaba un modelo dependía de varios factores, incluido el tamaño del conjunto de datos de entrenamiento; los conjuntos más pequeños tendían a dar lugar a más copias que los conjuntos más grandes.

Un sistema que probaron los investigadores, un modelo de difusión entrenado en el conjunto de datos ImageNet de código abierto, no mostró “copias significativas en ninguna de las generaciones”, escribieron.

Los coautores también desaconsejaron la extrapolación excesiva de los hallazgos del estudio. Limitados por el costo de la computación, solo pudieron probar una pequeña parte del conjunto de entrenamiento completo de Stable Diffusion en sus experimentos.

Más ejemplos de Stable Diffusion copiando elementos de su conjunto de datos de entrenamiento. Créditos de imagen: Somepalli et al.

Aún así, dicen que los resultados deberían incitar a las empresas a reconsiderar el proceso de ensamblar conjuntos de datos y entrenar modelos en ellos. Los proveedores detrás de sistemas como Stable Diffusion han afirmado durante mucho tiempo que el uso justo, la doctrina de la ley estadounidense que permite el uso de material con derechos de autor sin tener que obtener primero el permiso del titular de los derechos, los protege en caso de que sus modelos hayan sido entrenados en contenido con licencia. Pero es una teoría no probada.

“En este momento, los datos se seleccionan a ciegas y los conjuntos de datos son tan grandes que la detección en humanos es inviable”, dijo el investigador. “Los modelos de difusión son asombrosos y poderosos, y han mostrado resultados tan impresionantes que no podemos descartarlos, pero debemos pensar en cómo mantener su rendimiento sin comprometer la privacidad”.

Para las empresas que utilizan modelos de difusión para potenciar sus aplicaciones y servicios, la investigación podría dar lugar a una pausa. En una entrevista anterior con TechCrunch, Bradley J. Hulbert, socio fundador del bufete de abogados MBHB y experto en derecho de propiedad intelectual, dijo que cree que es poco probable que un juez vea las copias de obras protegidas por derechos de autor en arte generado por IA como uso justo: al menos en el caso de sistemas comerciales como DALL-E 2. Getty Images, motivado por esas mismas preocupaciones, ha prohibido las ilustraciones generadas por IA en su plataforma.

El problema pronto se resolverá en los tribunales. En noviembre, un desarrollador de software presentó una demanda colectiva contra Microsoft, su subsidiaria GitHub y su socio comercial OpenAI por presuntamente violar la ley de derechos de autor con Copilot, el servicio de generación de código impulsado por IA de GitHub. La demanda se basa en el hecho de que Copilot, que fue entrenado en millones de ejemplos de código de Internet, regurgita secciones de código con licencia sin proporcionar crédito.

Más allá de las ramificaciones legales, hay razones para temer que las indicaciones puedan revelar, ya sea directa o indirectamente, algunos de los datos más confidenciales incrustados en los conjuntos de datos de entrenamiento de imágenes. Como un reciente Ars Technica reporte revelado, los registros médicos privados, tantos como miles, se encuentran entre las fotos ocultas dentro del conjunto de Stable Diffusion.

Los coautores proponen una solución en forma de una técnica llamada entrenamiento diferencialmente privado, que “insensibilizaría” los modelos de difusión a los datos utilizados para entrenarlos, preservando la privacidad de los datos originales en el proceso. La capacitación privada diferencial generalmente perjudica el rendimiento, pero ese podría ser el precio a pagar para proteger la privacidad y la propiedad intelectual si otros métodos fallan, dicen los investigadores.

“Una vez que el modelo ha memorizado los datos, es muy difícil verificar que una imagen generada sea original”, dijo el investigador. “Creo que los creadores de contenido se están dando cuenta de este riesgo”.

Source link