Tik Tok ha tomado medidas enérgicas contra el contenido relacionado con QAnon, en línea con movimientos similares de otras importantes empresas de redes sociales, incluidas Facebook y YouTube, que se centran en reducir la difusión de la teoría de la conspiración sin fundamento en sus respectivas plataformas. Según un informe de NPR este fin de semana, TikTok había prohibido silenciosamente varios hashtags asociados con la conspiración de QAnon, y dice que también eliminará las cuentas de los usuarios que promueven el contenido de QAnon.

Tiktok nos dice, sin embargo, que estas políticas no son nuevas. La compañía dice que en realidad se incorporaron a los libros a principios de este año.

TikTok se había centrado inicialmente en reducir la capacidad de descubrimiento como un paso inmediato al bloquear los resultados de búsqueda mientras investigaba, con la ayuda de los socios, cómo se manifestaba dicho contenido en su plataforma. Esto fue cubierto en julio por varias publicaciones de noticias, dijo TikTok. En agosto, TikTok también estableció una política para eliminar contenido y prohibir cuentas, nos dijeron.

A pesar de las políticas, un informe de este mes de Media Matters documentó que TikTok todavía albergaba al menos 14 hashtags no afiliados a QA con más de 488 millones de visitas colectivas. Estos se produjeron porque la plataforma aún tenía que abordar cómo los seguidores de QAnon eludían las restricciones de la comunidad mediante variaciones y errores ortográficos.

Después del informe de Media Matters, TikTok eliminó 11 de los 14 hashtags a los que había hecho referencia, señaló el informe en una actualización.

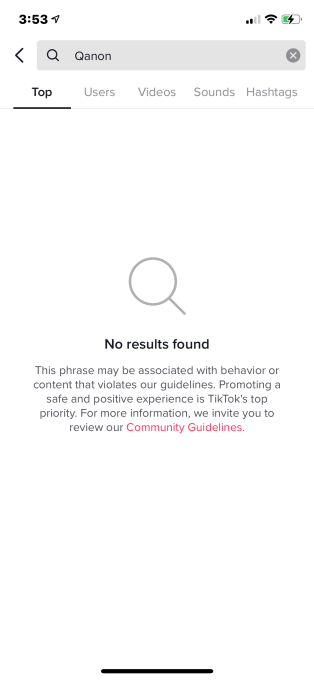

Hoy en día, varios hashtags relacionados con QAnon, como #QAnon, #TheStormIsComing, # Trump2Q2Q ”y otros, no arrojan resultados en el motor de búsqueda de TikTok. No se muestran en la sección de resultados de búsqueda “Principales”, ni se muestran en “Vídeos” o “Hashtags”.

En lugar de mostrar a los usuarios una página en blanco cuando se buscan estos términos, TikTok muestra un mensaje que explica cómo algunas frases pueden asociarse con un comportamiento o contenido que viola las Pautas de la comunidad de TikTok, y ofrece un enlace a ese recurso.

Créditos de imagen: Captura de pantalla de TikTok a través de TechCrunch

Media Matters elogió los cambios en una declaración a NPR como algo que TikTok estaba haciendo que era “bueno y significativo”, incluso si estaba “muy retrasado”.

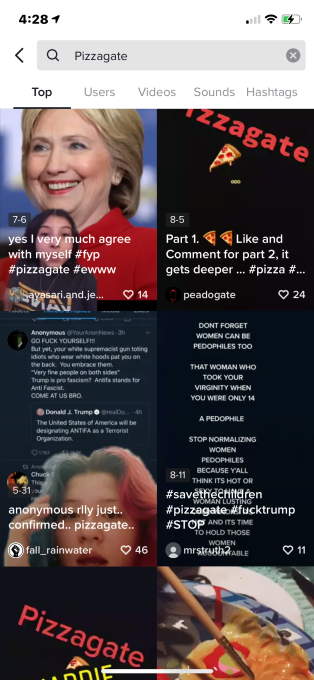

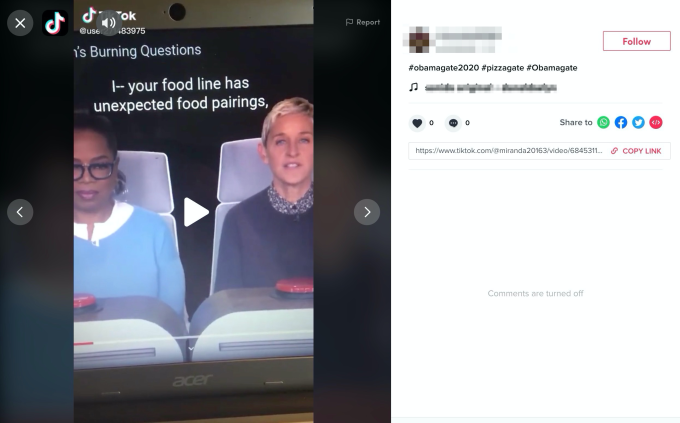

Si bien la prohibición de TikTok abordó muchos de los principales resultados de búsqueda y etiquetas asociadas con la conspiración, descubrimos que pasaba por alto otros, como Pizzagate y WWG1WGA, por ejemplo. En las pruebas de esta tarde, estos términos y muchos otros todavía arrojaron mucho contenido.

TikTok afirma que lo que vimos probablemente fue “un error”.

Hoy nos habíamos comunicado con TikTok para preguntar por qué las búsquedas de términos como “pizzagate” y “WWG1WGA”, términos populares de QAnon, seguían arrojando resultados de búsqueda, a pesar de que sus hashtags estaban prohibidos.

Por ejemplo, si solo buscó “pizzagate”, TikTok ofreció una larga lista de videos para desplazarse, aunque no podría ir directamente a su hashtag. Este no fue el caso de los otros hashtags prohibidos (como #QAnon) en el momento de nuestras pruebas.

Créditos de imagen: Captura de pantalla de TikTok a través de TechCrunch

Los videos regresaron discutiendo la conspiración de Pizzagate, una teoría de la conspiración sin fundamento que finalmente condujo a la violencia en el mundo real cuando un hombre armado disparó un negocio de pizzas en DC, pensando que estaba allí para rescatar a niños atrapados.

Si bien algunos videos solo discutían o desacreditaban la idea, muchos promocionaban seriamente la conspiración de pizzagate, incluso publicaban que era “real” o que se decía que ofrecía “pruebas”.

Arriba: video grabado el 19 de octubre de 2020, 3:47 p.m. ET / 12:47 p.m. PT

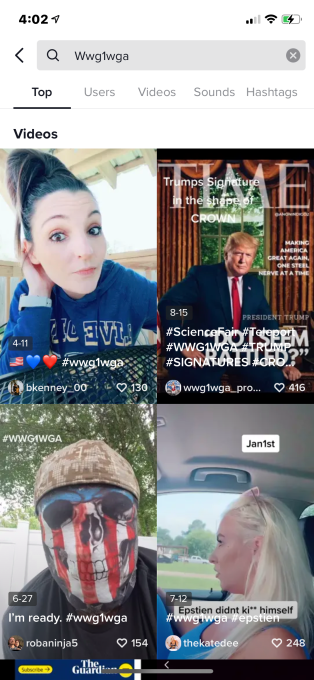

Otros hashtags asociados a QAnon tampoco estaban sujetos a una prohibición total, incluidos WWG1WGA, WGA, ThesePeopleAreSick, cannibalclub, hollyweird y muchos otros que se utilizan a menudo para hacer circular las conspiraciones de QAnon.

Cuando buscamos estos términos, encontramos listas más largas de videos relacionados con QAnon para desplazarnos.

Documentamos esto con fotos y videos antes de comunicarnos con TikTok para preguntar por qué se habían hecho excepciones a la prohibición. Preguntamos específicamente sobre los dos términos principales: Pizzagate y WWG1WGA.

Créditos de imagen: Captura de pantalla de TikTok a través de TechCrunch

TikTok nos proporcionó información sobre el cronograma de sus cambios de política y la siguiente declaración:

“El contenido y las cuentas que promueven QAnon violan nuestra política de desinformación y los eliminamos de nuestra plataforma. También hemos tomado medidas importantes para hacer que este contenido sea más difícil de encontrar en búsquedas y hashtags al redirigir los términos asociados a nuestras Normas de la comunidad. Actualizamos continuamente nuestras salvaguardas con errores ortográficos y nuevas frases mientras trabajamos para que TikTok sea un lugar seguro y auténtico para nuestra comunidad “.

TikTok también dijo que el bloqueo de términos de búsqueda debe haber sido un error, porque ahora está funcionando correctamente.

Descubrimos que, al recibir la confirmación de TikTok, los términos por los que preguntamos estaban bloqueados, pero otros no. Esto incluye algunos de los mencionados anteriormente, así como términos extraños que solo un verdadero fanático de la conspiración sabría, como adrenochromereptilians.

Le preguntamos a Media Matters si aún podría elogiar las acciones de TikTok para prohibir el contenido de QAnon, dado lo que, en ese momento, parecía ser una laguna en la prohibición de QAnon.

“TikTok, por supuesto, ha tomado medidas, pero no ha resuelto completamente el problema, pero como hemos señalado, la verdadera prueba de cualquiera de estas políticas, como hemos dicho sobre las medidas de otras plataformas, está en cómo y si las hacen cumplir”. dijo la organización.

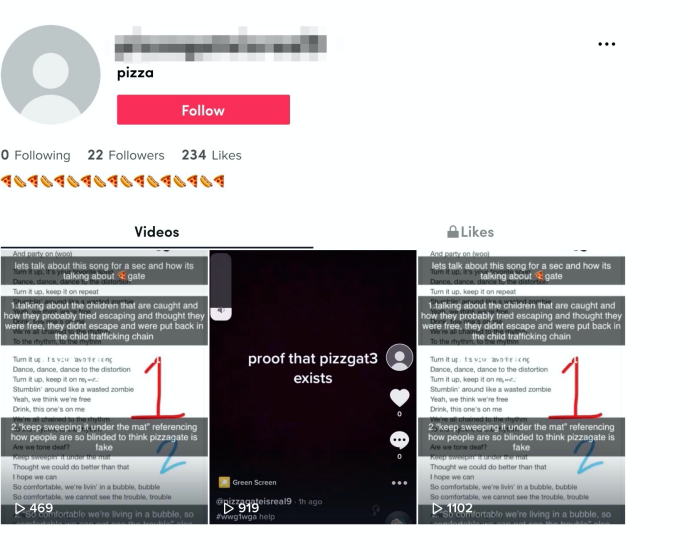

Incluso si el contenido prohibido solo se mostraba hoy debido a un “error”, al parecer, muchos de los usuarios que publicaron el contenido no lo han prohibido en TikTok.

Aunque una búsqueda de su nombre de usuario no arrojará resultados ahora que la prohibición ya no tiene “errores”, aún puede ir directamente a las páginas de perfil de estos usuarios a través de la URL de su perfil en la web.

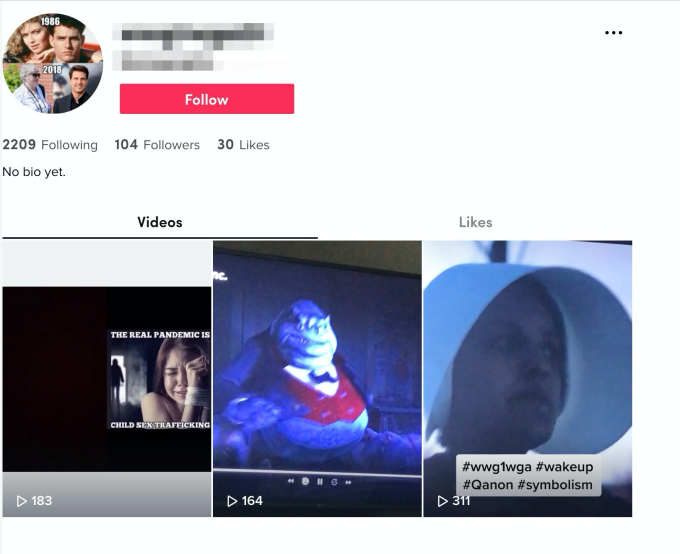

Probamos esto en muchos perfiles que habían publicado contenido de QAnon o habían usado términos prohibidos en los hashtags y descripciones de sus videos. (A continuación se muestran algunos ejemplos).

Lo que esto significa es que, aunque TikTok redujo la visibilidad de estos usuarios en la aplicación, las cuentas aún se pueden ubicar si conoce su nombre de usuario. Y una vez que llegue a la página de la cuenta, podrá seguirlos.

Créditos de imagen: Captura de pantalla de TikTok a través de TechCrunch

Créditos de imagen: Captura de pantalla de TikTok a través de TechCrunch

Créditos de imagen: Captura de pantalla de TikTok a través de TechCrunch

Estos ejemplos de “errores” o simplemente descuidos indican lo difícil que es hacer cumplir las prohibiciones de contenido en las plataformas de redes sociales.

Sin inversiones sustanciales en moderación humana combinada con automatización, así como herramientas que garanticen que los usuarios prohibidos no puedan regresar, es difícil mantenerse al día con la propagación de la desinformación a escala de las redes sociales.