Cada imagen publicada en Facebook e Instagram recibe un título generado por una IA de análisis de imágenes, y esa IA se ha vuelto mucho más inteligente. El sistema mejorado debería ser un placer para los usuarios con discapacidad visual y puede ayudarlo a encontrar sus fotos más rápido en el futuro.

El texto alternativo es un campo en los metadatos de una imagen que describe su contenido: “Una persona parada en un campo con un caballo” o “un perro en un bote”. Esto permite que la imagen sea entendida por personas que no pueden verla.

Estas descripciones suelen ser agregadas manualmente por un fotógrafo o una publicación, pero las personas que suben fotos a las redes sociales generalmente no se molestan, si es que tienen la opción. Por lo tanto, la capacidad relativamente reciente de generar uno automáticamente (la tecnología recién se ha vuelto lo suficientemente buena en los últimos dos años) ha sido extremadamente útil para hacer que las redes sociales sean más accesibles en general.

Facebook creó su sistema de texto alternativo automático en 2016, que data de hace eones en el campo del aprendizaje automático. Desde entonces, el equipo ha preparado muchas mejoras, haciéndolo más rápido y más detallado, y la última actualización agrega una opción para generar una descripción más detallada a pedido.

El sistema mejorado reconoce 10 veces más elementos y conceptos que al principio, ahora alrededor de 1200. Y las descripciones incluyen más detalles. Lo que antes era “Dos personas junto a un edificio” ahora puede ser “Una selfie de dos personas junto a la Torre Eiffel”. (Las descripciones reales se protegen con “puede ser …” y evitarán incluir conjeturas descabelladas).

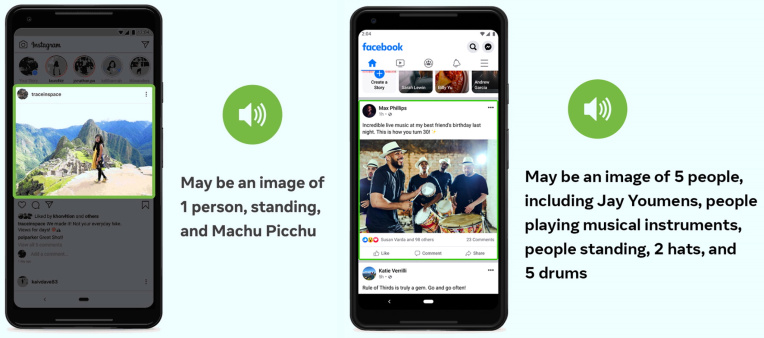

Pero hay más detalles que eso, incluso si no siempre es relevante. Por ejemplo, en esta imagen, la IA observa las posiciones relativas de las personas y los objetos:

Créditos de imagen: Facebook

Obviamente, la gente está por encima de los tambores y los sombreros están por encima de la gente, nada de lo cual realmente necesita ser dicho para que alguien entienda la esencia. Pero considere una imagen descrita como “Una casa y algunos árboles y una montaña”. ¿La casa está en la montaña o frente a ella? ¿Están los árboles delante o detrás de la casa, o quizás en la montaña a lo lejos?

Para describir adecuadamente la imagen, estos detalles deben completarse, incluso si la idea general se puede transmitir con menos palabras. Si una persona vidente quiere más detalles, puede mirar más de cerca o hacer clic en la imagen para ver una versión más grande; alguien que no pueda hacer eso ahora tiene una opción similar con este comando “generar descripción detallada de la imagen”. (Actívelo con una pulsación larga en la aplicación de Android o una acción personalizada en iOS).

Quizás la nueva descripción sería algo así como “Una casa y algunos árboles frente a una montaña con nieve”. Eso pinta una mejor imagen, ¿verdad? (Para ser claros, estos ejemplos son inventados, pero es el tipo de mejora que se espera).

La nueva función de descripción detallada llegará primero a Facebook para ser probada, aunque el vocabulario mejorado aparecerá pronto en Instagram. Las descripciones también se mantienen simples para que se puedan traducir fácilmente a otros idiomas que ya son compatibles con las aplicaciones, aunque es posible que la función no se implemente en otros países simultáneamente.