Cuando pueden, los humanos usan sus sentidos en tándem. Al escuchar una voz, una persona se da vuelta para ver si es su amigo. Tocar un objeto puede ofrecer información táctil, pero verlo puede confirmar su verdadera identidad. Pero los robots no pueden usar sus sentidos en tándem tan fácilmente, por lo que los científicos del Laboratorio de Inteligencia Artificial y Computación (CSAIL, por sus siglas en inglés) del MIT han trabajado para corregir lo que denominan una "brecha sensorial" robótica.

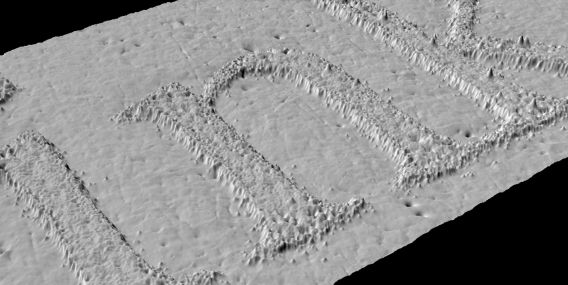

Para conectar la vista y el tacto, los ingenieros de CSAIL trabajaron con un brazo de robot KUKA, un tipo que se usa a menudo en los almacenes industriales. Los científicos lo equiparon con un sensor táctil especial llamado GelSight, una placa de caucho sintético transparente que funciona como un sistema de imágenes. Los objetos se presionan en GelSight, y luego las cámaras que rodean la losa monitorean las impresiones.

Con una cámara web común, el equipo de CSAIL registró casi 200 objetos, incluidas herramientas, productos para el hogar y telas que fueron tocadas por el brazo del robot más de 12,000 veces. Eso creó una serie de videoclips que el equipo pudo dividir en 3 millones de imágenes estáticas, creando un conjunto de datos que denominaron "VisGel".

"Al mirar la escena, nuestro modelo puede imaginar la sensación de tocar una superficie plana o un borde afilado", dice Yunzhu Li, Ph.D. de CSAIL. estudiante y autor principal en un nuevo artículo sobre el sistema, en un comunicado de prensa.

"Al tocar a ciegas", dice Li, "nuestro modelo puede predecir la interacción con el entorno únicamente a partir de sentimientos táctiles. "Reunir estos dos sentidos podría empoderar al robot y reducir los datos que podríamos necesitar para tareas que involucren la manipulación y la comprensión de objetos".

El equipo de CSAIL luego combinó el conjunto de datos de VisGel con lo que se conoce como redes de confrontación generativa o GAN. Las GAN son arquitecturas de redes neuronales profundas que se componen de dos redes, según un explicador de la compañía de inteligencia artificial Skymind, con el potencial de imitar imágenes, música, habla y prosa. A menudo se asocian con los usos artísticos de la IA. En 2018, la casa de subastas Christie's vendió una pintura generada por un GAN por $ 432,000.

Los GAN trabajan con dos redes neuronales en competencia entre sí. Una red se considera el "generador", mientras que la otra se llama el "discriminador". El generador crea imágenes que intenta hacer parecer real; El discriminador intenta probar que las imágenes son creadas. Cada vez que el discriminador gana la batalla, el generador se ve obligado a examinar su propia lógica interna, creando y, con suerte, perfeccionando un sistema mejor.

Combinados, los ingenieros de CSAIL intentaron hacer que su sistema fuera alucinado o crear una imagen visual basada únicamente en datos táctiles. Cuando se alimenta con datos táctiles de un zapato, la IA intentaría recrear cómo se veía ese zapato.

"Este es el primer método que se puede traducir de manera convincente entre señales visuales y táctiles", dice Andrew Owens, un postdoctorado en la Universidad de California en Berkeley. "Los métodos como este tienen el potencial de ser muy útiles para la robótica, donde necesitas responder preguntas como '¿este objeto es duro o blando?' O 'si levanto esta taza por su asa, ¿qué tan bueno será mi agarre?' Este es un problema muy desafiante, ya que las señales son muy diferentes y este modelo ha demostrado una gran capacidad ".

Los proyectos CSAIL a menudo se centran en la reducción de las divisiones digitales. Un proyecto el año pasado permitió que las IA se corrigieran a través del pensamiento humano.

Fuente: TechCrunch

Source link