La investigación en el campo del aprendizaje automático y la IA, ahora una tecnología clave en prácticamente todas las industrias y empresas, es demasiado voluminosa para que alguien la lea en su totalidad. Esta columna, Perceptron, tiene como objetivo recopilar algunos de los descubrimientos y documentos recientes más relevantes, particularmente en inteligencia artificial, entre otros, y explicar por qué son importantes.

En las últimas semanas, los investigadores de Google han demostrado un sistema de inteligencia artificial, PaLI, que puede realizar muchas tareas en más de 100 idiomas. En otra parte, un grupo con sede en Berlín lanzó un proyecto llamado Fuente+ eso está diseñado como una forma de permitir que los artistas, incluidos los artistas visuales, músicos y escritores, opten por permitir y no permitir que su trabajo se use como datos de entrenamiento para la IA.

Los sistemas de IA como GPT-3 de OpenAI pueden generar texto bastante sensato o resumir texto existente de la web, libros electrónicos y otras fuentes de información. Pero históricamente se han limitado a un solo idioma, lo que limita tanto su utilidad como su alcance.

Afortunadamente, en los últimos meses, la investigación sobre sistemas multilingües se ha acelerado, impulsada en parte por esfuerzos comunitarios como Hugging Face’s Bloom. En un intento de aprovechar estos avances en el multilingüismo, un equipo de Google creó PaLI, que fue capacitado tanto en imágenes como en texto para realizar tareas como subtítulos de imágenes, detección de objetos y reconocimiento óptico de caracteres.

Créditos de imagen: Google

Google afirma que PaLI puede comprender 109 idiomas y las relaciones entre las palabras en esos idiomas y las imágenes, lo que le permite, por ejemplo, subtitular una imagen de una postal en francés. Si bien el trabajo permanece firmemente en las fases de investigación, los creadores dicen que ilustra la importante interacción entre el lenguaje y las imágenes, y podría establecer una base para un producto comercial en el futuro.

El habla es otro aspecto del lenguaje en el que la IA mejora constantemente. Play.ht mostró recientemente un nuevo modelo de texto a voz que pone una notable cantidad de emoción y variedad en sus resultados. Los clips que publicó la semana pasada. Suenan fantásticos, aunque, por supuesto, están cuidadosamente seleccionados.

Generamos un clip propio usando la introducción de este artículo, y los resultados siguen siendo sólidos:

Todavía no está claro exactamente para qué será más útil este tipo de generación de voz. Todavía no estamos en la etapa en la que hacen libros completos, o mejor dicho, pueden hacerlo, pero puede que todavía no sea la primera opción de nadie. Pero a medida que aumenta la calidad, las aplicaciones se multiplican.

Mat Dryhurst y Holly Herndon, académico y músico, respectivamente, se asociaron con la organización Spawning para lanzar Source+, un estándar que esperan llame la atención sobre el problema de los sistemas de IA que generan fotografías creados con obras de arte de artistas que no estaban informados o pidió permiso. Source+, que no cuesta nada, tiene como objetivo permitir que los artistas no permitan que su trabajo se use con fines de entrenamiento de IA si así lo desean.

Los sistemas de generación de imágenes como Stable Diffusion y DALL-E 2 se entrenaron en miles de millones de imágenes extraídas de la web para “aprender” a traducir indicaciones de texto en arte. Algunas de estas imágenes provienen de comunidades de arte público como ArtStation y DeviantArt, no necesariamente con el conocimiento de los artistas, e imbuyeron los sistemas con la capacidad de imitar a creadores particulares. incluido artistas como Greg Rutowski.

Muestras de difusión estable.

Debido a la habilidad de los sistemas para imitar estilos artísticos, algunos creadores temen que puedan amenazar los medios de subsistencia. Source+, si bien es voluntario, podría ser un paso para dar a los artistas una mayor opinión sobre cómo se usa su arte, dicen Dryhurst y Herndon, suponiendo que se adopte a escala (un gran si).

En DeepMind, un equipo de investigación está intentando para resolver otro aspecto problemático de larga data de la IA: su tendencia a arrojar información tóxica y engañosa. Centrándose en el texto, el equipo desarrolló un chatbot llamado Sparrow que puede responder preguntas comunes al buscar en la web con Google. Otros sistemas de vanguardia como LaMDA de Google pueden hacer lo mismo, pero DeepMind afirma que Sparrow brinda respuestas plausibles y no tóxicas a las preguntas con más frecuencia que sus contrapartes.

El truco estaba en alinear el sistema con las expectativas de la gente. DeepMind reclutó a personas para usar Sparrow y luego les pidió que proporcionaran comentarios para entrenar un modelo de cuán útiles fueron las respuestas, mostrando a los participantes múltiples respuestas a la misma pregunta y preguntándoles qué respuesta les gustó más. Los investigadores también definieron reglas para Sparrow, como “no hacer declaraciones amenazantes” y “no hacer comentarios de odio o insultos”, que hicieron que los participantes impusieran al sistema tratando de engañarlo para que rompiera las reglas.

Ejemplo del gorrión de DeepMind teniendo una conversación.

DeepMind reconoce que Sparrow tiene margen de mejora. Pero en un estudio, el equipo descubrió que el chatbot proporcionó una respuesta “plausible” respaldada con evidencia el 78 % de las veces cuando se le hizo una pregunta objetiva y solo rompió las reglas antes mencionadas el 8 % de las veces. Eso es mejor que el sistema de diálogo original de DeepMind, señalan los investigadores, que rompía las reglas aproximadamente tres veces más a menudo cuando se engañaba para hacerlo.

Un equipo separado en DeepMind abordó un dominio muy diferente recientemente: los videojuegos que históricamente han sido difíciles de dominar rápidamente para la IA. Su sistema, descaradamente llamado MEMEsupuestamente logró un rendimiento de “nivel humano” en 57 juegos diferentes de Atari 200 veces más rápido que el mejor sistema anterior.

De acuerdo con el artículo de DeepMind que detalla MEME, el sistema puede aprender a jugar observando aproximadamente 390 millones de fotogramas, “fotogramas” que se refieren a las imágenes fijas que se actualizan muy rápidamente para dar la impresión de movimiento. Eso puede parecer mucho, pero la técnica de vanguardia anterior requería 80 mil millones de fotogramas en la misma cantidad de juegos de Atari.

Créditos de imagen: Mente profunda

Jugar hábilmente a Atari puede no parecer una habilidad deseable. Y de hecho, algunos críticos argumentan que los juegos son un punto de referencia defectuoso de la IA debido a su abstracción y relativa simplicidad. Pero los laboratorios de investigación como DeepMind creen que los enfoques podrían aplicarse a otras áreas más útiles en el futuro, como los robots que aprenden a realizar tareas de manera más eficiente viendo videos o autos que se conducen solos y se mejoran a sí mismos.

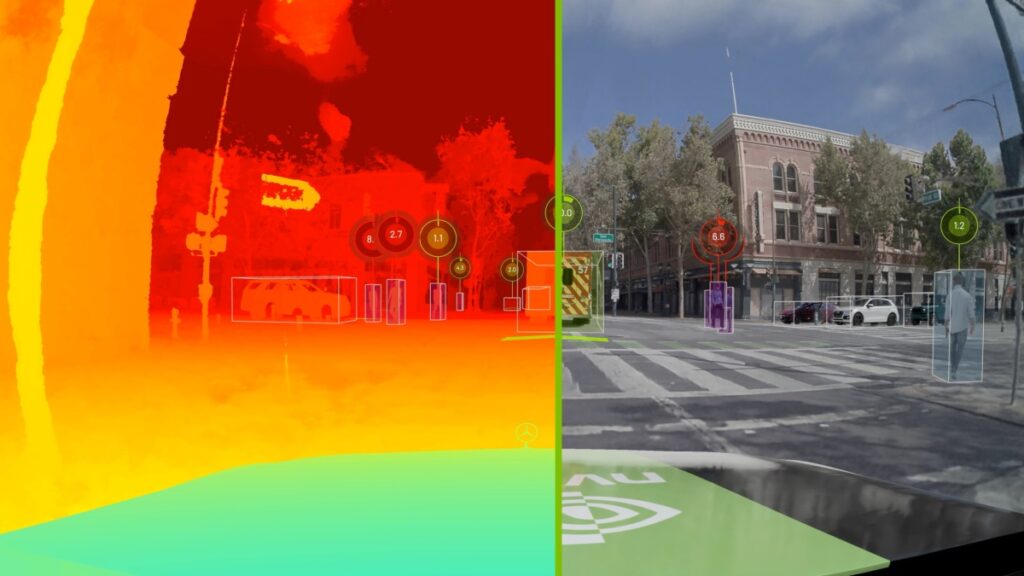

Nvidia tuvo un día de campo el día 20 anunciando docenas de productos y servicios, entre ellos varios esfuerzos interesantes de IA. Los autos sin conductor son uno de los enfoques de la compañía, tanto para impulsar la IA como para entrenarla. Para estos últimos, los simuladores son cruciales y también es importante que las carreteras virtuales se parezcan a las reales. Describen un flujo de contenido nuevo y mejorado que acelera la transferencia de datos recopilados por cámaras y sensores en automóviles reales al ámbito digital.

Un entorno de simulación basado en datos del mundo real.

Cosas como los vehículos del mundo real y las irregularidades en la carretera o la cubierta de árboles se pueden reproducir con precisión, por lo que la IA autónoma no aprende en una versión desinfectada de la calle. Y hace posible crear configuraciones de simulación más grandes y variables en general, lo que ayuda a la robustez. (Otra imagen de él está arriba).

Nvidia también presentó su sistema IGX para plataformas autónomas en situaciones industriales — colaboración hombre-máquina como la que podría encontrar en una fábrica. No hay escasez de estos, por supuesto, pero a medida que aumenta la complejidad de las tareas y los entornos operativos, los métodos antiguos ya no son suficientes y las empresas que buscan mejorar su automatización están buscando pruebas de futuro.

Ejemplo de visión por computadora que clasifica objetos y personas en el piso de una fábrica.

La seguridad “proactiva” y “predictiva” es con lo que IGX pretende ayudar, es decir, detectar problemas de seguridad antes de que causen interrupciones o lesiones. Un bot puede tener su propio mecanismo de parada de emergencia, pero si una cámara que monitorea el área pudiera indicarle que se desvíe antes de que una carretilla elevadora se interponga en su camino, todo resultará un poco más fluido. Exactamente qué compañía o software logra esto (y en qué hardware, y cómo se paga todo) todavía es un trabajo en progreso, con empresas como Nvidia y nuevas empresas como Veo Robotics abriéndose paso.

Otro interesante paso adelante se dio en el terreno de juego de Nvidia. Las últimas y mejores GPU de la compañía están diseñadas no solo para impulsar triángulos y sombreadores, sino también para realizar rápidamente tareas impulsadas por IA como su propia tecnología DLSS para mejorar y agregar marcos.

El problema que están tratando de resolver es que los motores de juegos son tan exigentes que generar más de 120 fotogramas por segundo (para mantenerse al día con los monitores más recientes) mientras se mantiene la fidelidad visual es una tarea hercúlea que incluso las GPU potentes apenas pueden hacer. Pero DLSS es una especie de mezclador de cuadros inteligente que puede aumentar la resolución del cuadro de origen sin alias ni artefactos, por lo que el juego no tiene que empujar tantos píxeles.

En DLSS 3, Nvidia afirma que puede generar fotogramas adicionales completos en una proporción de 1:1, por lo que podría renderizar 60 fotogramas de forma natural y los otros 60 mediante IA. Puedo pensar en varias razones que podrían hacer que las cosas sean raras en un entorno de juego de alto rendimiento, pero Nvidia probablemente las conozca. En cualquier caso, deberá pagar alrededor de mil por el privilegio de usar el nuevo sistema, ya que solo se ejecutará en tarjetas de la serie RTX 40. Pero si la fidelidad gráfica es su principal prioridad, hágalo.

Ilustración de la construcción de drones en un área remota.

Lo último hoy es un técnica de impresión 3D basada en drones del Imperial College London que podría usarse para procesos de construcción autónomos en algún momento en el futuro profundo. Por ahora definitivamente no es práctico para crear algo más grande que un bote de basura, pero aún es pronto. Eventualmente, esperan hacerlo más como el anterior, y se ve genial, pero mire el video a continuación para aclarar sus expectativas.

Source link