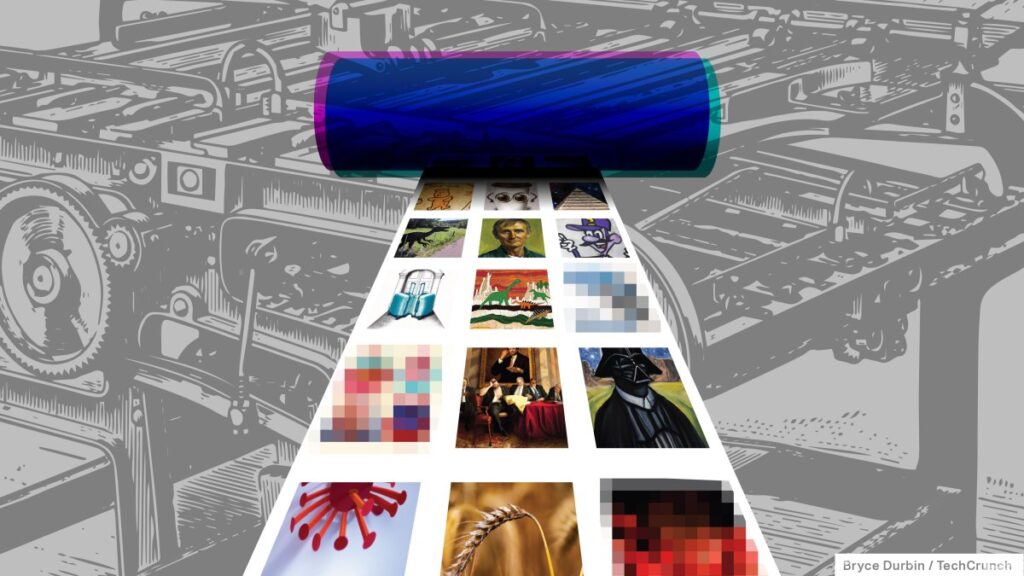

La IA de texto a imagen explotó este año a medida que los avances técnicos mejoraron en gran medida la fidelidad del arte que los sistemas de IA podían crear. Por polémicos que sean sistemas como Stable Diffusion y OpenAI’s DALL-E 2, plataformas como DeviantArt y Canva los han adoptado para impulsar herramientas creativas, personalizar la marca e incluso idear nuevos productos.

Pero la tecnología en el corazón de estos sistemas es capaz de mucho más que generar arte. Llamada difusión, está siendo utilizada por algunos intrépidos grupos de investigación para producir música, sintetizar secuencias de ADN e incluso descubrir nuevas drogas.

Entonces, ¿qué es la difusión, exactamente, y por qué es un salto tan masivo sobre el estado del arte anterior? A medida que termina el año, vale la pena echar un vistazo a los orígenes de la difusión y cómo avanzó con el tiempo para convertirse en la fuerza influyente que es hoy. La historia de Diffusion no ha terminado (los refinamientos en las técnicas llegan con cada mes que pasa), pero el último año o dos trajeron un progreso notable especialmente.

El nacimiento de la difusión.

Es posible que recuerde la tendencia de las aplicaciones de falsificación profunda hace varios años: aplicaciones que insertaban retratos de personas en imágenes y videos existentes para crear sustituciones de apariencia realista de los sujetos originales en ese contenido de destino. Usando AI, las aplicaciones “insertarían” la cara de una persona, o en algunos casos, todo su cuerpo, en una escena, a menudo de manera tan convincente como para engañar a alguien a primera vista.

La mayoría de estas aplicaciones se basaron en una tecnología de inteligencia artificial llamada redes antagónicas generativas, o GAN para abreviar. Las GAN constan de dos partes: un generador que produce ejemplos sintéticos (por ejemplo, imágenes) a partir de datos aleatorios y un discriminador que intenta distinguir entre los ejemplos sintéticos y los ejemplos reales de un conjunto de datos de entrenamiento. (Los conjuntos de datos de entrenamiento típicos de GAN consisten en cientos a millones de ejemplos de cosas que se espera que el GAN capture eventualmente). Tanto el generador como el discriminador mejoran en sus respectivas habilidades hasta que el discriminador no puede distinguir los ejemplos reales de los ejemplos sintetizados con mejor que el 50% de precisión que se espera del azar.

Esculturas de arena de Harry Potter y Hogwarts, generadas por Stable Diffusion. Créditos de imagen: Estabilidad IA

Las GAN de alto rendimiento pueden crear, por ejemplo, instantáneas de edificios de apartamentos ficticios. StyleGAN, un sistema que Nvidia desarrolló hace unos años, puede generar tomas de cabeza de alta resolución de personas ficticias mediante el aprendizaje de atributos como la pose facial, las pecas y el cabello. Más allá de la generación de imágenes, las GAN se han aplicado al espacio de modelado 3D y bocetos vectorialesmostrando una aptitud para generar videoclips tanto como habla e incluso muestras de instrumentos de bucle en canciones

Sin embargo, en la práctica, las GAN sufrieron una serie de deficiencias debido a su arquitectura. El entrenamiento simultáneo de los modelos generador y discriminador era intrínsecamente inestable; a veces, el generador “colapsaba” y generaba muchas muestras de apariencia similar. Las GAN también necesitaban muchos datos y poder de cómputo para ejecutarse y entrenarse, lo que las hacía difíciles de escalar.

Entra en difusión.

Cómo funciona la difusión

La difusión se inspiró en la física, siendo el proceso en la física donde algo se mueve de una región de mayor concentración a una de menor concentración, como un terrón de azúcar que se disuelve en el café. Los gránulos de azúcar en el café se concentran inicialmente en la parte superior del líquido, pero se distribuyen gradualmente.

Los sistemas de difusión se basan específicamente en la difusión en la termodinámica de no equilibrio, donde el proceso aumenta la entropía, o aleatoriedad, del sistema a lo largo del tiempo. Considere un gas: eventualmente se extenderá para llenar un espacio completo de manera uniforme a través de un movimiento aleatorio. De manera similar, los datos como las imágenes se pueden transformar en una distribución uniforme agregando ruido aleatoriamente.

Los sistemas de difusión destruyen lentamente la estructura de los datos añadiendo ruido hasta que no queda nada más que ruido.

En física, la difusión es espontánea e irreversible: el azúcar que se difunde en el café no se puede restaurar a su forma de cubo. Pero los sistemas de difusión en el aprendizaje automático tienen como objetivo aprender una especie de proceso de “difusión inversa” para restaurar los datos destruidos, obteniendo la capacidad de recuperar los datos del ruido.

Créditos de imagen: OpenBioML

Los sistemas de difusión existen desde hace casi una década. Pero una innovación relativamente reciente de OpenAI llamada CLIP (abreviatura de “Preentrenamiento de imagen de lenguaje contrastivo”) los hizo mucho más prácticos en las aplicaciones cotidianas. CLIP clasifica los datos, por ejemplo, las imágenes, para “puntuar” cada paso del proceso de difusión en función de la probabilidad de que se clasifiquen en un mensaje de texto determinado (p. ej., “un boceto de un perro en un césped florido”).

Al principio, los datos tienen una puntuación CLIP muy baja, porque en su mayoría son ruido. Pero a medida que el sistema de difusión reconstruye los datos a partir del ruido, poco a poco se acerca a la coincidencia con el aviso. Una analogía útil es el mármol sin tallar: como un maestro escultor que le dice a un novato dónde tallar, CLIP guía el sistema de difusión hacia una imagen que otorga una puntuación más alta.

OpenAI presentó CLIP junto con el sistema de generación de imágenes DALL-E. Desde entonces, se abrió paso en el sucesor de DALL-E, DALL-E 2, así como en alternativas de código abierto como Stable Diffusion.

¿Qué puede hacer la difusión?

Entonces, ¿qué pueden hacer los modelos de difusión guiados por CLIP? Bueno, como se mencionó anteriormente, son bastante buenos para generar arte, desde arte fotorrealista hasta bocetos, dibujos y pinturas al estilo de prácticamente cualquier artista. De hecho, hay evidencia que sugiere que regurgitan de manera problemática algunos de sus datos de entrenamiento.

Pero el talento de las modelos, por controvertido que sea, no termina ahí.

Los investigadores también han experimentado con el uso de modelos de difusión guiada para componer nueva música. Harmonaiuna organización con el respaldo financiero de Estabilidad IA, la startup con sede en Londres detrás de Stable Diffusion, lanzó un modelo basado en difusión que puede generar clips de música entrenando en cientos de horas de canciones existentes. Más recientemente, los desarrolladores Seth Forsgren y Hayk Martiros crearon un proyecto de hobby denominado Riffusion que utiliza un modelo de difusión inteligentemente entrenado en espectrogramas (representaciones visuales) de audio para generar cancioncillas.

Más allá del ámbito de la música, varios laboratorios están intentando aplicar tecnología de difusión a la biomedicina con la esperanza de descubrir nuevos tratamientos para enfermedades. La startup Generate Biomedicines y un equipo de la Universidad de Washington entrenaron modelos basados en difusión para producir diseños de proteínas con propiedades y funciones específicas, como MIT Tech Review reportado a principios de este mes.

Los modelos funcionan de diferentes maneras. Generate Biomedicines agrega ruido al desentrañar las cadenas de aminoácidos que forman una proteína y luego junta cadenas aleatorias para formar una nueva proteína, guiado por las restricciones especificadas por los investigadores. El modelo de la Universidad de Washington, por otro lado, comienza con una estructura codificada y utiliza información sobre cómo deben encajar las piezas de una proteína proporcionada por un sistema de IA separado entrenado para predecir la estructura de la proteína.

Créditos de imagen: PASIEKA/BIBLIOTECA DE FOTOS DE CIENCIA/Getty Images

Ya han logrado cierto éxito. El modelo diseñado por el grupo de la Universidad de Washington pudo encontrar una proteína que puede unirse a la hormona paratiroidea, la hormona que controla los niveles de calcio en la sangre, mejor que los medicamentos existentes.

Mientras tanto, en OpenBioML, un esfuerzo respaldado por Stability AI para llevar enfoques basados en el aprendizaje automático a la bioquímica, los investigadores han desarrollado un sistema llamado Difusión de ADN para generar secuencias de ADN reguladoras específicas del tipo de célula: segmentos de moléculas de ácido nucleico que influyen en el expresión de genes específicos dentro de un organismo. DNA-Diffusion, si todo va según lo planeado, generará secuencias reguladoras de ADN a partir de instrucciones de texto como “Una secuencia que activará un gen a su máximo nivel de expresión en células tipo X” y “Una secuencia que activa un gen en el hígado y el corazón”. , pero no en el cerebro.”

¿Qué podría deparar el futuro para los modelos de difusión? El cielo bien puede ser el límite. Los investigadores ya lo han aplicado a generando videos, comprimir imágenes y sintetizando el habla. Eso no quiere decir que la difusión no se reemplace eventualmente con una técnica de aprendizaje automático más eficiente y de mayor rendimiento, como lo fueron las GAN con la difusión. Pero es la arquitectura del día por una razón; la difusión no es más que versátil.