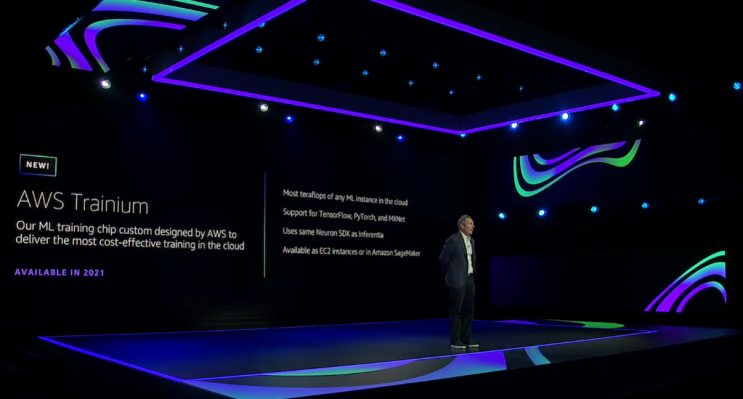

En su conferencia anual de desarrolladores de re: Invent, AWS anunció hoy el lanzamiento de AWS Trainium, el chip personalizado de próxima generación de la compañía dedicado a entrenar modelos de aprendizaje automático. La compañía promete que puede ofrecer un rendimiento más alto que cualquiera de sus competidores en la nube, con soporte para TensorFlow, PyTorch y MXNet.

Estará disponible como instancias EC2 y dentro de Amazon SageMaker, la plataforma de aprendizaje automático de la compañía.

Las nuevas instancias basadas en estos chips personalizados se lanzarán el próximo año.

Los principales argumentos para estos chips personalizados son la velocidad y el costo. AWS promete un 30% más de rendimiento y un 45% menos de costo por inferencia en comparación con las instancias de GPU de AWS estándar.

Además, AWS se ha asociado con Intel para lanzar instancias EC2 basadas en Habana Gaudí para capacitación en aprendizaje automático. A partir del próximo año, estas instancias prometen ofrecer hasta un 40% más de precio / rendimiento en comparación con el conjunto actual de instancias EC2 basadas en GPU para aprendizaje automático. Estos chips admitirán TensorFlow y PyTorch.

Estos nuevos chips harán su debut en la nube de AWS en la primera mitad de 2021.

Ambas nuevas ofertas complementan AWS Inferentia, que la compañía lanzó el año pasado en re: Invent. Inferentia es la contraparte de inferencia de estas piezas de aprendizaje automático, que también utiliza un chip personalizado.

Trainium, vale la pena señalar, utilizará el mismo SDK que Inferentia.

“Si bien Inferentia abordó el costo de la inferencia, que constituye hasta el 90% de los costos de infraestructura de ML, muchos equipos de desarrollo también están limitados por presupuestos fijos de capacitación de ML”, escribe el equipo de AWS. “Esto limita el alcance y la frecuencia de la capacitación necesaria para mejorar sus modelos y aplicaciones. AWS Trainium aborda este desafío proporcionando el mayor rendimiento y el menor costo para la capacitación de ML en la nube. Tanto con Trainium como con Inferentia, los clientes tendrán un flujo de procesamiento de aprendizaje automático de un extremo a otro, desde escalar las cargas de trabajo de capacitación hasta implementar inferencias aceleradas “.

Source link