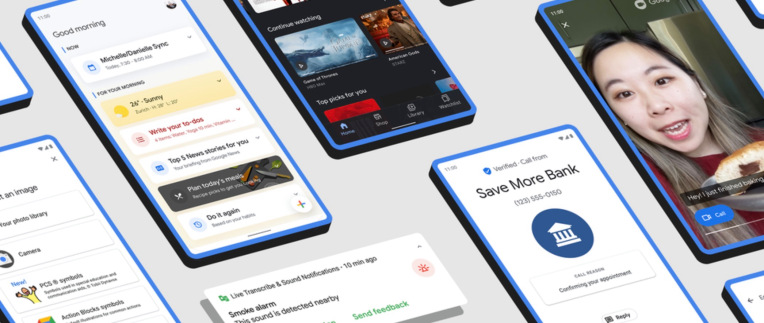

Google anunció hoy que hace posible usar el comando de voz “Hey Google” no solo para abrir, sino también para realizar tareas específicas dentro de las aplicaciones de Android. La función se implementará en todos los teléfonos Android habilitados para el Asistente de Google, lo que permitirá a los usuarios iniciar aplicaciones con su voz, así como buscar dentro de las aplicaciones o realizar tareas específicas, como pedir comida, reproducir música, publicar en las redes sociales, solicitar un viaje, y más.

Por ejemplo, los usuarios podrían decir algo como “Ok Google, busca mantas cómodas en Etsy”, “abre Selena Gomez en Snapchat”, “comienza mi carrera con Nike Run Club” o “mira las noticias en Twitter”.

En el lanzamiento, Google dice que este tipo de comandos de voz funcionarán con más de 30 de las principales aplicaciones en Google Play en inglés a nivel mundial, y pronto habrá más aplicaciones. Algunas de las aplicaciones compatibles en la actualidad incluyen Spotify, Snapchat, Twitter, Walmart, Discord, Etsy, MyFitnessPal, Mint, Nike Adapt, Nike Run Club, eBay, Kroger y Postmates, Wayfair, por nombrar algunas.

Si el comando de voz específico que usaría para realizar una tarea común es un poco torpe, la función también le permitirá crear una frase de acceso directo personalizada. Eso significa que, en lugar de decir “Ok Google, ajústate los zapatos con Nike Adapt”, podrías crear un comando que dijera simplemente “Ok Google, átalo”.

Para comenzar con los accesos directos, los usuarios de Android pueden decir “Ok Google, muestra mis accesos directos” para acceder a la pantalla de configuración correcta.

La función es similar al soporte de Apple para usar Siri con aplicaciones de iOS, que también incluye la capacidad de abrir aplicaciones, realizar tareas y grabar su propia frase personalizada.

En el caso de Google, la capacidad de realizar tareas dentro de una aplicación se implementa en el lado del desarrollador al asignar las intenciones de los usuarios a una funcionalidad específica dentro de sus aplicaciones. Esta función, conocida como Acciones de aplicación, permite a los usuarios abrir sus aplicaciones favoritas con un comando de voz. Y, con la funcionalidad agregada, permite a los usuarios decir “Hola Google” para buscar dentro de la aplicación o para abrir páginas específicas de la aplicación.

Google dice que ha aumentado su catálogo para incluir más de 60 intenciones en 10 verticales, que incluyen finanzas, viajes compartidos, pedidos de alimentos, fitness y, ahora, social, juegos, viajes y local, productividad, compras y comunicaciones también.

Para ayudar a los usuarios a comprender cómo y cuándo pueden usar estas nuevas acciones de aplicación, Google dice que está creando puntos de contacto en Android que les ayudarán a aprender cuándo usan ciertos comandos de voz. Por ejemplo, si un usuario dijo “Ok Google, muéstrame Taylor Swift”, puede resaltar un chip de sugerencia que guiará a los usuarios a abrir el resultado de búsqueda en Twitter.

Créditos de imagen: Google

En relación con esta noticia, Google dice que también lanzó dos nuevas voces en inglés para que los desarrolladores las aprovechen al crear experiencias personalizadas para Assistant en pantallas inteligentes, junto con otras herramientas y recursos para desarrolladores para aquellos que crean para pantallas.

La actualización del Asistente de Google para aplicaciones fue una de las varias mejoras de Android que Google destacó hoy. La compañía también dice que está agregando el uso compartido de pantalla a Google Duo, expandiendo su función anti-spam de llamadas verificadas a más dispositivos (Android 9 y superior) y actualizando la aplicación Google Play Movies & TV para convertirse en la nueva aplicación “Google TV”. anunció la semana pasada.

En el frente de la accesibilidad, presenta nuevas herramientas para la pérdida auditiva con Notificaciones de sonido y otras para comunicarse mediante bloques de acción, dirigidas a personas con parálisis cerebral, síndrome de Down, autismo, afasia y otras discapacidades relacionadas con el habla.

Las funciones están disponibles ahora.

Source link