El aprendizaje profundo está de moda en los círculos empresariales, y no es difícil entender por qué. Ya sea para optimizar el gasto publicitario, encontrar nuevos medicamentos para curar el cáncer o simplemente ofrecer productos mejores y más inteligentes a los clientes, el aprendizaje automático, y particularmente los modelos de aprendizaje profundo, tienen el potencial de mejorar enormemente una gama de productos y aplicaciones.

Sin embargo, la palabra clave es "potencial". Si bien en los últimos años hemos escuchado muchas palabras esparcidas por las conferencias empresariales sobre el aprendizaje profundo, sigue habiendo enormes obstáculos para hacer que estas técnicas estén ampliamente disponibles. Los modelos de aprendizaje profundo están altamente conectados en red, con gráficos densos de nodos que no "encajan" bien con las formas tradicionales en que las computadoras procesan la información. Además, mantener toda la información requerida para un modelo de aprendizaje profundo puede requerir petabytes de almacenamiento y bastidores en bastidores de procesadores para poder ser utilizados.

Hay muchos enfoques en curso en este momento para resolver este problema de cómputo de próxima generación, y Cerebras tiene que estar entre los más interesantes.

Como hablamos en agosto con el anuncio del "Motor de escala de obleas" de la compañía, el chip de silicio más grande del mundo según la compañía, la teoría de Cerebras es que el camino a seguir para el aprendizaje profundo es esencialmente lograr que todo el modelo de aprendizaje automático cabe en un chip masivo. Y así, la compañía pretendía ir a lo grande, realmente grande.

Hoy, la compañía anunció el lanzamiento de su producto informático para usuarios finales, el Cerebras CS-1, y también anunció su primer cliente del Laboratorio Nacional Argonne.

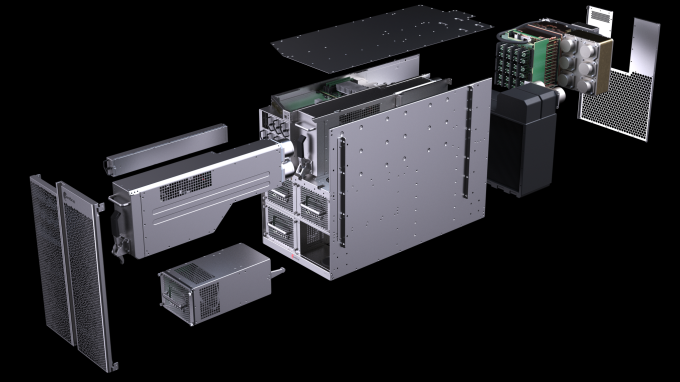

El CS-1 es un producto de "solución completa" diseñado para ser agregado a un centro de datos para manejar los flujos de trabajo de IA. Incluye el Wafer Scale Engine (o WSE, es decir, el núcleo de procesamiento real) más todos los equipos de refrigeración, redes, almacenamiento y otros equipos necesarios para operar e integrar el procesador en el centro de datos. Tiene 26.25 pulgadas de alto (15 unidades de rack) e incluye 400,000 núcleos de procesamiento, 18 gigabytes de memoria en chip, 9 petabytes por segundo de ancho de banda de memoria en matriz, conexiones de 12 gigabit ethernet para mover datos dentro y fuera del CS-1 sistema, y aspira solo 20 kilovatios de potencia.

Una mirada de sección transversal al CS-1. Foto vía Cerebras.

Cerebras afirma que el CS-1 ofrece el rendimiento de más de 1,000 GPU líderes combinadas, un reclamo que TechCrunch no ha verificado, aunque estamos esperando atentamente los puntos de referencia estándar de la industria en los próximos meses cuando los evaluadores tengan en sus manos estas unidades.

Además del hardware en sí, Cerebras también anunció el lanzamiento de una plataforma de software integral que permite a los desarrolladores utilizar bibliotecas ML populares como TensorFlow y PyTorch para integrar sus flujos de trabajo de IA con el sistema CS-1.

Al diseñar el sistema, el CEO y cofundador Andrew Feldman dijo que "hemos hablado con más de 100 clientes durante el año pasado y un poco", para determinar las necesidades de un nuevo sistema de inteligencia artificial y la capa de software que debería ve encima de eso. "Lo que hemos aprendido a lo largo de los años es que quieres conocer a la comunidad de software donde están en lugar de pedirles que se muden a ti".

Le pregunté a Feldman por qué la compañía estaba reconstruyendo gran parte del hardware para alimentar su sistema, en lugar de utilizar componentes ya existentes. "Si construyeras un motor Ferrari y lo pusieras en un Toyota, no podrías hacer un auto de carreras", anotó Feldman. “Poner chips rápidos en Dell u (otros) servidores no hace un cálculo rápido. Lo que hace es mover el cuello de botella ”. Feldman explicó que el CS-1 estaba destinado a tomar el chip WSE subyacente y darle la infraestructura necesaria para permitir que funcione al máximo de su capacidad.

Un diagrama del sistema de enfriamiento Cerebras CS-1. Foto vía Cerebras.

Esa infraestructura incluye un sistema de enfriamiento de agua de alto rendimiento para mantener este chip masivo y esta plataforma funcionando a las temperaturas correctas. Le pregunté a Feldman por qué Cerebras eligió el agua, dado que el enfriamiento del agua ha sido tradicionalmente complicado en el centro de datos. Él dijo: “Observamos otras tecnologías: el freón. Analizamos soluciones inmersivas, analizamos soluciones de cambio de fase. Y lo que encontramos fue que el agua es extraordinaria en el calor en movimiento ".

Una vista lateral del CS-1 con sus sistemas de refrigeración por agua y aire visibles. Foto vía Cerebras.

¿Por qué entonces hacer un chip tan masivo, que como discutimos en agosto, tiene enormes requisitos de ingeniería para operar en comparación con chips más pequeños que tienen un mejor rendimiento de las obleas? Feldman dijo que "reduce enormemente el tiempo de comunicación mediante el uso de la localidad".

En informática, la localidad está colocando datos y computación en los lugares correctos, digamos una nube, que minimiza los retrasos y la fricción de procesamiento. Al tener un chip que teóricamente puede alojar un modelo ML completo en él, no hay necesidad de que los datos fluyan a través de múltiples clústeres de almacenamiento o cables de ethernet; todo con lo que el chip necesita trabajar está disponible casi de inmediato.

De acuerdo con una declaración del Cerebras y del Laboratorio Nacional de Argonne, Cerebras está ayudando a impulsar la investigación sobre "cáncer, lesión cerebral traumática y muchas otras áreas importantes para la sociedad actual" en el laboratorio. Feldman dijo que "fue muy satisfactorio que los clientes de inmediato estuvieran usando esto para cosas que son importantes y no para que las chicas de 17 años se encuentren en Instagram o algo así".

(Por supuesto, uno espera que la investigación del cáncer pague, así como el marketing de influencia, en lo que respecta al valor de los modelos de aprendizaje profundo).

Cerebras ha crecido rápidamente, llegando a 181 ingenieros hoy según la compañía. Feldman dice que la compañía no tiene mucho que ver con las ventas al cliente y el desarrollo de productos adicionales.

Ciertamente, ha sido un momento ocupado para las nuevas empresas en el espacio de flujo de trabajo de inteligencia artificial de próxima generación. Graphcore acaba de anunciar este fin de semana que se estaba instalando en la nube Azure de Microsoft, mientras cubría la financiación de NUVIA, una startup liderada por los antiguos diseñadores líderes de chips de Apple que esperan aplicar sus fondos móviles para resolver los requisitos de potencia extrema de estos chips AI fuerza en los centros de datos.

Espere más anuncios y actividad en este espacio a medida que el aprendizaje profundo continúa encontrando nuevos adherentes en la empresa.

Source link