Los videos intercambiados digitalmente conocidos como deepfakes no van a ninguna parte, pero si las plataformas quieren poder vigilarlos, primero deben encontrarlos. Hacerlo fue el objeto de Facebook “Deepfake Detection Challenge”, lanzado el año pasado. Después de meses de competencia, los ganadores han surgido y son … mejores que adivinar. ¡Es un comienzo!

Desde su aparición en el último año o dos, los deepfakes han avanzado desde un nicho de juguete creado para conferencias de IA hasta software descargado fácilmente que cualquiera puede usar para crear videos falsos convincentes de figuras públicas.

“Descargué generadores de deepfake con solo hacer doble clic y se ejecutan en un cuadro de Windows; no hay nada como eso para la detección”, dijo el CTO de Facebook Mike Schroepfer en una llamada con la prensa.

Es probable que este sea el primer año de elecciones donde los actores maliciosos intentan influir en la conversación política utilizando videos falsos de candidatos generados de esta manera. Dada la precaria posición de Facebook en la opinión pública, les interesa mucho salir delante de esto.

La competencia comenzó el año pasado con el debut de una nueva base de datos de imágenes profundas. Hasta entonces, los investigadores tenían poco con qué jugar: un puñado de conjuntos de video manipulados de tamaño mediano, pero nada como los enormes conjuntos de datos utilizados para evaluar y mejorar cosas como los algoritmos de visión por computadora.

Facebook pagó la factura para que 3.500 actores graben miles de videos, cada uno de los cuales estuvo presente como original y falso. También se hicieron un montón de otras modificaciones “distractoras”, para forzar a cualquier algoritmo con la esperanza de detectar falsificaciones para prestar atención a la parte importante: la cara, obviamente.

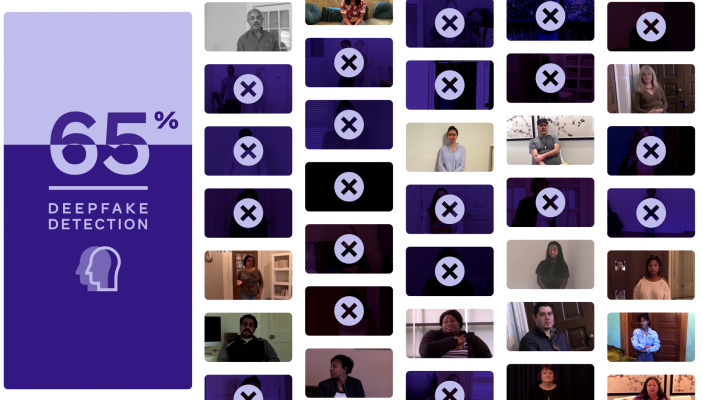

Participaron investigadores de todas partes, enviando miles de modelos que intentan decidir si un video es falso o no. Aquí hay seis videos, tres de los cuales son deepfakes. ¿Puedes decir cuál es cuál? (Las respuestas están al final de la publicación).

Créditos de imagen: Facebook

Al principio, estos algoritmos no eran mejores que el azar. Pero después de muchas iteraciones y algunos ajustes inteligentes, lograron alcanzar más del 80% de precisión en la identificación de falsificaciones. Desafortunadamente, cuando se desplegó en un conjunto reservado de videos que los investigadores no habían recibido, la precisión más alta fue de alrededor del 65%.

Es mejor que lanzar una moneda, pero no por mucho. Afortunadamente, eso era bastante esperado, y los resultados son realmente muy prometedores. En la investigación de inteligencia artificial, el paso más difícil es pasar de la nada a algo; después de eso, se trata de mejorar cada vez más. Pero descubrir si el problema puede incluso ser resuelto por AI es un gran paso. Y la competencia parece indicar que puede.

Ejemplos de un video fuente y múltiples versiones de distractores. Créditos de imagen: Facebook

Una nota importante es que el conjunto de datos creado por Facebook se hizo deliberadamente para ser más representativo e inclusivo que otros, no solo más grande. Después de todo, la IA solo es tan buena como los datos que contiene, y el sesgo que se encuentra en la IA a menudo se puede rastrear hasta el sesgo en el conjunto de datos.

“Si su conjunto de entrenamiento no tiene la variación adecuada en la forma en que se ven las personas reales, entonces su modelo no tendrá una comprensión representativa de eso. Creo que nos esforzamos para asegurarnos de que este conjunto de datos fuera bastante representativo ”, dijo Schroepfer.

Pregunté si los grupos o tipos de rostros o situaciones tenían menos probabilidades de ser identificados como falsos o reales, pero Schroepfer no estaba seguro. En respuesta a mis preguntas sobre la representación en el conjunto de datos, una declaración del equipo decía:

Al crear el conjunto de datos DFDC, consideramos muchos factores y era importante que tuviéramos representación en varias dimensiones, incluida la edad, el género y el origen étnico autoidentificados. La tecnología de detección debe funcionar para todos, por lo que era importante que nuestros datos fueran representativos del desafío.

Los modelos ganadores se convertirán en código abierto en un esfuerzo por impulsar al resto de la industria a la acción, pero Facebook está trabajando en su propio producto de detección de falsificación profunda que Schropfer dijo que no se compartiría. La naturaleza conflictiva del problema (los malos aprenden de lo que hacen los buenos y ajustan su enfoque, básicamente) significa que decirles a todos exactamente lo que se está haciendo para evitar las falsificaciones puede ser contraproducente.

Source link