La ciencia tiene que proporcionar resultados reproducibles: cualquier otro científico debe poder repetir tu experimento en condiciones similares y obtener los mismos resultados. Las teorías científicas formuladas a partir de esos resultados deben ser contrastadas, deben realizar predicciones que puedan ser puestas a prueba mediante nuevos experimentos. Una teoría científica nunca podremos probar que es completamente correcta, sólo puede ser refutada, pero estará más establecida y será considerada más robusta si sobrevive a cuantos más experimentos independientes y distintos hagamos.

Lo de contrastar teorías no es tan fácil como decir que dos y dos son cuatro. Toda medida conlleva una incertidumbre y todo experimento científico permite calcular parámetros físicos con una determinada precisión. Cuanto mayor sea esa precisión mejor conocemos la realidad, pero aquellas cosas que conocemos con gran precisión se prestan también a mayores problemas cuando se contrastan resultados de distintos experimentos. De hecho, a medida que aumentamos la precisión empezamos a encontrar fallos en todas las teorías establecidas, y cuando se acumulan suficientes fallos, tenemos que reformularlas. El diablo está en los detalles, y los detalles a veces destruyen las teorías y crean nuevos paradigmas. Ponemos como ejemplo la mecánica newtoniana, con la que se pueden explicar los movimientos de los astros en gran medida, llevar un cohete a la Luna incluso, pero no puede explicar con suficiente exactitud lo que pasa tan cerca del Sol como la órbita de Mercurio, cuyo movimiento necesita la Teoría de la Relatividad General para poder ser explicado y cuantificado hasta una precisión mejor que un 0.04%. La Relatividad General es un cambio de paradigma frente a la mecánica newtoniana, pero tampoco es que hayamos tirado a la basura lo que nos enseñó el físico inglés.

Con esta reflexión general sobre ciencia introducimos hoy algo que preocupa a todos los astrofísicos y que afecta a uno de los parámetros cosmológicos más básicos que existen, la velocidad de expansión del universo, también conocida como la constante de Hubble, H0, que aparece en la llamada ley de Hubble-Lemaître. H0 se mide en unidades de velocidad, kilómetros por segundo (km/s), por unidad de distancia, el megapársec (Mpc).

Básicamente hay 2 formas de medir la velocidad de expansión del universo en el presente, bastante independientes. La primera, la que originalmente usó el propio Hubble, es medir la velocidad de alejamiento de las galaxias relativamente cercanas con respecto a nosotros. El problema es que las galaxias no solo se mueven debido a la expansión del universo, sino que también están sujetas a la fuerza de la gravedad de otras galaxias, que las hace moverse hacia ellas. Por ejemplo, la galaxia de Andrómeda, la más cercana a nosotros con un tamaño parecido, está a unos 0.8 Mpc de nosotros. Está “tan cerca” que en realidad la expansión del Universo no la afecta y de hecho se está acercando a nosotros, estamos atraídos mutuamente por la acción de la gravedad y se aproxima a unos 100 km/s, en vez de alejarse a unos 70 km/s, como diría la ley de Hubble-Lemaître.

El gran problema cosmológico al que nos enfrentamos los astrofísicos actualmente es que estos dos métodos ultra-precisos y los distintos experimentos que los han utilizado para determinar la constante de Hubble producen resultados inconsistentes

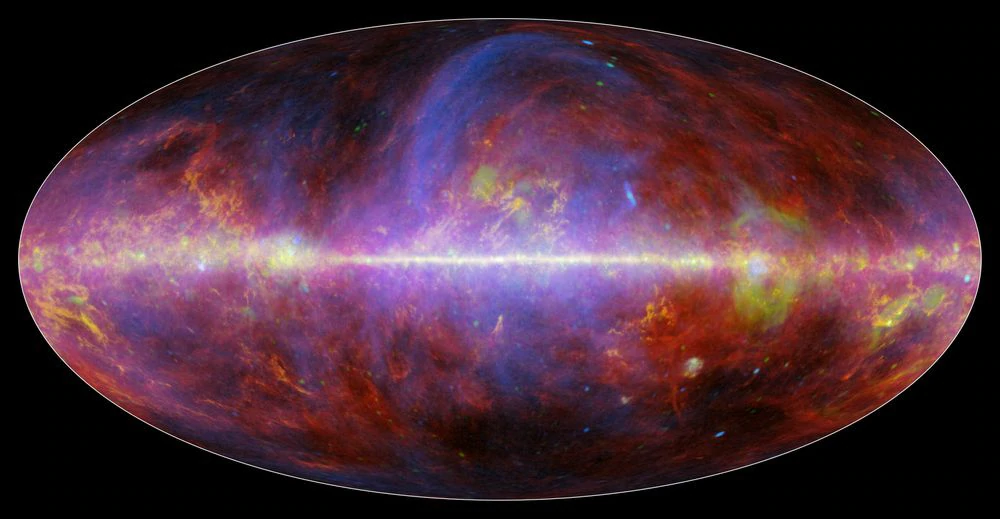

La segunda forma de medir la constante de Hubble es estudiando el universo en sus orígenes, cuando su edad eran tan solo el 0.003% de la actual. El método es bastante más complicado e implica estudiar en detalle la radiación de fondo de microondas, la reliquia que nos queda de aquella época. Esta radiación está formada por todos los fotones que existían en el cosmos en ese momento y que a partir de entonces viajaron libres por el universo sin interaccionar con nada ni con nadie (salvo en una fracción despreciable). Eso sí, les afectó la expansión del universo, y por eso podemos calcular la velocidad de expansión actual con este método.

Pues bien, el gran problema cosmológico al que nos enfrentamos los astrofísicos actualmente es que estos dos métodos ultra-precisos y los distintos experimentos que los han utilizado para determinar la constante de Hubble producen resultados inconsistentes. Hace 100 años, cuando se formuló la Ley de Hubble-Lemaître, los experimentos contaban con tremendos errores sistemáticos (otro día nos metemos con este tipo de incertidumbres). Como muestra, un botón: Hubble se equivocó en un factor 2 en la distancia a galaxias como Andrómeda, pensó que estaba más cerca de lo que está, con lo que la primera estimación de H0 fue de 500 km/s/Mpc. Hace 20 años, cuando nosotros éramos estudiantes de licenciatura, la constante de Hubble tenía un valor indeterminado entre 50 y 100 km/s/Mpc. Pero hoy los experimentos basados en galaxias cercanas dan un valor de H0 de 73.3 km/s/Mpc, y los de la radiación de fondo de microondas 67.8 km/s/Mpc, una diferencia no muy grande, pero imposible de explicar con la precisión actual de nuestros experimentos, todos deberían converger. Y la inconsistencia es muy significativa, la probabilidad de que las dos estimaciones sean iguales es una entre más de 3.5 millones, claramente los dos métodos predicen constantes de Hubble diferentes.

Si encontramos algo que no cuadra en una teoría, algo está mal o algo no entendemos de manera adecuada, aunque no sepamos qué. Cuando el río suena, agua lleva. Quizás es que el río lleva agua un poco sucia o hay peces en ella que cantan, pero el hecho es que nuestro modelo cosmológico actual se enfrenta a un error básico y significativo y nos falta algo para explicar la discrepancia. ¿Qué opciones tenemos? Bueno, pues los astrofísicos, como mencionamos en otro post, somos muy buenos en cometer errores sistemáticos, que se lo digan a Hubble. En nuestro descargo podemos decir que no es fácil hacer experimentos que engloban toda la realidad, el universo entero. Pero hoy hay muchos experimentos que dan resultados parecidos de la constante de Hubble, y parece difícil que todos los que se basan en uno de los dos métodos se equivoquen en el mismo sentido. Esta no creemos que sea la razón, aunque no se puede descartar. Nos mojamos: el error estaría en la estimación de H0 ligada a la radiación cósmica de microondas, que estaría sujeta a muchos más efectos que no conocemos en detalle, como la existencia y propiedades de la materia oscura (¡habrá que probarlo!). Esto es lo que conocemos como “nueva física”, o nuevos conceptos físicos añadidos, porque los éxitos de la Teoría del Big Bang son demasiados para que podamos descartarla sin más. Una quintaesencia o kinescencia, alguna forma de materia-energía desconocida y variable en el tiempo, quizás podría ayudar a solucionar este problema de “la tensión con la constante de Hubble”, pero por ahora crearía otros más fundamentales. Propiedades desconocidas de partículas como los neutrinos también podrían ayudarnos. En definitiva, 5.5 km/s/Mpc nos traen de cabeza en los últimos años y hay que eliminarlos como sea. Bueno, como sea no, ideando más experimentos, controlando los errores sistemáticos y tomando datos.

Pablo G. Pérez González es investigador del Centro de Astrobiología, dependiente del Consejo Superior de Investigaciones Científicas y del Instituto Nacional de Técnica Aeroespacial (CAB/CSIC-INTA).

Patricia Sánchez Blázquez es profesora titular en la Universidad Complutense de Madrid (UCM).

Vacío Cósmico es una sección en la que se presenta nuestro conocimiento sobre el universo de una forma cualitativa y cuantitativa. Se pretende explicar la importancia de entender el cosmos no solo desde el punto de vista científico sino también filosófico, social y económico. El nombre “vacío cósmico” hace referencia al hecho de que el universo es y está, en su mayor parte, vacío, con menos de 1 átomo por metro cúbico, a pesar de que en nuestro entorno, paradójicamente, hay quintillones de átomos por metro cúbico, lo que invita a una reflexión sobre nuestra existencia y la presencia de vida en el universo.

Puedes seguir a MATERIA en Facebook, Twitter, Instagram o suscribirte aquí a nuestra newsletter.