- Microsoft ha lanzado una nueva herramienta de software que detecta deepfakes antes de las elecciones presidenciales de 2020.

- “Microsoft Video Authenticator” proporciona puntuaciones de confianza que muestran la probabilidad de que un tercero haya manipulado un determinado medio.

- Microsoft se está asociando con una coalición de organizaciones de noticias para probar la nueva tecnología.

Con dos meses para las elecciones presidenciales de EE. UU. De 2020, Microsoft ha introducido una nueva herramienta para ayudar a detectar deepfakes, o medios que han sido manipulados con inteligencia artificial. Este tipo de fotos, videos y grabaciones de audio aparecen en campañas de desinformación, lo que las convierte en un obstáculo para los políticos, los reguladores y el público.

➡ No dejes que la tecnología te engañe. Domina tu mundo digital con los mejores explicadores de su clase y acceso ilimitado a Pop Mech, comenzando ahora.

En una publicación de blog de esta semana, Microsoft dijo que “a corto plazo, como las próximas elecciones estadounidenses, las tecnologías de detección avanzada pueden ser una herramienta útil para ayudar a los usuarios exigentes a identificar deepfakes”.

Microsoft Video Authenticator busca pequeñas discrepancias en las imágenes, videos o audio en cuestión, que solo las computadoras pueden “ver”. En los deepfakes visuales, por ejemplo, el sistema detecta “límites de fusión” o elementos en escala de grises y desvanecimientos sutiles que normalmente son invisibles para el ojo humano.

Con cada deepfake, alguien ha diseñado un medio para sacar la imagen o el video de contexto, haciendo que parezca o suene como si una persona hubiera dicho cosas que no había dicho o aparecido en lugares donde no había estado.

En 2014, Ian Goodfellow, un Ph.D. estudiante que ahora trabaja en Apple, inventó el deepfake, que se basa en redes generativas de confrontación, o GAN. Estos pueden ayudar a los algoritmos a ir más allá de la simple tarea de clasificar los datos al campo de la creación de datos, en este caso, imágenes. Esto sucede cuando dos GAN intentan engañarse mutuamente para que piensen que una imagen es real. Con tan solo una imagen, un GAN probado y probado puede crear un videoclip de, digamos, Richard Nixon.

Este contenido se importa de terceros. Es posible que pueda encontrar el mismo contenido en otro formato, o puede encontrar más información, en su sitio web.

Es fácil ver cómo los malos actores pueden usar la tecnología para influir en la opinión política. El año pasado, por ejemplo, circuló por las redes sociales un video viral de Nancy Pelosi, la presidenta demócrata de la Cámara. En él, parecía estar arrastrando las palabras en una especie de soliloquio de borrachera sin sentido. El presidente Donald Trump compartió ese video en Twitter, pero no era real. Fue un deepfake.

Microsoft Video Authenticator analiza este tipo de imágenes y videos y les asigna una puntuación de confianza (charla de informática para un porcentaje de probabilidad) que muestra la probabilidad de que alguien haya manipulado ese medio.

“En el caso de un video, puede proporcionar este porcentaje en tiempo real en cada cuadro a medida que se reproduce el video”, dijo Microsoft en su publicación de blog.

Aún así, a pesar de la destreza técnica, esta es solo una solución de curita. Inevitablemente, a medida que se implementen estas herramientas de detección, los malos actores encontrarán nuevas formas de construir deepfakes que vuelan por debajo del radar.

Este contenido se importa de {embed-name}. Es posible que pueda encontrar el mismo contenido en otro formato, o puede encontrar más información, en su sitio web.

“Por lo tanto, a más largo plazo, debemos buscar métodos más sólidos para mantener y certificar la autenticidad de artículos de noticias y otros medios “, escribió Microsoft.” Hoy en día existen pocas herramientas para ayudar a asegurar a los lectores que los medios que están viendo en línea provienen de una fuente confiable y que no fueron alterados “.

A principios de este año, en un intento por detener la propagación de la desinformación, las plataformas de redes sociales comenzaron a tomar medidas para prohibir los deepfakes. Pero de nuevo, estos son pasos, no pasos agigantados.

En enero, Facebook dijo que estaba haciendo nuevos esfuerzos para “eliminar los medios manipulados engañosos” de la plataforma. Sin embargo, Facebook permite que los videos de sátira y parodia se desvanezcan, en particular, que el video de Pelosi no parece violar su nueva política de deepfake. TikTok y Twitter tienen políticas similares, que en su mayoría equivalen a etiquetar las fotos o videos potencialmente engañosos, o reducir su visibilidad en el feed.

Al tomar el asunto en sus propias manos, Microsoft se está asociando con una coalición de organizaciones de noticias, que incluyen Los New York Times y el BBC, para introducir nueva tecnología que garantice que todo el contenido que el público está asimilando sea realmente auténtico.

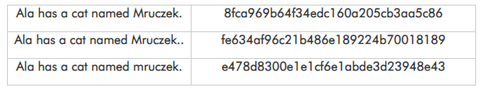

Los productores de contenido pueden agregar hashes digitales, que son una secuencia de letras y números que actúan como una “huella digital” única para el contenido, así como certificados, que permanecerán como metadatos dondequiera que vayan esas fotos o videos. Además, un lector que funciona como una extensión de navegador verifica esos certificados y hash para que el público pueda estar seguro de que lo que ven es auténtico.

Este es sin duda un paso positivo, pero es un recordatorio de que siempre debe verificar dos o tres veces la información que está consumiendo. Si no puede verificar que una foto o un video sea real de una fuente confiable, asuma lo peor.

Este contenido es creado y mantenido por un tercero y se importa a esta página para ayudar a los usuarios a proporcionar sus direcciones de correo electrónico. Es posible que pueda encontrar más información sobre este y contenido similar en piano.io

Source link