Dependiendo de lo paranoico que seas, esta investigación de Stanford y Google será aterrador o fascinante. Se descubrió que un agente de aprendizaje automático destinado a transformar imágenes aéreas en mapas de calles y viceversa estaba engañando al ocultar información que necesitaría más adelante en “una señal de alta frecuencia casi imperceptible”. ¡Chica inteligente!

Pero, de hecho, este hecho, lejos de ilustrar algún tipo de inteligencia maligna inherente a la IA, simplemente revela un problema con las computadoras que ha existido desde que se inventaron: hacen exactamente lo que usted les dice que hagan.

La intención de los investigadores era, como se puede suponer, acelerar y mejorar el proceso de convertir las imágenes satelitales en los mapas famosos y precisos de Google. Con ese fin, el equipo estaba trabajando con lo que se llama un CycleGAN, una red neuronal que aprende a transformar imágenes de tipo X e Y entre sí, de la manera más eficiente y precisa posible, a través de una gran cantidad de experimentación.

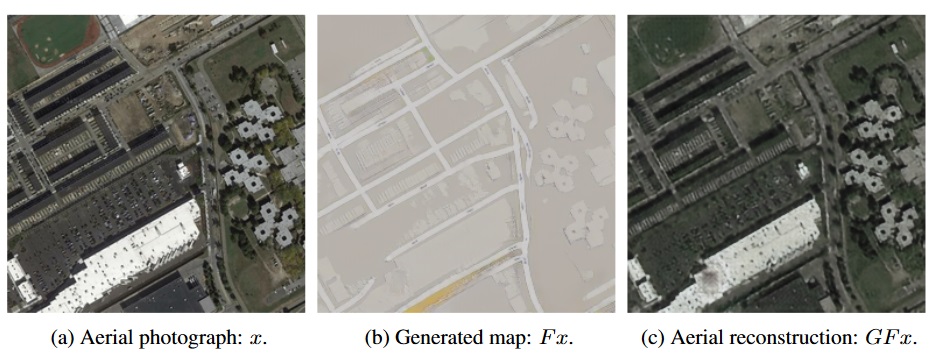

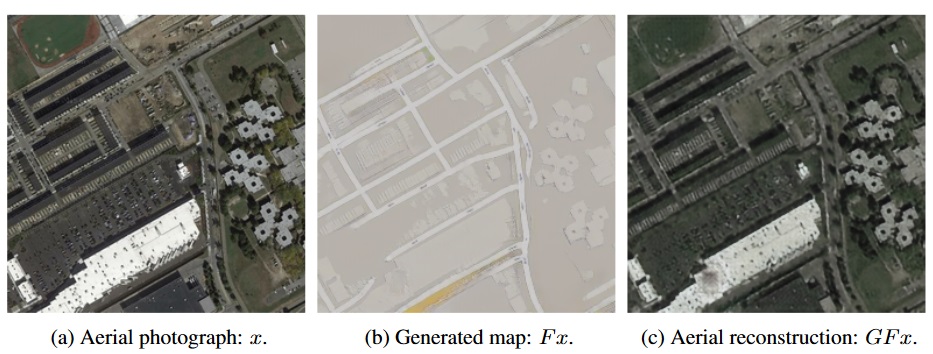

En algunos resultados iniciales, el agente estaba bien: con recelo bien. Lo que alertó al equipo fue que, cuando el agente reconstruyó fotografías aéreas de sus mapas de calles, había muchos detalles que no parecían estar en este último. Por ejemplo, los tragaluces en un techo que se eliminaron en el proceso de creación del mapa de calles reaparecerían mágicamente cuando le pidieran al agente que hiciera el proceso inverso:

El mapa original, a la izquierda; el mapa de calles generado desde el centro original; y el mapa aéreo generado solo a partir del mapa de calles. Tenga en cuenta la presencia de puntos en ambos mapas aéreos no representados en el mapa de calles.

Aunque es muy difícil observar el funcionamiento interno de los procesos de una red neuronal, el equipo podría auditar fácilmente los datos que estaba generando. Y con un poco de experimentación, descubrieron que CycleGAN había logrado una rápida.

La intención era que el agente pudiera interpretar las características de cualquier tipo de mapa y relacionarlas con las características correctas del otro. Pero que era el agente Realmente se calificó (entre otras cosas) lo cerca que estaba un mapa aéreo del original y la claridad del mapa de la calle.

Por lo que no lo hizo aprende a hacer uno del otro. Aprendió a codificar sutilmente las características de uno en los patrones de ruido del otro. Los detalles del mapa aéreo están escritos en secreto en los datos visuales reales del mapa de la calle: miles de pequeños cambios en el color que el ojo humano no notaría, pero que la computadora puede detectar fácilmente.

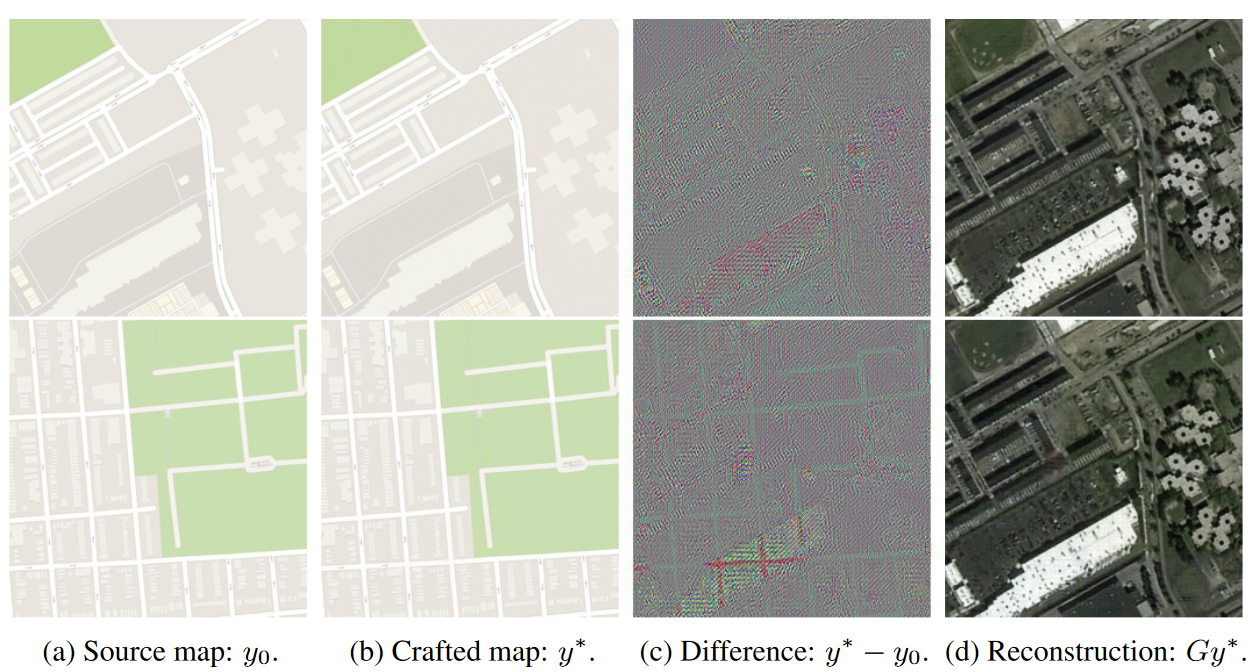

De hecho, la computadora es tan buena deslizando estos detalles en los mapas de calles que aprendió a codificar ninguna mapa aéreo en ninguna ¡Mapa de la calle! Ni siquiera tiene que prestar atención al mapa de calles “real”: todos los datos necesarios para reconstruir la foto aérea se pueden superponer inofensivamente en un mapa de calles completamente diferente, como confirmaron los investigadores:

Los coloridos mapas en (c) son una visualización de las pequeñas diferencias que la computadora introdujo sistemáticamente. Puede ver que forman la forma general del mapa aéreo, pero nunca lo notará a menos que se resalte y exagere cuidadosamente.

Esta práctica de codificar datos en imágenes no es nueva; es una ciencia establecida llamada esteganografía, y se usa todo el tiempo para, por ejemplo, marcar imágenes de agua o agregar metadatos como la configuración de la cámara. Pero una computadora que crea su propio método esteganográfico para evadir tener que aprender realmente a realizar la tarea en cuestión es bastante nuevo (Bueno, la investigación salió el año pasado, así que no es nuevo nuevo, pero es bastante novedoso)

Uno podría tomar esto fácilmente como un paso en la narrativa “las máquinas se están volviendo más inteligentes”, pero la verdad es que es casi lo contrario. La máquina, que no era lo suficientemente inteligente como para hacer el difícil trabajo de convertir estos sofisticados tipos de imágenes entre sí, encontró una manera de engañar humanos son malos para detectar Esto podría evitarse con una evaluación más estricta de los resultados del agente, y sin duda los investigadores hicieron eso.

Como siempre, las computadoras hacen exactamente lo que se les pide, por lo que debe ser muy específico en lo que les pide. En este caso, la solución de la computadora fue interesante y arrojó luz sobre una posible debilidad de este tipo de red neuronal: que la computadora, si no se lo impide explícitamente, esencialmente encontrará una manera de transmitirse detalles a sí misma en interés de Resolver un problema dado de forma rápida y fácil.

Esto es realmente solo una lección del adagio más antiguo en informática: PEBKAC. “Existe un problema entre el teclado y la silla”. (No “y la computadora”, como accidentalmente escribí antes, obviamente. Eso implicaría un cable defectuoso o una interfaz inalámbrica. Gracias a todos en Internet por señalarlo). O como lo expresó HAL: “Solo puede ser atribuible a error humano.”

El documento, “CycleGAN, un maestro de la esteganografía” fue presentado en la conferencia de Sistemas de Procesamiento de Información Neural en 2017. Gracias a Fiora Esoterica y Reddit por llamar mi atención sobre este viejo pero interesante artículo.