Imagínese esto: hace clic en un clip de noticias y ve al Presidente de los Estados Unidos en una conferencia de prensa con un líder extranjero. El diálogo es real. La conferencia de prensa es real. Compartes con un amigo. Comparten con un amigo. Pronto, todos lo han visto. Solo más tarde se entera de que la cabeza del presidente se superpuso al cuerpo de otra persona. Nada de eso sucedió realmente.

¿Suena descabellado? No, si has visto este video salvaje del usuario de YouTube Ctrl Shift Face:

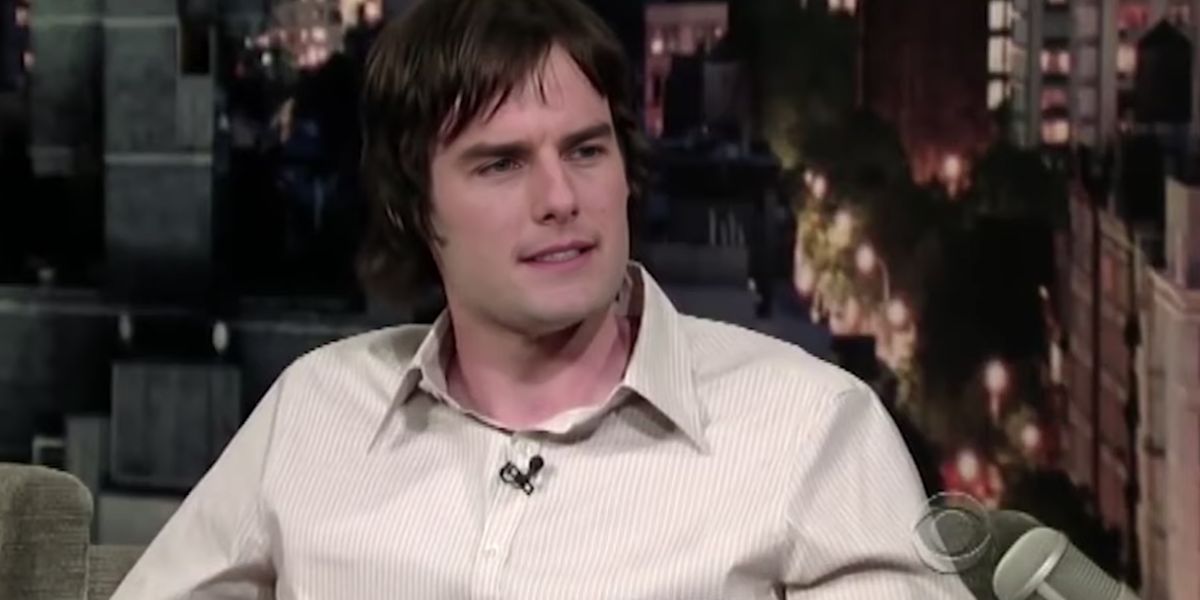

En el clip, el comediante Bill Hader comparte una historia sobre sus encuentros con Tom Cruise y Seth Rogen. Mientras Hader, un hábil impresionista, hace su mejor Cruise y Rogen, las caras de esos actores se funden a la perfección. La tecnología hace que las impresiones de Hader sean mucho más vívidas, pero también ilustra cuán fácil y potencialmente peligroso es manipular el contenido de video.

¿Qué es un deepfake?

El video de Hader es un deepfake creado por expertos, una tecnología inventada en 2014 por Ian Goodfellow, Ph.D. estudiante que ahora trabaja en Apple. La mayor parte de la tecnología deepfake se basa en redes generativas de confrontación (GAN).

Las GAN permiten que los algoritmos vayan más allá de clasificar datos para generar o crear imágenes. Esto ocurre cuando dos GAN intentan engañarse mutuamente para pensar que una imagen es "real". Usando tan solo una imagen, una GAN experimentada puede crear un video clip de esa persona. El Centro de IA de Samsung lanzó recientemente una investigación compartiendo la ciencia detrás de este enfoque.

"De manera crucial, el sistema puede inicializar los parámetros tanto del generador como del discriminador de una manera específica de la persona, de modo que la capacitación se puede basar en unas pocas imágenes y realizarse rápidamente, a pesar de la necesidad de ajustar decenas de millones de parámetros ", Dijeron los investigadores detrás del papel. "Demostramos que este enfoque es capaz de aprender modelos de cabezas parlantes altamente realistas y personalizados de nuevas personas e incluso pinturas de retratos".

Por ahora, esto solo se aplica a los videos de cabezas parlantes. Pero cuando el 47 por ciento de los estadounidenses mire sus noticias a través del contenido de video en línea, ¿qué sucede cuando las GAN pueden hacer que la gente baile, aplauda o sea manipulada?

¿Por qué son peligrosos los deepfakes?

Si olvidamos el hecho de que hay más de 30 naciones que participan activamente en la guerra cibernética en cualquier momento, entonces la mayor preocupación con las falsificaciones profundas podría ser cosas como el sitio web mal concebido Deepnudes, donde los rostros de celebridades y los rostros de las mujeres comunes podrían superponerse en la pornografía. contenido de video

El fundador de Deepnudes finalmente canceló el lanzamiento del sitio, por temor a que "la probabilidad de que la gente lo use mal es demasiado alta". Bueno, qué más Qué haría la gente con contenido falso de pornografía?

"En el nivel más básico, los deepfakes son mentiras disfrazadas para que parezcan verdaderas", dice Andrea Hickerson, directora de Escuela de Periodismo y Comunicaciones Masivas en la universidad de Carolina del Sur. "Si los tomamos como verdad o evidencia, fácilmente podemos sacar conclusiones falsas con consecuencias potencialmente desastrosas".

Gran parte del miedo a las falsificaciones profundas concierne legítimamente a la política, dice Hickerson. “¿Qué sucede si un video falso representa a un líder político que incita a la violencia o al pánico? ¿Podrían otros países verse obligados a actuar si la amenaza fuera inmediata?

Con las elecciones de 2020 acercándose y la continua amenaza de ataques cibernéticos y ciberguerra, tenemos que considerar seriamente algunos escenarios de miedo:

- Las falsificaciones profundas con armas se utilizarán en el ciclo electoral de 2020 para aislar, aislar y dividir aún más al electorado estadounidense.

- Las falsificaciones profundas con armas se utilizarán para cambiar e impactar el comportamiento de votación, pero también las preferencias de los consumidores de cientos de millones de estadounidenses.

- Las falsificaciones profundas con armas se utilizarán en el phishing de lanza y otras estrategias de ataque de ciberseguridad conocidas para atacar a las víctimas de manera más efectiva.

Esto significa que las falsificaciones profundas ponen a las empresas, las personas y el gobierno en mayor riesgo.

"El problema no es necesariamente la tecnología GAN", dice Ben Lamm, CEO de la compañía de inteligencia artificial. Industrias hipergigantes. “El problema es que los malos actores actualmente tienen una ventaja descomunal y no existen soluciones para enfrentar la creciente amenaza. Sin embargo, hay una serie de soluciones y nuevas ideas emergentes en la comunidad de IA para combatir esta amenaza. Aún así, la solución debe ser los humanos primero.

¿Qué se está haciendo para combatir los Deepfakes?

El mes pasado, el Comité de Inteligencia de la Cámara de Representantes de EE. UU. Envió una carta a Twitter, Facebook y Google preguntando cómo los sitios de redes sociales planeaban combatir las falsificaciones profundas en las elecciones de 2020. La investigación se produjo en gran parte después de que el presidente Trump tuiteó un video falso de Presidente de la Cámara Nancy Pelosi:

Esto siguió a la solicitud que el Congreso hizo en enero pidiendo al Director de Inteligencia Nacional que proporcionara un informe formal sobre tecnología de falsificación profunda. Si bien la investigación legislativa es crítica, puede que no sea suficiente.

Instituciones gubernamentales como DARPA e investigadores de universidades como Carnegie Mellon, la Universidad de Washington, la Universidad de Stanford y el Instituto Max Planck de Informática también están experimentando con tecnología de falsificación profunda. Las organizaciones están estudiando cómo usar la tecnología GAN, pero también cómo combatirla.

Con los algoritmos de alimentación de video falso y real, esperan ayudar a las computadoras a identificar cuándo algo es falso. Si esto suena como una carrera armamentista, es porque lo es. Estamos usando tecnología para lucha tecnología en una carrera que no terminará.

Quizás la solución no sea tecnología. Investigaciones recientes adicionales sugieren que los ratones podrían ser la clave. Investigadores del Instituto de Neurociencia de la Universidad de Oregon piensan que "un modelo de ratón, dadas las poderosas herramientas genéticas y electrofisiológicas para explorar los circuitos neuronales disponibles para ellos, tiene el potencial de aumentar poderosamente una comprensión mecanicista de la percepción fonética".

Esto significa que los ratones podrían informar algoritmos de próxima generación que podrían detectar videos y audio falsos. La naturaleza podría contrarrestar la tecnología, pero sigue siendo una carrera armamentista.

Si bien los avances en la tecnología de deepfake podrían ayudar a detectar los deepfake, puede ser demasiado tarde. Una vez que la confianza se corroe en una tecnología, es casi imposible recuperarla. Si corrompemos la fe de uno en el video, ¿cuánto tiempo hasta que se pierda la fe en las noticias en la televisión, en los videos en Internet o en eventos históricos transmitidos en vivo?

"Los videos de Deepfake amenazan nuestro discurso cívico y pueden causar serios daños psíquicos y de reputación a las personas", dice Sharon Bradford Franklin, directora de políticas de Nueva América Instituto de Tecnología Abierta. "También hacen que sea aún más difícil para las plataformas involucrarse en una moderación responsable del contenido en línea".

"Si bien es comprensible que el público exija a las compañías de redes sociales que desarrollen técnicas para detectar y prevenir la propagación de las falsificaciones profundas", continúa, "también debemos evitar establecer reglas legales que presionen demasiado en la dirección opuesta y presionen a las plataformas para que participen". en censura de la libre expresión en línea ".

Si la legislación restrictiva no es la solución, ¿debería prohibirse la tecnología? Mientras muchos argumentan que sí, nuevo investigación sugiere Las GAN podrían usarse para ayudar a mejorar los "esquemas de resolución múltiple [that] permite una mejor calidad de imagen y evita los artefactos de parches "en rayos X y que otros escenarios de casos de uso médico podrían estar a la vuelta de la esquina.

¿Es eso suficiente para superar el daño? La medicina es importante. Pero también lo es garantizar los cimientos de nuestra democracia y nuestra prensa.

Cómo detectar un Deepfake

Muchos estadounidenses ya han perdido su fe en las noticias. Y a medida que la tecnología deepfake crece, los gritos de las noticias falsas solo se harán más fuertes.

"La mejor manera de protegerse de una falsificación profunda es nunca tomar un video al pie de la letra", dice Hickerson. "No podemos suponer que ver es creer. El público debe buscar de forma independiente información contextual relacionada y prestar especial atención a quién y por qué alguien comparte un video. En términos generales, las personas son descuidadas sobre lo que comparten en las redes sociales. Incluso si tu mejor amigo lo comparte, deberías pensar dónde lo consiguió. ¿Quién o cuál es la fuente original?

La solución a este problema debe ser conducida por individuos hasta que los gobiernos, tecnólogos o empresas puedan encontrar una solución. Sin embargo, si no hay un impulso inmediato para obtener una respuesta, podría ser demasiado tarde.

Lo que todos debemos hacer es exigir que las plataformas que propagan esta información rindan cuentas, que el gobierno haga esfuerzos para garantizar que la tecnología tenga suficientes casos de uso positivo para superar a los negativos, y que la educación garantice que sepamos acerca de las falsificaciones profundas y tenga suficiente sentido común para no compártelos.

De lo contrario, podemos encontrarnos en una guerra cibernética que un pirata informático comenzó basándose en nada más que un video aumentado. ¿Entonces que?

Source link