La startup del Reino Unido, Fabula AI, cree que está diseñada para que la inteligencia artificial ayude a las plataformas de contenido generadas por los usuarios a superar la crisis de desinformación que sigue sacudiendo el mundo de las redes sociales con escándalos antisociales.

Incluso Facebook Mark Zuckerberg ha hecho una nota cautelosa sobre la capacidad de la tecnología de AI para enfrentar el desafío complejo, contextual, desordenado e intrínsecamente humano de entender correctamente cada misiva que un usuario de las redes sociales puede enviar, con buenas intenciones o su mala cara.

“Llevará muchos años desarrollar completamente estos sistemas”, escribió el fundador de Facebook hace dos años, en una carta abierta en la que se discute la magnitud del desafío de moderar el contenido en plataformas con miles de millones de usuarios. “Esto es técnicamente difícil, ya que requiere la construcción de una IA que pueda leer y comprender noticias”.

Pero, ¿qué sucede si AI no necesita leer y comprender las noticias para detectar si es verdadero o falso?

Adelante, Fabula, que ha patentado lo que denomina una “nueva clase” de algoritmos de aprendizaje automático para detectar “noticias falsas”, en el campo emergente de “Aprendizaje profundo geométrico”; donde los conjuntos de datos que se van a estudiar son tan grandes y complejos que las técnicas tradicionales de aprendizaje automático tienen dificultades para encontrar información en este espacio “no euclidiano”.

La startup dice que sus algoritmos de aprendizaje profundo son, por el contrario, capaces de aprender patrones en conjuntos de datos complejos y distribuidos, como las redes sociales. Así que está facturando su tecnología como un gran avance. (Está escrito un documento sobre el enfoque que se puede descargar aquí).

Es, más bien desafortunadamente, usar el populista y ahora está mal visto en la divisa “noticias falsas” en sus relaciones públicas. Pero dice que tiene la intención de que este paraguas difuso se refiera tanto a la desinformación como a la desinformación. Lo que significa una mentalidad maliciosa y falsificaciones involuntarias. O, para decirlo de otra manera, una foto falsa con photoshop o una imagen genuina en el contexto equivocado.

El enfoque que se está tomando para detectar la desinformación no se basa en algoritmos que analicen el contenido de las noticias para tratar de identificar tonterías maliciosas, sino que analiza cómo estas cosas se propagan en las redes sociales y, por lo tanto, también quién las propaga.

Hay patrones característicos de cómo se difunden las “noticias falsas” frente al artículo genuino, dice el cofundador y científico principal de Fabula, Michael Bronstein.

“Miramos la forma en que se difunden las noticias en la red social. Y hay, yo diría, una cantidad cada vez mayor de evidencia que muestra que las noticias falsas y las noticias reales se difunden de manera diferente “, le dice a TechCrunch, señalando un reciente estudio importante realizado por académicos del MIT que encontró que las” noticias falsas “se propagan de manera diferente frente al contenido de buena fe. en Twitter.

“La esencia del aprendizaje profundo geométrico es que puede funcionar con datos estructurados en red. Así que aquí podemos incorporar datos heterogéneos como las características del usuario; las interacciones de las redes sociales entre los usuarios; la difusión de la noticia en sí; tantas características que de otra forma sería imposible tratar con técnicas de aprendizaje automático “, continúa.

Bronstein, que también es profesor en el Imperial College de Londres, Con una silla en aprendizaje automático y reconocimiento de patrones, compara el fenómeno El clasificador de aprendizaje automático de Fabula ha aprendido a detectar la forma en que la enfermedad infecciosa se propaga a través de una población.

“Este es, por supuesto, un modelo muy simplificado de cómo se propaga una enfermedad en la red. En este caso la red modela relaciones o interacciones entre personas. Así que, en cierto sentido, puedes pensar en las noticias de esta manera ”, sugiere. “Hay evidencia de polarización, hay evidencia de sesgo de confirmación. Así que, básicamente, hay lo que se llama cámaras de eco que se forman en una red social que favorece estos comportamientos “.

“Realmente no entramos, digamos, en los factores sociológicos o psicológicos que probablemente explican por qué sucede esto. Pero hay algunas investigaciones que muestran que las noticias falsas son similares a las epidemias “.

El tl; dr del estudio MIT, que examinó el valor de los tweets de una década, fue que la verdad no solo se difunde más lentamente sino que también los seres humanos están implicados en la aceleración de la desinformación. (Entonces, sí, el problema son los seres humanos reales). Ergo, no todos los robots hacen todo el trabajo pesado de amplificar la basura en línea.

El lado positivo de lo que parece ser un capricho desafortunado de la naturaleza humana es que una inclinación por difundir tonterías puede, en última instancia, ayudar a deshacerse de las cosas, lo que hace que una herramienta escalable basada en la inteligencia artificial para detectar “BS” no sea un loco sueño.

Aunque, para ser claros, la inteligencia artificial de Fabula sigue en desarrollo en esta etapa, ya que se ha probado internamente en los subconjuntos de datos de Twitter en esta etapa. Y las afirmaciones que está haciendo para su modelo de prototipo siguen siendo probadas comercialmente con clientes en la naturaleza usando la tecnología en diferentes plataformas sociales.

Sin embargo, espera llegar allí este año y tiene la intención de ofrecer una API para plataformas y editores hacia fines de este año. El clasificador AI está diseñado para ejecutarse casi en tiempo real en una red social u otra plataforma de contenido, identificando BS.

Fabula contempla su propio papel, como empresa detrás de la tecnología, como la de una “plataforma de puntuación de riesgo de verdad” abierta y descentralizada, similar a una agencia de referencia de crédito relacionada con contenido, no con efectivo.

La puntuación entra en él porque la IA genera una puntuación para clasificar el contenido según la confianza que tiene al ver una noticia falsa o verdadera.

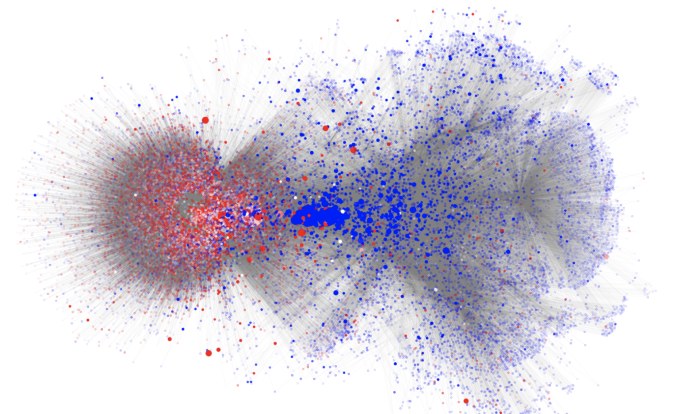

Una visualización de un patrón de distribución de noticias falso vs real; los usuarios que comparten predominantemente noticias falsas son de color rojo y los usuarios que no comparten noticias falsas son de color azul, lo que, según Fabula, muestra la clara separación en grupos distintos y “la diferencia inmediatamente reconocible en el patrón de difusión de la difusión”.

En sus propias pruebas, Fabula dice que sus algoritmos pudieron identificar el 93 por ciento de las “noticias falsas” a las pocas horas de la difusión, lo que Bronstein afirma que es “significativamente más alto” que cualquier otro método publicado para detectar “noticias falsas”. (Su cifra de precisión utiliza una medida agregada estándar del rendimiento del modelo de clasificación de aprendizaje automático, denominada AOC ROC).

El conjunto de datos que el equipo usó para entrenar su modelo es un subconjunto de la red de Twitter, compuesto por alrededor de 250,000 usuarios y que contiene alrededor de 2.5 millones de “bordes” (también conocidos como conexiones sociales).

Para su conjunto de datos de capacitación, Fabula se basó en etiquetas verdaderas / falsas adjuntas a las noticias de las ONG de verificación de datos de terceros, incluidas Snopes y PolitiFact. Y, en general, reunir el conjunto de datos fue un proceso de “muchos meses”, según Bronstein. También dice que se utilizaron alrededor de mil historias diferentes para entrenar el modelo, y agregó que el equipo confía en que el enfoque funcione en pequeñas redes sociales. , así como mega-redes de tamaño Facebook.

Al preguntarle si está seguro de que el modelo no ha sido entrenado para identificar patrones causados por propagadores de noticias basura basados en bots, dice que el conjunto de datos de capacitación incluyó a algunos usuarios registrados (y por lo tanto verificados como “verdaderos”).

“Hay varias investigaciones que muestran que los bots no jugaron una cantidad significativa [of a role in spreading fake news] porque la cantidad era solo un pequeño porcentaje. Y los bots pueden detectarse con bastante facilidad “, también sugiere, y agrega:” Por lo general, se basa en algún análisis de conectividad o análisis de contenido. Con nuestros métodos también podemos detectar bots fácilmente “.

Para verificar más a fondo el modelo, el equipo probó su desempeño a lo largo del tiempo entrenándolo en datos históricos y luego utilizando una división diferente de los datos de prueba.

“Si bien vemos cierta caída en el rendimiento, no es dramático. Así que el modelo envejece bien, básicamente. Hasta algo así como un año, el modelo aún se puede aplicar sin ningún tipo de reentrenamiento “, señala, al tiempo que dice que, cuando se aplica en la práctica, el modelo se actualizaría continuamente a medida que continúa digiriendo (¿ingiriendo?) Nuevas historias y experiencias sociales. Contenido multimedia.

De manera un tanto aterradora, el modelo también podría usarse para predecir la viralidad, según Bronstein, lo que plantea la perspectiva distópica de que el API se usa para el propósito opuesto al que se pretende: es decir, maliciosamente, por parte de proveedores de noticias falsas, para ampliar su ( Anti) Difusión social.

“Ponerlo potencialmente en malas manos podría hacer daño”, reconoce Bronstein. Aunque adopta una visión filosófica de la hiperactiva espada de doble filo de la tecnología AI, argumentando que tales tecnologías crearán un imperativo para que todos los interesados replanteen el ecosistema de noticias, y alentarán el énfasis en la educación del usuario y la enseñanza del pensamiento crítico.

Esperemos que sí. Y, en el frente educativo, Fabula espera que su tecnología pueda jugar un papel importante, al destacar la causa y el efecto basados en la red.

“Ahora a las personas les gusta o retuitean o básicamente difunden información sin pensar demasiado o el daño potencial o el daño que están haciendo a todos”, dice Bronstein, señalando nuevamente la analogía de las enfermedades infecciosas. “Es como no vacunarse a usted o a sus hijos. Si piensa un poco sobre lo que está difundiendo en una red social, podría prevenir una epidemia “.

Entonces, tl; dr, piensa antes de RT.

Volver a la tasa de precisión del modelo de Fabula, mientras que ~ 93 por ciento puede sonar bastante impresionante, si se aplicara al contenido en una red social masiva como Facebook, que tiene unos 2.3BN + usuarios, que carga lo que podrían ser trillones de contenido diariamente. – Incluso una tasa de fracaso del siete por ciento todavía haría que una gran cantidad de falsificaciones se deslicen sin ser detectadas a través de la red de la IA.

Pero Bronstein dice que la tecnología no tiene que usarse como un sistema de moderación independiente. Más bien, sugiere que podría usarse junto con otros enfoques como el análisis de contenido y, por lo tanto, funcionar como otra cadena en un arco más amplio de “detector de BS”.

También podría, sugiere, ayudar más a los revisores de contenido humano, apuntándolos a contenido potencialmente problemático más rápidamente.

Dependiendo de cómo se use la tecnología, él dice que podría eliminar la necesidad de organizaciones independientes de verificación de hechos, ya que el sistema de aprendizaje profundo puede adaptarse a diferentes casos de uso.

Ejemplos de casos de uso que menciona incluyen un filtro completamente automatizado (es decir, sin un revisor humano en el circuito); o para potenciar un sistema de clasificación de credibilidad de contenido que puede rebajar el peso de historias dudosas o incluso bloquearlas por completo; o para que la selección de contenido intermedio marque posibles noticias falsas para la atención humana.

Es probable que cada uno de esos escenarios conlleve una puntuación de confianza de verdad y riesgo diferente. Aunque la mayoría, si no todas, todavía requerirían un respaldo humano. Solo para gestionar consideraciones éticas y legales generales relacionadas con decisiones en gran medida automatizadas. (El marco GDPR de Europa tiene algunos requisitos en ese frente, por ejemplo).

Las graves fallas de Facebook en torno a la moderación del discurso de odio en Myanmar, que llevó a su propia plataforma a convertirse en un megáfono para la terrible violencia étnica, se vieron exacerbadas muy claramente por el hecho de que no tenía suficientes revisores que pudieran comprender (los muchos) idiomas y dialectos locales hablado en el pais

Por lo tanto, si la propagación y el enfoque enfocado en el usuario de Fabula resultan ser tan culturalmente universales como esperan sus creadores, podría ser capaz de levantar banderas más rápido que los cerebros humanos que carecen de las habilidades lingüísticas y el conocimiento local necesarios para analizar inteligentemente el contexto.

“Por supuesto, podemos incorporar funciones de contenido, pero no tenemos que hacerlo, no queremos”, dice Bronstein. “El método puede ser independiente del lenguaje. Así que no importa si las noticias están escritas en francés, en inglés, en italiano. Se basa en la forma en que se propagan las noticias en la red “.

Aunque también admite: “No hemos realizado ningún estudio geográfico y localizado”.

“La mayoría de las noticias que tomamos son de PolitiFact, por lo que de alguna manera se refieren principalmente a la vida política estadounidense, pero los usuarios de Twitter son globales. Así que no todos ellos, por ejemplo, tuitean en inglés. Por lo tanto, aún no tenemos en cuenta el contenido del tweet en sí o sus comentarios en el tweet; estamos viendo las características de propagación y las características del usuario “, continúa.

“Obviamente, estos serán los próximos pasos, pero suponemos que depende menos del idioma. Podría ser de alguna manera geográficamente variada. Pero estos ya serán detalles de segundo orden que podrían hacer que el modelo sea más preciso. Pero, en general, actualmente no estamos utilizando ninguna orientación geográfica o específica del lugar para el modelo.

“Pero será una cosa interesante para explorar. Así que esta es una de las cosas que veremos en el futuro “.

El enfoque de Fabula relacionado con la difusión (y la propagación) de noticias falsas ciertamente significa que hay una serie de consideraciones éticas asociadas con las que cualquier plataforma que haga uso de su tecnología tendría que ser muy sensible.

Por ejemplo, si las plataformas pueden identificar y etiquetar repentinamente a un subconjunto de usuarios como “propagadores de correo no deseado”, la siguiente pregunta obvia es ¿cómo tratarán a esas personas?

¿Los penalizarían con límites, o incluso con un bloqueo total, en su poder para compartir socialmente en la plataforma? ¿Y eso sería ético o justo, dado que no todos los que comparten noticias falsas tienen la intención maliciosa de difundir mentiras?

¿Y si resulta que hay un vínculo entre, digamos, una falta de educación y la propensión a difundir la desinformación? Como puede haber un vínculo entre la pobreza y la educación … ¿Entonces qué? ¿No es cierto que su contenido algorítmico inteligente agrava el riesgo de exacerbar las divisiones sociales injustas existentes?

Bronstein está de acuerdo en que hay importantes preguntas éticas por delante cuando se trata de cómo se utiliza un clasificador de “noticias falsas”.

“Imagine que encontramos una fuerte correlación entre la afiliación política de un usuario y esta puntuación de” credibilidad “. Entonces, por ejemplo, podemos decir con hiperactividad que si alguien es un partidario de Trump, entonces él o ella difundirá principalmente noticias falsas. Por supuesto, tal algoritmo proporcionaría una gran precisión, pero al menos éticamente podría estar equivocado “, dice cuando preguntamos sobre ética.

Confirma que Fabula no está utilizando ningún tipo de información de afiliación política en su modelo en este momento, pero es muy fácil imaginar que este tipo de clasificador se utilice para resaltar (e incluso explotar) dichos enlaces.

“Lo que es muy importante en estos problemas es no solo estar en lo correcto, por lo que es bueno que podamos cuantificar las noticias falsas con una precisión de ~ 90 por ciento, sino que también debe ser por las razones correctas”, agrega. .

La startup con sede en Londres fue fundada en abril del año pasado, aunque la investigación académica que sustenta los algoritmos ha estado en marcha durante los últimos cuatro años, según Bronstein.

La patente para su método se presentó a principios de 2016 y se otorgó en julio pasado.

Han sido financiados por $ 500,000 en fondos ángel y alrededor de otros $ 500,000 en total del Consejo Europeo de Investigación becas más becas académicas de los gigantes tecnológicos de Amazon, Google y Facebook, otorgados a través de concursos de investigación abiertos.

(Bronstein confirma que las tres compañías no tienen una participación activa en el negocio. Aunque, sin duda, Fabula espera convertirlos en clientes para su API en el futuro. Pero dice que no puede discutir ninguna discusión potencial que pueda tener con las plataformas sobre utilizando su tecnología.

Centrarse en detectar patrones en la forma en que el contenido se propaga como un mecanismo de detección tiene un inconveniente importante y obvio: solo funciona después del hecho de (algo) de difusión de contenido falso. Así que este enfoque nunca podría detener por completo la desinformación en sus pistas.

Aunque la detección de reclamaciones de Fabula es posible dentro de un período de tiempo relativamente corto, de entre dos y 20 horas después de que el contenido se haya sembrado en una red.

“Lo que mostramos es que esta propagación puede ser muy corta”, dice. “Observamos hasta 24 horas y hemos visto que solo en unas pocas horas … ya podemos hacer una predicción precisa. Básicamente aumenta y se satura lentamente. Digamos que después de cuatro o cinco horas ya estamos cerca del 90 por ciento “.

“Nunca trabajamos con algo que fuera menos de horas, pero podíamos mirar”, continúa. “Realmente depende de las noticias. Algunas noticias no se difunden tan rápido. Incluso las noticias más innovadoras no se difunden extremadamente rápido. Si observa el porcentaje de la difusión de las noticias en las primeras horas, es posible que reciba solo una pequeña fracción. La propagación generalmente se desencadena por algunos nodos importantes en la red social. Usuarios con muchos seguidores, twitteando o retwitteando. Así que hay algunos cuellos de botella clave en la red que hacen que algo sea viral o no “.

Un enfoque basado en la red para la moderación del contenido también podría servir para mejorar aún más el poder y el dominio de plataformas de contenido ya muy poderosas, al hacer que las redes sean el núcleo de la regulación de las redes sociales, es decir, si los algoritmos de detección de patrones se basan en componentes de red clave (como estructura del gráfico) para funcionar.

Así que, sin duda, puede ver por qué, incluso por encima de una necesidad empresarial apremiante, los gigantes de la tecnología al menos están interesados en respaldar la investigación académica. Especialmente cuando los políticos piden cada vez más que las plataformas de contenido en línea sean reguladas como las editoriales.

Al mismo tiempo, hay, lo que parece, algunos grandes aspectos positivos para analizar la propagación, en lugar de contenido, para fines de moderación de contenido.

Como se señaló anteriormente, el enfoque no requiere la capacitación de los algoritmos en diferentes idiomas y (aparentemente) contextos culturales, lo que lo diferencia de los sistemas de detección de desinformación basados en el contenido. Entonces, si resulta tan robusto como se afirma, debería ser más escalable.

Aunque, como señala Bronstein, el equipo ha utilizado principalmente noticias políticas de los Estados Unidos para entrenar a su clasificador inicial. Así que algunas variaciones culturales en la forma en que las personas se propagan y reaccionan a las tonterías en línea al menos siguen siendo una posibilidad.

Un desafío más seguro es la “interpretabilidad”, también conocida como explicación de lo que subyace a los patrones que la tecnología de aprendizaje profundo ha identificado a través de la difusión de noticias falsas.

Si bien la responsabilidad algorítmica es a menudo un desafío para las tecnologías de inteligencia artificial, Bronstein admite que es “más complicado” para el aprendizaje geométrico profundo.

“Podemos identificar algunas de las características que son las más características de las noticias falsas frente a las verdaderas”, sugiere cuando se le pregunta si se puede rastrear algún tipo de “fórmula” de noticias falsas a través de los datos, y señaló que, aunque aún no han intentado Para ello observaron “alguna polarización”.

“Hay básicamente dos comunidades en la red social que se comunican principalmente dentro de la comunidad y rara vez entre las comunidades”, dice. “Básicamente, es menos probable que alguien que tuitea una historia falsa sea retuiteado por alguien que mayormente tuitea historias reales. Hay una manifestación de esta polarización. Podría estar relacionado con estas teorías de cámaras de eco y varios sesgos que existen. Nuevamente no nos sumergimos en tratar de explicarlo desde un punto de vista sociológico, pero lo observamos “.

Entonces, mientras que en los últimos años se han realizado algunos esfuerzos académicos para refutar la idea de que los usuarios de las redes sociales están atrapados dentro de una burbuja de filtro que les devuelve sus propias opiniones, el análisis de Fabula sobre el panorama de las opiniones de las redes sociales sugiere que sí existen. Simplemente no encerrando a todos los usuarios de Internet.

Bronstein dice que los próximos pasos para la puesta en marcha es escalar su prototipo para poder atender múltiples solicitudes para que pueda comercializar la API en 2019, y comenzar a cobrar a los editores por un puntaje de verdad / riesgo / fiabilidad para cada pieza de contenido. anfitrión.

“Probablemente proporcionaremos algún acceso restringido, tal vez con algunos socios comerciales para probar la API, pero eventualmente nos gustaría que varias personas de diferentes empresas puedan utilizarlo”, dice la solicitud. “Potencialmente también usuarios privados – periodistas o plataformas de medios sociales o anunciantes. Básicamente queremos ser … una cámara de compensación para las noticias “.

Source link