Facebook cambiará su algoritmo de News Feed para degradar el contenido que se acerca a violar sus políticas que prohíben la desinformación, el discurso de odio, la violencia, el acoso, el clickbait para que lo vean menos personas, incluso si es muy atractivo. El cambio podría reducir enormemente el alcance de grupos políticos incendiarios, vendedores ambulantes de noticias falsas y más de las peores cosas en Facebook. Permite a la empresa ocultar lo que no quiere en la red sin adoptar una postura dura que debe defender sobre el contenido que infringe las reglas.

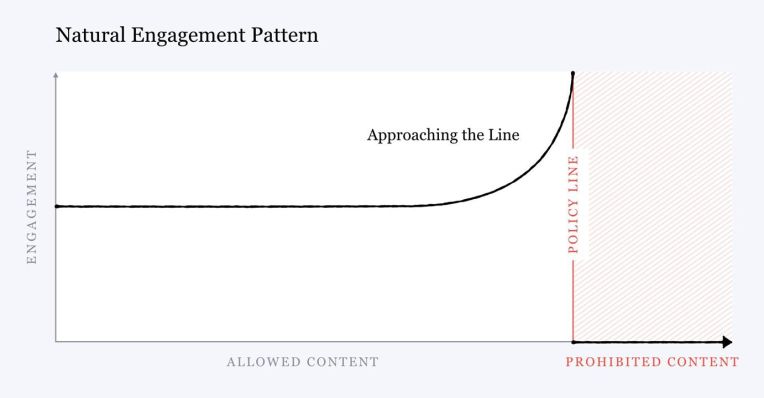

en un Carta de 5000 palabras por Mark Zuckerberg publicado hoy, explicó cómo hay un “problema básico de incentivos” que “cuando no se controla, la gente se involucrará de manera desproporcionada con contenido más sensacionalista y provocativo”. Nuestra investigación sugiere que no importa dónde tracemos las líneas para lo que está permitido, a medida que un contenido se acerca a esa línea, las personas se involucrarán más con él en promedio, incluso cuando nos digan después que no les gusta el contenido. “

Sin intervención, el compromiso con el contenido límite se parece al gráfico anterior, aumentando a medida que se acerca a la línea de política. Entonces, Facebook está interviniendo, suprimiendo artificialmente la distribución de News Feed de este tipo de contenido para que el compromiso se vea como el gráfico a continuación.

[Update: While Zuckerberg refers to the change in the past tense in one case, Facebook tells me borderline content demotion is only in effect in limited instances. The company will continue to repurpose its AI technology for proactively taking down content in violation of its policies to find and demote content that approaches the limits of those policies.]Facebook aplicará sanciones al contenido límite, no solo a las noticias, sino a todo su contenido, incluidos los grupos y las páginas, para garantizar que no radicalice a las personas recomendándoles que se unan a las comunidades porque son muy atractivas gracias a seguir la línea de la política. “Los grupos y las páginas que se dividen aún pueden alimentar la polarización”, señala Zuckerberg.

Sin embargo, los usuarios que deseen ver contenido límite a propósito tendrán la oportunidad de participar. Zuckerberg escribe que “Para aquellos que quieran tomar estas decisiones ellos mismos, creemos que deberían tener esa opción ya que este contenido no viola nuestros estándares. ” Por ejemplo, Facebook podría crear estándares flexibles para tipos de contenido como desnudez donde las normas culturales varían, como algunas costumbres prohíben a las mujeres exponer mucha piel en fotografías mientras que otras permiten desnudez en las cadenas de televisión. Sin embargo, puede pasar algún tiempo hasta que estas opciones estén disponibles, ya que Zuckerber dice que Facebook primero debe entrenar su inteligencia artificial para poder detectar de manera confiable el contenido que cruza la línea o se acerca a la frontera a propósito.

Facebook había cambiado previamente el algoritmo para degradar el clickbait. A partir de 2014, disminuyó la clasificación de los enlaces en los que las personas hicieron clic, pero rápidamente rebotaron sin volver a Me gusta en la publicación en Facebook. Para 2016, estaba analizando titulares en busca de frases de clickbait comunes, y este año prohibió los anillos de clickbait por comportamiento no auténtico. Pero ahora está dando el tratamiento de degradación a otros tipos de contenido sensacionalista. Eso podría significar publicaciones con violencia que no lleguen a mostrar lesiones físicas, o imágenes lascivas con genitales apenas cubiertos, o publicaciones que sugieran que las personas deben cometer actos de violencia por una causa sin decírselo directamente.

Facebook podría terminar expuesto a críticas, especialmente de grupos políticos marginales que dependen del contenido límite para levantar sus bases y difundir sus mensajes. Pero con la polarización y el sensacionalismo desenfrenado y destrozando a la sociedad, Facebook se ha decidido por una política de que puede tratar de defender la libertad de expresión, pero los usuarios no tienen derecho a la amplificación de ese discurso.

A continuación se muestra la de Zuckerberg declaración escrita completa en el contenido límite:

Uno de los mayores problemas que enfrentan las redes sociales es que, cuando no se controlan, las personas se involucrarán de manera desproporcionada con contenido más sensacionalista y provocativo. Esto no es un nuevo fenómeno. Actualmente, está muy extendido en las noticias por cable y ha sido un elemento básico de los tabloides durante más de un siglo. A escala, puede socavar la calidad del discurso público y conducir a la polarización. En nuestro caso, también puede degradar la calidad de nuestros servicios.

[ Graph showing line with growing engagement leading up to the policy line, then blocked ]

Nuestra investigación sugiere que no importa dónde tracemos las líneas para lo que está permitido, a medida que un contenido se acerca a esa línea, las personas se involucrarán más con él en promedio, incluso cuando nos digan después que no les gusta el contenido.

Este es un problema básico de incentivos que podemos abordar penalizando el contenido límite para que tenga menos distribución y participación. Al hacer que la curva de distribución se parezca al gráfico a continuación, donde la distribución disminuye a medida que el contenido se vuelve más sensacional, las personas se desincentivan para crear contenido provocativo que esté lo más cerca posible de la línea.

[ Graph showing line declining engagement leading up to the policy line, then blocked ]

Este proceso para ajustar esta curva es similar a lo que describí anteriormente para identificar proactivamente contenido dañino, pero ahora se enfoca en identificar contenido límite. Entrenamos a los sistemas de inteligencia artificial para que detecten el contenido límite y podamos distribuir menos ese contenido.

La categoría en la que más nos centramos es el cebo de clics y la desinformación. La gente nos dice constantemente que este tipo de contenido empeora nuestros servicios, a pesar de que interactúan con ellos. Como mencioné anteriormente, la forma más efectiva de detener la propagación de información errónea es eliminar las cuentas falsas que la generan. La siguiente estrategia más eficaz es reducir su distribución y viralidad. (Escribí sobre estos enfoques con más detalle en mi nota sobre [Preparing for Elections].)

Curiosamente, nuestra investigación ha descubierto que este patrón natural de contenido límite que obtiene más participación se aplica no solo a las noticias sino a casi todas las categorías de contenido. Por ejemplo, las fotos cercanas a la línea de la desnudez, como con ropa reveladora o posiciones sexualmente sugerentes, obtuvieron más participación en promedio antes de que cambiáramos la curva de distribución para desalentar esto. Lo mismo ocurre con las publicaciones que no entran en nuestra definición de discurso de odio, pero que siguen siendo ofensivas.

Este patrón puede aplicarse a los grupos a los que se unen las personas y también a las páginas que siguen. Esto es especialmente importante de abordar porque, si bien las redes sociales en general exponen a las personas a puntos de vista más diversos, y mientras que los grupos en general fomentan la inclusión y la aceptación, los grupos y las páginas divisivas aún pueden alimentar la polarización. Para gestionar esto, necesitamos aplicar estos cambios de distribución no solo para la clasificación de los feeds, sino también para todos nuestros sistemas de recomendación para las cosas a las que debería unirse.

Una reacción común es que en lugar de reducir la distribución, simplemente deberíamos mover la línea que define lo que es aceptable. En algunos casos, vale la pena considerar esto, pero es importante recordar que no abordará el problema subyacente de los incentivos, que a menudo es el problema más importante. Este patrón de participación parece existir sin importar dónde tracemos los límites, por lo que debemos cambiar este incentivo y no solo eliminar el contenido.

Creo que estos esfuerzos sobre los incentivos subyacentes en nuestros sistemas son algunos de los trabajos más importantes que estamos haciendo en toda la empresa. Hemos logrado un progreso significativo en el último año, pero todavía tenemos mucho trabajo por delante.

Al solucionar este problema de incentivos en nuestros servicios, creemos que creará un círculo virtuoso: al reducir el sensacionalismo en todas sus formas, crearemos un discurso más saludable y menos polarizado en el que más personas se sientan seguras al participar.

Source link