A estas alturas, probablemente haya oído hablar de las calificaciones ESG (ambiental, social, de gobernanza) de las empresas o las calificaciones de su huella de carbono. Bueno, ahora una empresa del Reino Unido ha ideado una forma de calificar la “ética” de las empresas de redes sociales.

EthicsGrade es una agencia de calificación ESG, que se centra en la gobernanza de la IA. Dirigido por Charles Radclyffe, ex director de IA en Fidelity, utiliza modelos impulsados por IA para crear una imagen más completa de los ESG de las organizaciones, aprovechando el procesamiento del lenguaje natural para automatizar el análisis de enormes conjuntos de datos. Esto incluye el seguimiento de temas controvertidos y declaraciones públicas.

Frustrado con el lavado verde de algunas acciones “ambientales”, Radclyffe se dio cuenta de que la gobernanza de la inteligencia artificial de las empresas de redes sociales no se estaba considerando adecuadamente, a pesar de presentar un enorme riesgo para los inversores a raíz de escándalos como la manipulación de Facebook por parte de empresas como como Cambridge Analytica durante las elecciones estadounidenses y el referéndum Brexit del Reino Unido.

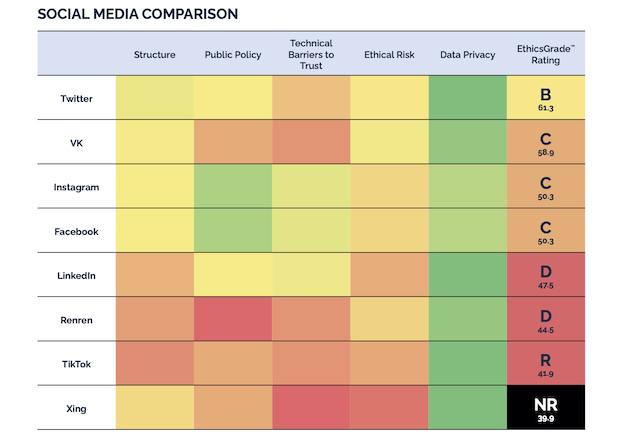

Cuadro de mando resumen de la industria EthicsGrade – Redes sociales

Créditos de imagen: Grado de Ética

La idea es que las empresas utilicen estas calificaciones para ver mejor dónde deberían mejorar. Pero el giro es que los administradores de activos también pueden ver dónde podrían estar los riesgos de la IA.

En declaraciones a TechCrunch, dijo: “Mientras estaba en Fidelity, obtuve una reputación dentro de la empresa por ser la persona a la que acudir, para mis colegas del equipo de inversión, que querían comprender los riesgos dentro de las empresas de tecnología en las que estábamos invirtiendo. Después Cuando me preguntaron varias veces sobre alguna empresa de reconocimiento facial poco fiable o una plataforma de redes sociales, me di cuenta de que en realidad había una ausencia masiva de datos sobre este tema en lugar de pruebas anecdóticas “.

Dice que cuando dejó Fidelity decidió que EthicsGrade cubriría no solo los ESG, sino también la ética de la IA para las plataformas impulsadas por algoritmos.

Me dijo: “Hemos construido un modelo para analizar la gobernanza de la tecnología. Hemos cubierto 20 industrias. Entonces, la mayor parte de lo que hemos publicado hasta ahora ha sido empresas no tecnológicas porque estos son riesgos inherentes a muchas otras industrias, además de las redes sociales o la gran tecnología. Pero durante las próximas dos semanas, publicaremos nuestros datos sobre cosas que están directamente relacionadas con la tecnología, comenzando con las redes sociales “.

Esencialmente, lo que están haciendo es un gran paralelo con lo que se está haciendo en el espacio ESG.

“La pregunta que queremos poder responder es cómo se compara TikTok con Twitter o WeChat con WhatsApp. Y lo que esencialmente hemos descubierto es que cosas como GDPR han hecho mucho bien en términos de elevar el listón en cuestiones como la privacidad y la gobernanza de los datos. Pero en muchas de las otras áreas que cubrimos, como el riesgo ético o el enfoque de una empresa hacia las políticas públicas, son de hecho cuestiones técnicas sobre la gestión de riesgos ”, dice Radclyffe.

Pero, por supuesto, son efectivamente algoritmos de calificación. ¿Las calificaciones que están otorgando a las propias plataformas sociales se derivan de algoritmos? EthicsGrade dice que están entrenando su propia IA a través de la PNL a medida que avanzan para que puedan automatizar lo que actualmente está muy centrado en los analistas humanos, al igual que “sustainalytics” et al. lo hizo hace años en el ámbito medioambiental.

Entonces, ¿cómo están llegando a estas calificaciones? EthicsGrade dice que está evaluando “la medida en que las organizaciones implementan valores transparentes y democráticos, garantizan el consentimiento informado y los protocolos de gestión de riesgos, y establecen un entorno positivo para el error y la mejora”. Y todo esto se logra a través de datos disponibles públicamente: políticas, sitios web, grupos de presión, etc. En términos simples, califican la gobernanza de la IA, no necesariamente los algoritmos en sí mismos, sino los controles y contrapesos establecidos para garantizar que los resultados y las entradas sean ético y gestionado.

“Nuestro objetivo realmente es apuntar a los propietarios y administradores de activos”, dice Radclyffe. “Entonces, si miras a cualquiera de estas firmas como, digamos Twitter, el 29% de Twitter es propiedad de cinco organizaciones: Vanguard, Morgan Stanley, Blackrock, State Street y ClearBridge. Si observa la estructura de propiedad de Facebook o Microsoft, son las mismas firmas: Fidelity, Vanguard y BlackRock. Entonces, realmente solo necesitamos ganar un par de corazones y mentes, solo tenemos que convencer a los propietarios de activos y a los administradores de activos de que preguntas como las que los periodistas han estado haciendo durante años son pertinentes y relevantes para sus carteras y así es como realmente lo hacemos. estamos planeando hacer nuestro impacto “.

Cuando se le preguntó si miran el contenido de cosas como los Tweets, dijo que no: “No miramos el contenido. Lo que nos concierne [with] es cómo gobiernan su tecnología y dónde podemos encontrar pruebas de ello. Entonces, lo que hacemos es escribir a cada empresa con nuestra calificación, con nuestra evaluación de ellos. Dejamos muy claro que se basa en datos disponibles públicamente. Y luego los invitamos a completar una encuesta. Básicamente, esa encuesta nos ayuda a validar los datos de estas empresas. Microsoft es el único que ha completado la encuesta “.

Idealmente, las empresas “verificarán la información, que tengan un proceso particular implementado para asegurarse de que las cosas estén bien administradas y que sus algoritmos no se vuelvan discriminatorios”.

En una época cada vez más impulsada por algoritmos, será interesante ver si esta idea de calificarlos por riesgo despega, especialmente entre los administradores de activos.

Source link