Facebook acaba de publicar su último informe de cumplimiento de estándares comunitarios y el veredicto está en: la gente es horrible y está feliz de compartir lo horrible que es con el mundo.

El último esfuerzo en transparencia desde Facebook. La forma en que hace cumplir sus estándares de comunidad contiene varias pepitas interesantes. Si bien los algoritmos y los moderadores internos de la compañía se han vuelto extremadamente buenos para rastrear innumerables violaciones antes de que se reporten a la compañía, el discurso de odio, el acoso en línea, el acoso y los matices de la agudeza interpersonal aún tienen a la compañía desconcertada.

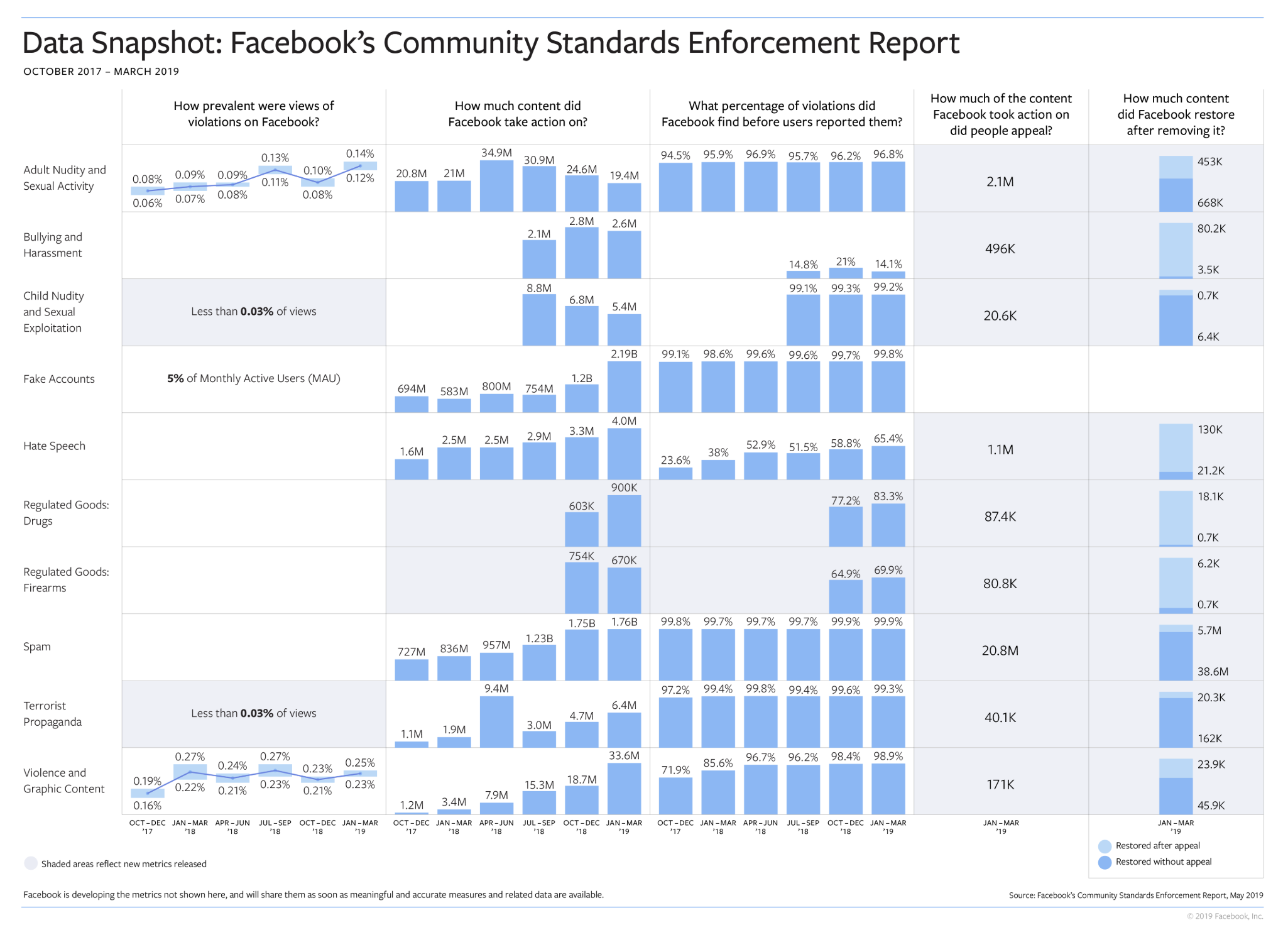

En la mayoría de los casos, Facebook puede imponer sus propios estándares y capturas entre el 90% y más del 99% de las violaciones a los estándares de la comunidad. Pero esos números son mucho más bajos para la intimidación, donde Facebook solo capturó el 14% de los 2.6 millones de casos de acoso reportados; y discurso de odio, donde la compañía marcó internamente el 65,4% de los 4,0 millones de momentos de usuarios de discurso de odio informados.

Con mucho, la violación más común de los estándares de la comunidad, y la que es potencialmente más preocupante en la elección de 2020, es la creación de cuentas falsas. En el primer trimestre del año, Facebook encontró y eliminó 2,19 mil millones de cuentas falsas. Eso es un aumento de 1.000 millones de cuentas falsas creadas en el primer trimestre del año.

Los spammers también intentan aprovechar la red social de Facebook, y la compañía eliminó casi 1,76 mil millones de instancias de contenido spam en el primer trimestre.

Para obtener una ventana real a la verdadera perversidad que pueden lograr las personas, existen estadísticas de la compañía sobre la eliminación de la pornografía infantil y la violencia gráfica. La compañía dijo que tenía que eliminar 5.4 millones de piezas de contenido que representaban desnudos infantiles o explotación sexual y que había 33.6 millones de derribos de contenido violento o gráfico.

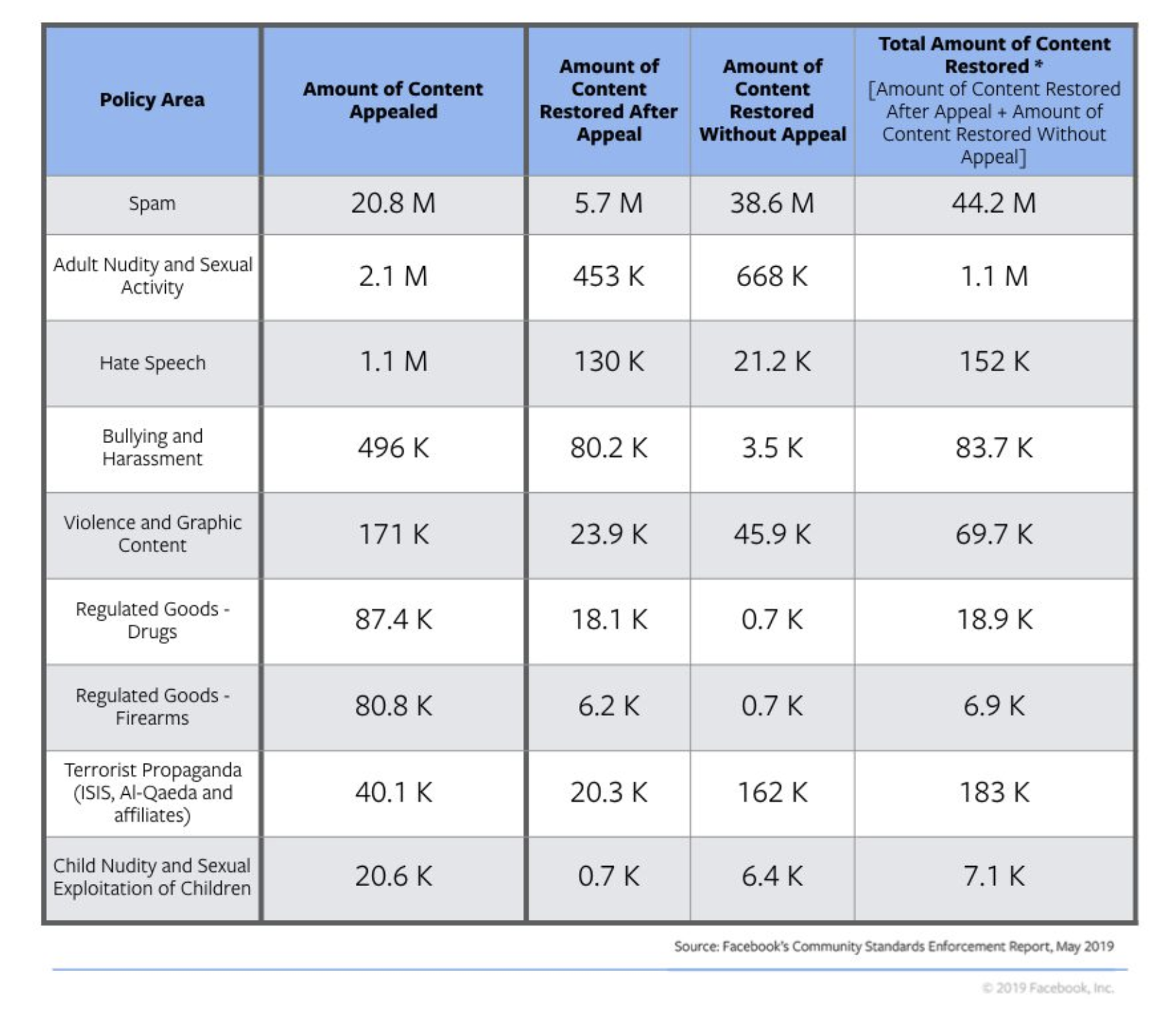

Curiosamente, las áreas donde Facebook es más débil con respecto a la moderación interna son también los lugares donde es menos probable que la empresa revierta una decisión sobre la eliminación de contenido. Si bien las publicaciones que contienen discursos de odio se encuentran entre los tipos de contenido más apelados, tienen menos probabilidades de ser restauradas. Facebook se revirtió 152,000 veces de los 1.1 millones de apelaciones que escuchó relacionadas con el discurso del odio. Otras áreas en las que la compañía parecía inmune a la discusión eran las publicaciones relacionadas con la venta de bienes regulados como armas y drogas.

En un nuevo intento de reforzar su credibilidad y transparencia, la compañía también publicó un resumen de los hallazgos de un panel independiente diseñado para dar su opinión sobre los informes de Facebook y las directrices de la comunidad.

Facebook resumió los hallazgos del informe de 44 páginas diciendo que la comisión validó el enfoque de Facebook para la moderación del contenido y que sus auditorías estaban bien diseñadas "si se ejecutan como se describe".

El grupo también recomendó que Facebook desarrolle procesos más transparentes y una mayor participación de los usuarios en el desarrollo de políticas de pautas comunitarias.

Las recomendaciones también pidieron que Facebook incorpore más de las métricas de informes utilizadas por las autoridades policiales cuando rastrean el crimen.

"La policía observa cuántas personas fueron víctimas de un delito, pero también observa cuántos hechos delictivos conoció la policía, cuántos delitos se pudieron haber cometido sin que la policía lo supiera y cuántas personas cometieron delitos", según una publicación de blog de Radha Iyengar Plumb de Facebook, responsable de Investigación de Políticas de Producto. "El grupo recomienda que proporcionemos métricas adicionales como estas, sin dejar de señalar que nuestras mediciones y metodología actuales son sólidas".

Finalmente, el informe recomendó una serie de pasos para mejorar Facebook, que la compañía resumió a continuación:

- Mediciones adicionales que podríamos proporcionar que muestren nuestros esfuerzos para hacer cumplir nuestras políticas, como la precisión de nuestro cumplimiento y la frecuencia con la que las personas no están de acuerdo con nuestras decisiones.

- Desglose adicional de las métricas que ya proporcionamos, como la prevalencia de ciertos tipos de violaciones en áreas particulares del mundo, o la cantidad de contenido que eliminamos en comparación con la aplicación de una pantalla de advertencia cuando la incluimos en nuestra métrica de contenido.

- Formas de facilitar que las personas que usan Facebook se mantengan actualizadas sobre los cambios que realizamos en nuestras políticas y tengan más voz sobre qué contenido infringe nuestras políticas y qué no.

Mientras tanto, los ejemplos de cómo se vería la regulación para garantizar que Facebook está tomando los pasos correctos de una manera que sea responsable ante los países en los que opera están empezando a proliferar.

Es difícil moderar una red social más grande que la de los países más poblados del mundo, pero la responsabilidad y la transparencia son fundamentales para evitar que los problemas que existen en esas redes echen raíces permanentes y físicas en los países donde opera Facebook.

Source link