A principios de este año, en la conferencia anual de desarrolladores de E / S de Google, la empresa introducido un nuevo hito de IA llamado Modelo Unificado Multitarea, o MUM. Esta tecnología puede comprender simultáneamente información en una amplia gama de formatos, incluidos texto, imágenes y videos, y extraer conocimientos y conexiones entre temas, conceptos e ideas. Hoy, Google anunció una de las formas en que planea poner a trabajar a MUM en sus propios productos con una actualización de su búsqueda visual de Google Lens.

Google Lens es la tecnología de reconocimiento de imágenes de la compañía que le permite usar la cámara del teléfono para realizar una variedad de tareas, como traducción en tiempo real, identificar plantas y animales, copiar y pegar fotos, encontrar elementos similares a los que están en el visor de la cámara, obtener ayuda con problemas de matemáticas y mucho más.

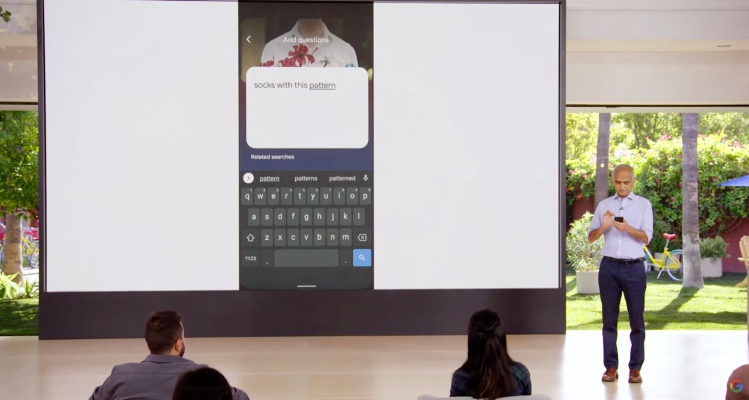

Pronto, Google dice que aprovechará las capacidades de MUM para actualizar Google Lens con la capacidad de agregar texto a las búsquedas visuales para permitir a los usuarios hacer preguntas sobre lo que ven.

En la práctica, así es como podría funcionar una característica de este tipo. Puede sacar una foto de una camisa que le guste en la Búsqueda de Google, luego tocar el ícono de Lente y pedirle a Google que busque el mismo patrón, pero en un par de calcetines. Al escribir algo como “calcetines con este patrón”, podría indicarle a Google que encuentre consultas relevantes de una manera que podría haber sido más difícil de hacer si solo hubiera utilizado la entrada de texto.

Créditos de imagen: Google

Esto podría ser particularmente útil para el tipo de consultas con las que Google lucha hoy en día, donde hay un componente visual de lo que está buscando que es difícil de describir usando solo palabras o que podría describirse de diferentes maneras. Al combinar la imagen y las palabras en una sola consulta, Google puede tener una mejor oportunidad de ofrecer resultados de búsqueda relevantes.

En otro ejemplo, una parte de su bicicleta se ha roto y necesita buscar en Google consejos de reparación. Sin embargo, no sabes cómo se llama la pieza. En lugar de profundizar en los manuales de reparación, puede apuntar Google Lens a la parte rota de su bicicleta y luego escribir “cómo reparar”. Esto podría conectarlo directamente con el momento exacto en un video que podría ayudar.

Créditos de imagen: Google

La empresa ve estas iniciativas impulsadas por la inteligencia artificial como formas de hacer que sus productos sean “más útiles” para los usuarios finales al permitir nuevas formas de búsqueda. Al hacer uso de la cámara del teléfono como parte de la búsqueda, Google tiene como objetivo mantenerse relevante en un mercado donde muchos de sus casos de uso principales están comenzando a cambiar a otras propiedades. Por ejemplo, muchas búsquedas de compras en la actualidad ahora empieza directamente en Amazon. Y cuando los usuarios de iPhone necesitan hacer algo específico en su teléfono, a menudo recurren a Siri, Spotlight, la App Store o una aplicación nativa para obtener ayuda. Y Apple es desarrollando su propia alternativa a la Búsqueda de Google también. Podías ver los inicios de este trabajo en el iOS 15 actualizar a la búsqueda de Spotlight, que ahora conecta directamente a los usuarios con la información que necesitan sin necesidad de una consulta de Google.

Google dice que también está poniendo a trabajar a MUM de otras maneras en la Búsqueda de Google y las búsquedas de videos, anunció la compañía en su Busca en evento en vivo hoy.

La actualización de Google Lens se implementará en los próximos meses, señalando que aún debe pasar por “pruebas y evaluaciones rigurosas”, que es parte de cada nuevo modelo de inteligencia artificial que implementa.