La escala de la supercomputación se ha vuelto casi demasiado grande para comprenderla, con millones de unidades de cómputo que realizan cálculos a tasas que requieren, por primera vez, exa prefijo: denota cuatrillones por segundo. ¿Cómo se logró esto? Con una planificación cuidadosa … y muchos cables, dicen dos personas cercanas al proyecto.

Habiendo notado la noticia de que Intel y el Laboratorio Nacional de Argonne estaban planeando quitar el envoltorio de una nueva computadora exascale llamada Aurora (una de varias que se está construyendo en los EE. UU.) A principios de este año, recientemente tuve la oportunidad de hablar con Trish Damkroger, jefe de Intel's Extreme Computing Organization y Rick Stevens, director asociado de laboratorio de Argonne para informática, medio ambiente y ciencias de la vida.

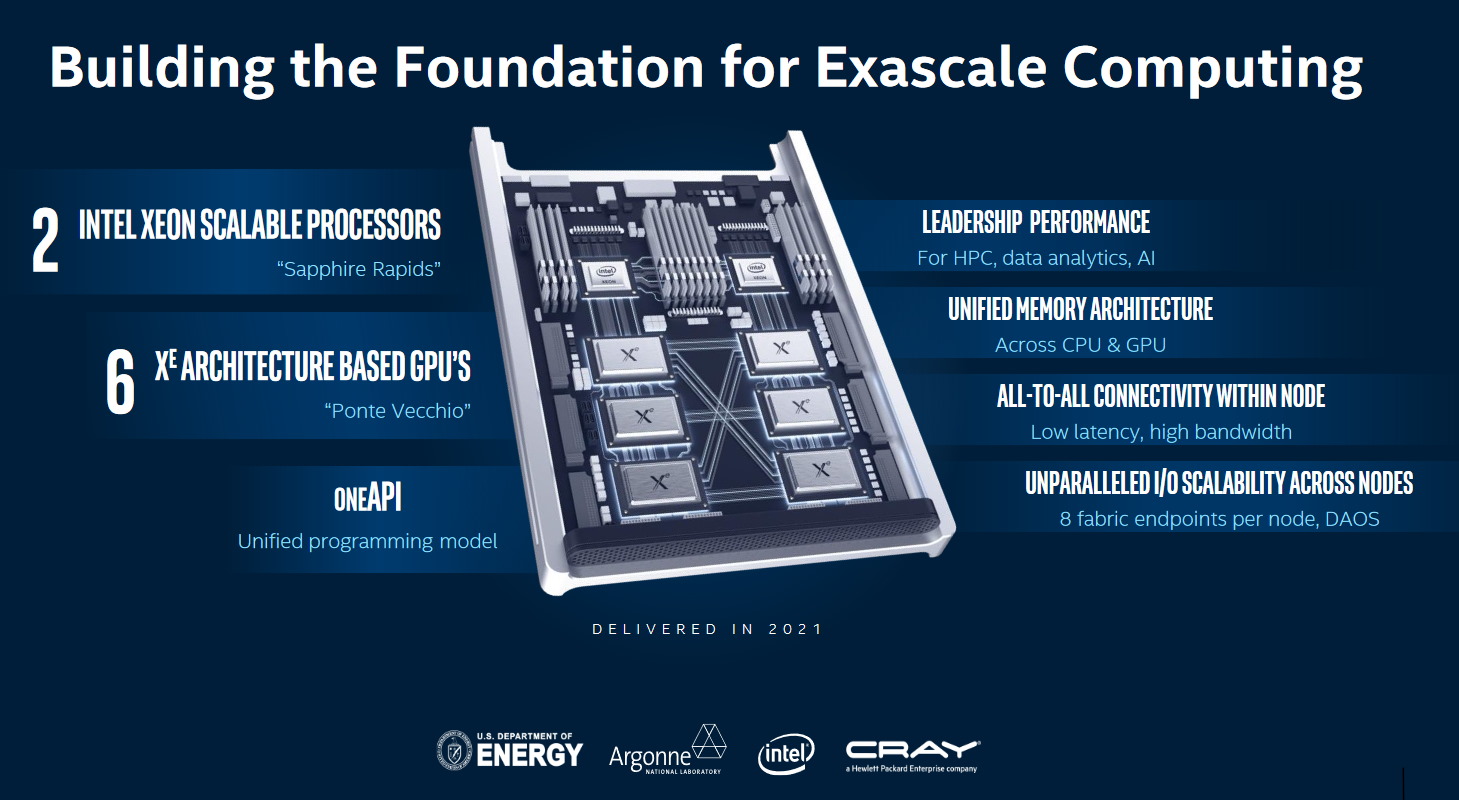

Los dos discutieron los detalles técnicos del sistema en la conferencia de Supercomputación en Denver, donde, probablemente, la mayoría de las personas que realmente pueden decir que entienden este tipo de trabajo ya lo estaban. Entonces, si bien puede leer en revistas de la industria y el comunicado de prensa sobre los aspectos básicos del sistema, incluida la nueva arquitectura Xe de Intel y el chip de cómputo de propósito general Ponte Vecchio, traté de obtener un poco más del panorama general de los dos.

No debería sorprender a nadie que este es un proyecto en proceso, pero es posible que no adivine exactamente cuánto tiempo: más de una década. Parte del desafío, entonces, era establecer hardware informático que fuera de las ligas más allá de lo que era posible en ese momento.

“Exascale se inició por primera vez en 2007. En ese momento aún no habíamos alcanzado el objetivo de escala de petas, por lo que estábamos planeando como tres o cuatro magnitudes”, dijo Stevens. “En ese momento, si tuviéramos exascale, habría requerido un gigavatio de potencia, lo que obviamente no es realista. Entonces, una gran parte de alcanzar el exascale ha sido reducir el consumo de energía ”.

La arquitectura Xe centrada en la supercomputación de Intel se basa en un proceso de 7 nanómetros, que empuja el borde de la física newtoniana: comienzan a entrar en juego efectos mucho más pequeños y cuánticos. Pero cuanto más pequeñas son las puertas, menos energía toman y los ahorros microscópicos se acumulan rápidamente cuando se habla de miles de millones de ellos.

Pero eso simplemente expone otro problema: si aumenta la potencia de un procesador en 1000x, se encuentra con un cuello de botella de memoria. Es posible que el sistema pueda pensar rápido, pero si no puede acceder y almacenar datos igualmente rápido, no tiene sentido.

“Al tener una computación a nivel de exascala, pero no un ancho de banda a nivel de exabyte, terminas con un sistema muy desigual”, dijo Stevens.

Y una vez que eliminas ambos obstáculos, te encuentras con un tercero: lo que se llama concurrencia. La informática de alto rendimiento se trata igualmente de sincronizar una tarea entre un gran número de unidades informáticas como de hacer que esas unidades sean lo más potentes posible. La máquina funciona como un todo y, como tal, cada parte debe comunicarse con todas las demás, lo que se convierte en un problema a medida que aumenta la escala.

“Estos sistemas tienen muchos miles de nodos, y los nodos tienen cientos de núcleos, y los núcleos tienen miles de unidades de cálculo, por lo que hay una concurrencia de mil millones de formas”, explicó Stevens. “Tratar con eso es el núcleo de la arquitectura”.

Cómo lo hicieron, yo, al no estar completamente familiarizado con los caprichos del diseño de la arquitectura informática de alto rendimiento, ni siquiera intentaría explicarlo. Pero parecen haberlo hecho, ya que estos sistemas exascale se están poniendo en línea. La solución, solo me atreveré a decir, es esencialmente un avance importante en el lado de las redes. El nivel de ancho de banda sostenido entre todos estos nodos y unidades es asombroso.

Hacer accesible el exascale

Si bien incluso en 2007 podría predecir que eventualmente llegaríamos a procesos de tan bajo consumo de energía y un mejor ancho de banda de memoria, otras tendencias habrían sido casi imposibles de predecir, por ejemplo, la creciente demanda de inteligencia artificial y aprendizaje automático. En aquel entonces, ni siquiera era una consideración, y ahora sería una locura crear cualquier tipo de sistema informático de alto rendimiento que no estuviera al menos parcialmente optimizado para problemas de aprendizaje automático.

“Para 2023 esperamos que las cargas de trabajo de IA sean un tercio del mercado global de servidores HPC”, dijo Damkroger. “Esta convergencia AI-HPC está uniendo esas dos cargas de trabajo para resolver problemas más rápido y proporcionar una mayor comprensión”.

Con ese fin, la arquitectura del sistema Aurora está diseñada para ser flexible, al tiempo que conserva la capacidad de acelerar ciertas operaciones comunes, por ejemplo, el tipo de cálculos matriciales que constituyen una gran cantidad de ciertas tareas de aprendizaje automático.

“Pero no se trata solo del rendimiento, sino de la programabilidad”, continuó. “Uno de los grandes desafíos de una máquina exacale es poder escribir software para usar esa máquina. oneAPI va a ser un modelo de programación unificado: se basa en un estándar abierto de Open Parallel C ++, y esa es la clave para promover el uso en la comunidad “.

Summit, al momento de escribir este artículo, el sistema informático único más poderoso del mundo, es muy diferente a muchos de los desarrolladores de sistemas en los que se utiliza trabajando. Si los creadores de una nueva supercomputadora quieren que tenga un gran atractivo, deben acercarla a ser como una computadora “normal” para funcionar como sea posible.

“Es un desafío llevar paquetes basados en x86 a Summit”, señaló Stevens. “La gran ventaja para nosotros es que, debido a que tenemos nodos x86 y GPU Intel, esto básicamente va a ejecutar cada pieza de software que exista. Ejecutará software estándar, software de Linux, literalmente millones de aplicaciones “.

Pregunté sobre los costos involucrados, ya que es un misterio con un sistema como este cómo se desglosa ese presupuesto de medio billón de dólares. Realmente pensé que sería interesante saber cuánto fue, por ejemplo, RAM versus núcleos de procesamiento, o cuántas millas de cable tuvieron que correr. Aunque tanto Stevens como Damkroger se negaron a comentar, el primero notó que “el ancho de banda de enlace de retroceso en esta máquina es muchas veces el total de todo el Internet, y eso cuesta algo”.

Aurora, a diferencia de su primo El Capitán en el Laboratorio Nacional Lawrence Livermore, no será utilizada para el desarrollo de armas.

“Argonne es un laboratorio de ciencias, y es una ciencia abierta, no clasificada”, dijo Stevens. “Nuestra máquina es un recurso de usuario nacional; Tenemos personas que lo usan en todo el país. Se asigna una gran cantidad de tiempo a través de un proceso que es revisado por pares y tiene un precio para acomodar los proyectos más interesantes. Alrededor de dos tercios es eso, y el otro tercio del Departamento de Energía, pero sigue sin clasificar los problemas “.

El trabajo inicial será en ciencias climáticas, química y ciencia de datos, con 15 equipos entre ellos inscritos para proyectos importantes que se ejecutarán en Aurora; los detalles se anunciarán pronto.

Source link