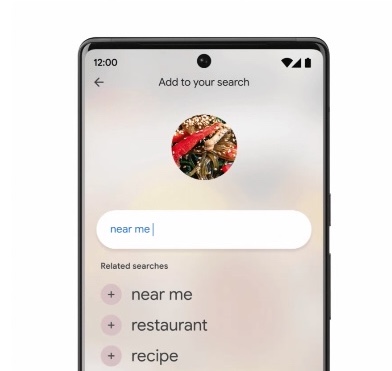

En medio de otros anuncios centrados en la IA, Google compartió hoy que su nuevo “búsqueda múltipleLa función ahora estaría disponible para usuarios globales en dispositivos móviles, en cualquier lugar donde Google Lens ya esté disponible. La función de búsqueda, que permite a los usuarios buscar usando texto e imágenes al mismo tiempo, se presentó por primera vez en abril pasado como una forma de modernizar la búsqueda de Google para aprovechar mejor las capacidades del teléfono inteligente. Una variación de esto, “búsqueda múltiple cerca de mí”, que dirige las búsquedas a empresas locales, también estará disponible a nivel mundial en los próximos meses, al igual que la búsqueda múltiple para la web y una nueva función de Lens para usuarios de Android.

Como explicó Google anteriormente, la búsqueda múltiple funciona con tecnología de inteligencia artificial llamada Modelo unificado multitarea, o MAMÁ, que puede comprender información en una variedad de formatos, incluidos texto, fotos y videos, y luego extraer información y conexiones entre temas, conceptos e ideas. Google puso a MUM a trabajar dentro de sus funciones de búsqueda visual de Google Lens, donde permitiría a los usuarios agregar texto a una consulta de búsqueda visual.

“Redefinimos lo que entendemos por búsqueda al presentar Lens. Desde entonces, llevamos Lens directamente a la barra de búsqueda y continuamos brindando nuevas capacidades, como compras y ayuda paso a paso con la tarea”, Prabhakar Raghavan, vicepresidente sénior de Google a cargo de los productos de búsqueda, asistente, información geográfica, anuncios, comercio y pagos. dijo en un evento de prensa en París.

Por ejemplo, un usuario podría ver una foto de una camisa que le gustó en la Búsqueda de Google y luego preguntarle a Lens dónde podría encontrar el mismo patrón, pero en un tipo diferente de ropa, como una falda o calcetines. O podrían apuntar su teléfono a una pieza rota en su bicicleta y escribir en la Búsqueda de Google una consulta como “cómo reparar”. Esta combinación de palabras e imágenes podría ayudar a Google a procesar y comprender las consultas de búsqueda que no podría haber manejado anteriormente, o que habrían sido más difíciles de ingresar solo con texto.

La técnica es más útil con las búsquedas de compras, donde puede encontrar la ropa que le gusta, pero en diferentes colores o estilos. O podría tomar una foto de un mueble, como un juego de comedor, para encontrar artículos que combinen, como una mesa de café. En la búsqueda múltiple, los usuarios también pueden restringir y refinar sus resultados por marca, color y atributos visuales, dijo Google.

La función se puso a disposición de los usuarios de EE. UU. en octubre pasado y luego se expandió a India en diciembre. A partir de hoy, Google dice que la búsqueda múltiple está disponible para todos los usuarios a nivel mundial en dispositivos móviles, en todos los idiomas y países donde Lens está disponible.

La variación de “búsqueda múltiple cerca de mí” también se expandirá pronto, dijo Google hoy.

Google anunció en mayo pasado que podría dirigir consultas de búsqueda múltiple a empresas locales (también conocidas como “búsqueda múltiple cerca de mí”), lo que arrojaría resultados de búsqueda de los artículos que los usuarios estaban buscando en el inventario coincidente en minoristas locales u otras empresas. Por ejemplo, en el caso de la bicicleta con la pieza rota, puede agregar el texto “cerca de mí” a una consulta de búsqueda con una foto para encontrar una tienda de bicicletas o ferretería local que tenga la pieza de repuesto que necesita.

Esta función estará disponible en todos los idiomas y países donde Lens esté disponible en los próximos meses, dijo Google. También se expandirá más allá de los dispositivos móviles con soporte para búsquedas múltiples en la web en los próximos meses.

En términos de nuevos productos de búsqueda, el gigante de las búsquedas se burló de una próxima característica de Google Lens, y señaló que los usuarios de Android pronto podrán buscar lo que ven en fotos y videos en aplicaciones y sitios web en su teléfono, mientras permanecen en la aplicación o en el sitio web. Google llama a esto “buscar en la pantalla” y dijo que también estará disponible dondequiera que se ofrezca Lens.

Google también compartió un nuevo hito para Google Lens, y señaló que las personas ahora usan la tecnología más de 10 mil millones de veces al mes.

Source link