Tan capaces como son los robots, los animales originales después de los cuales tienden a ser diseñados son siempre mucho, mucho mejores. Eso se debe en parte a que es difícil aprender a caminar como un perro directamente de un perro, pero esta investigación de los laboratorios de IA de Google hacerlo considerablemente más fácil.

El objetivo de esta investigación, una colaboración con UC Berkeley, fue encontrar una manera de transferir de manera eficiente y automática “comportamientos ágiles” como un trote ligero o un giro desde su origen (un buen perro) a un robot cuadrúpedo. Este tipo de cosas se han hecho antes, pero como señala la publicación del blog de los investigadores, el proceso de capacitación establecido a menudo puede “requerir una gran cantidad de conocimientos de expertos y, a menudo, implica un largo proceso de ajuste de recompensas para cada habilidad deseada”.

Eso no escala bien, naturalmente, pero ese ajuste manual es necesario para asegurarse de que el robot se aproxime bien a los movimientos del animal. Incluso un robot muy parecido a un perro no es en realidad un perro, y la forma en que un perro se mueve puede no ser exactamente la forma en que debería hacerlo el robot, lo que hace que este último se caiga, se bloquee o falle.

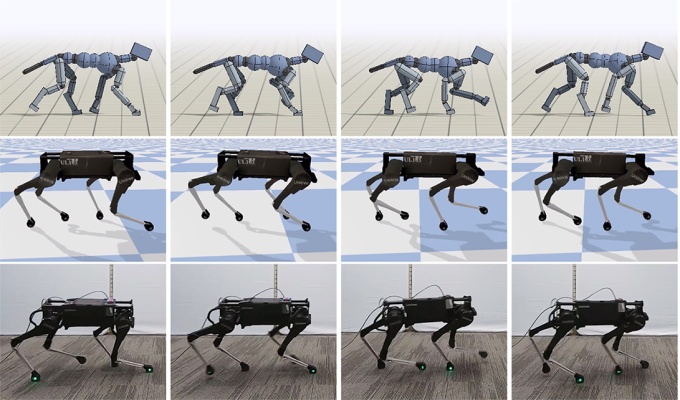

El proyecto Google AI aborda esto al agregar un poco de caos controlado al orden normal de las cosas. Por lo general, los movimientos del perro serían capturados y los puntos clave, como las patas y las articulaciones, serían cuidadosamente rastreados. Estos puntos se aproximarían a los del robot en una simulación digital, donde una versión virtual del robot intenta imitar los movimientos del perro con los suyos, aprendiendo sobre la marcha.

Hasta ahora, todo bien, pero el verdadero problema surge cuando intentas usar los resultados de esa simulación para controlar un robot real. El mundo real no es un plano 2D con reglas de fricción idealizadas y todo eso. Desafortunadamente, eso significa que los pasos basados en simulación no corregidos tienden a hacer que un robot caiga directamente al suelo.

Para evitar esto, los investigadores introdujeron un elemento de aleatoriedad en los parámetros físicos utilizados en la simulación, haciendo que el robot virtual pesara más, tuviera motores más débiles o experimentara una mayor fricción con el suelo. Esto hizo que el modelo de aprendizaje automático que describe cómo caminar tuviera que tener en cuenta todo tipo de pequeñas variaciones y las complicaciones que crean en el futuro, y cómo contrarrestarlas.

Aprender a adaptarse a esa aleatoriedad hizo que el método de caminar aprendido fuera mucho más sólido en el mundo real, lo que llevó a una imitación aceptable del paseo del perro objetivo y a movimientos aún más complicados como giros y vueltas, sin ninguna intervención manual y solo un poco más de virtualidad. capacitación.

Naturalmente, aún se pueden agregar ajustes manuales a la mezcla si se desea, pero tal como está, es una gran mejora con respecto a lo que anteriormente se podía hacer de forma totalmente automática.

En otro proyecto de investigación descrito en la misma publicación, otro grupo de investigadores describe un robot que se enseña a sí mismo a caminar por sí mismo, pero imbuido de la inteligencia para evitar caminar fuera de su área designada y para levantarse cuando cae. Con esas habilidades básicas incorporadas, el robot pudo deambular por su área de entrenamiento continuamente sin intervención humana, aprendiendo habilidades de locomoción bastante respetables.

El documento sobre el aprendizaje de comportamientos ágiles de los animales se puede leer aquímientras que el de los robots que aprenden a caminar solos (una colaboración con Berkeley y el Instituto de Tecnología de Georgia) es aquí.

Source link