La sociedad civil ha estado estudiando detenidamente los detalles de la propuesta de la Comisión Europea de un marco basado en el riesgo para regular las aplicaciones de inteligencia artificial que fue propuesta por el ejecutivo de la UE en abril.

El veredicto de más de cien organizaciones de la sociedad civil es que el proyecto de ley está muy lejos de proteger los derechos fundamentales de los daños provocados por la IA, como la discriminación a gran escala y el sesgo de caja negra, y han publicó una convocatoria de revisiones importantes.

“Reconocemos específicamente que los sistemas de IA exacerban los desequilibrios estructurales de poder, y los daños a menudo recaen sobre los más marginados de la sociedad. Como tal, esta declaración colectiva establece el llamado de 11[5] organizaciones de la sociedad civil hacia una Ley de Inteligencia Artificial que ponga en primer plano los derechos fundamentales”, escriben, e identifican nueve “objetivos” (cada uno con una variedad de revisiones sugeridas) en la declaración completa de recomendaciones.

La Comisión, que redactó la legislación, presentó el reglamento de IA como un marco para la inteligencia artificial “confiable” y “centrada en el ser humano”. Sin embargo, corre el riesgo de acercarse bastante a un marco propicio para el abuso basado en datos, según el análisis de los grupos de la sociedad civil, dada la falta de controles y equilibrios esenciales para prevenir daños automatizados.

La declaración de hoy fue redactada por European Digital Rights (EDRi), Access Now, Panoptykon Foundation, epicenter.works, AlgorithmWatch, European Disability Forum (EDF), Bits of Freedom, Fair Trials, PICUM y ANEC, y ha sido firmada por un pleno 115 organizaciones sin ánimo de lucro de toda Europa y más allá.

Los grupos de defensa esperan que sus recomendaciones sean recogidas por el Parlamento Europeo y el Consejo mientras los colegisladores continúan debatiendo y modificando la propuesta de la Ley de Inteligencia Artificial (AIA) antes de que se adopte y aplique cualquier texto final en toda la UE.

Las sugerencias clave de las organizaciones de la sociedad civil incluyen la necesidad de enmendar la regulación para tener un enfoque flexible y preparado para el futuro para evaluar los riesgos impulsados por la IA, lo que significa que permitiría actualizar la lista de casos de uso que se consideran inaceptables ( y por tanto prohibidos) y aquellos que la regulación se limita a limitar, así como la posibilidad de ampliar la lista (actualmente fijada) de los usos denominados de “alto riesgo”.

La propuesta de la Comisión para categorizar los riesgos de la IA es demasiado “rígida” y está mal diseñada (la declaración de los grupos la llama literalmente “disfuncional”) para seguir el ritmo de las tecnologías de IA iterativa y de rápido desarrollo y los casos de uso cambiantes de las tecnologías basadas en datos, en el punto de vista de las ONG.

“Este enfoque de designación ex ante de sistemas de IA para diferentes categorías de riesgo no considera que el nivel de riesgo también depende del contexto en el que se implementa un sistema y no puede determinarse completamente por adelantado”, escriben. “Además, si bien la AIA incluye un mecanismo mediante el cual se puede actualizar la lista de sistemas de IA de ‘alto riesgo’, no brinda margen para actualizar las listas de ‘inaceptable’ (Art. 5) y riesgo limitado (Art. 52).

“Además, aunque el Anexo III se puede actualizar para agregar nuevos sistemas a la lista de sistemas de IA de alto riesgo, los sistemas solo se pueden agregar dentro del alcance de los ocho títulos de área existentes. Actualmente, dichos epígrafes no pueden ser modificados en el marco de la AIA. Estos aspectos rígidos del marco socavan la relevancia duradera de la AIA y, en particular, su capacidad para responder a futuros desarrollos y riesgos emergentes para los derechos fundamentales”.

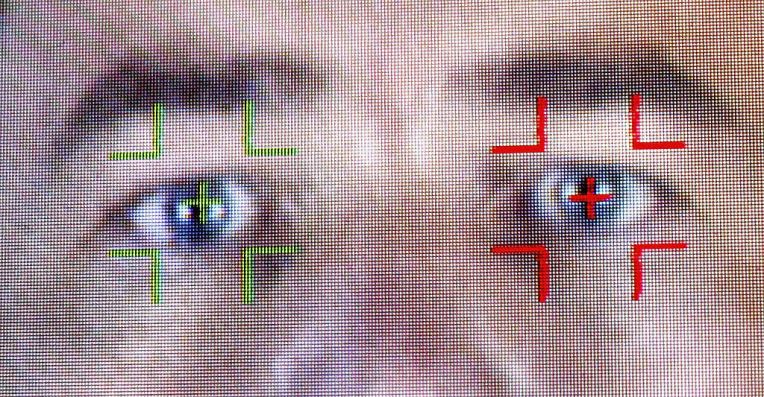

También han criticado a la Comisión por su falta de ambición al enmarcar casos de uso prohibidos de IA, instando a una “prohibición total” de todos los sistemas de puntuación de puntuación social; en toda la identificación biométrica remota en espacios de acceso público (no solo límites estrechos sobre cómo las fuerzas del orden pueden usar la tecnología); en todos los sistemas de reconocimiento de emociones; sobre toda categorización biométrica discriminatoria; en toda la fisonomía de la IA; en todos los sistemas utilizados para predecir futuras actividades delictivas; y en todos los sistemas para perfilar y evaluar riesgos en un contexto migratorio, defendiendo prohibiciones “en todos los sistemas de IA que representen un riesgo inaceptable para los derechos fundamentales”.

Sobre esto, las recomendaciones de los grupos se hacen eco de los pedidos anteriores para que la regulación vaya más allá y prohíba por completo la vigilancia biométrica remota, incluso del supervisor de protección de datos de la UE.

Los grupos de la sociedad civil también quieren que las obligaciones regulatorias se apliquen a los usuarios de sistemas de IA de alto riesgo, no solo a los proveedores (desarrolladores), y piden que los usuarios tengan la obligación de realizar y publicar una evaluación de impacto en los derechos fundamentales para garantizar que la rendición de cuentas en torno a los riesgos no pueda ser eludida por el enfoque predominante de la regulación en los proveedores.

Después de todo, una tecnología de IA que se desarrolla para un propósito ostensible podría aplicarse para un caso de uso diferente que plantea distintos riesgos de derechos.

Por lo tanto, quieren obligaciones explícitas para los usuarios de IA de “alto riesgo” de publicar evaluaciones de impacto, que, según dicen, deberían cubrir los impactos potenciales en las personas, los derechos fundamentales, el medio ambiente y el interés público en general.

“Si bien parte del riesgo que plantean los sistemas enumerados en el Anexo III proviene de cómo están diseñados, los riesgos significativos se derivan de cómo se utilizan. Esto significa que los proveedores no pueden evaluar de manera integral el impacto potencial total de un sistema de IA de alto riesgo durante la evaluación de la conformidad y, por lo tanto, los usuarios también deben tener la obligación de defender los derechos fundamentales”, instan.

También abogan por que los requisitos de transparencia se extiendan a los usuarios de sistemas de alto riesgo, sugiriendo que deberían tener que registrar el uso específico de un sistema de IA en una base de datos pública que la regulación propone establecer para los proveedores de dicho sistema.

“La base de datos de la UE para sistemas autónomos de IA de alto riesgo (Art. 60) brinda una oportunidad prometedora para aumentar la transparencia de los sistemas de IA frente a las personas afectadas y la sociedad civil, y podría facilitar enormemente la investigación de interés público. Sin embargo, la base de datos actualmente solo contiene información sobre sistemas de alto riesgo registrados por proveedores, sin información sobre el contexto de uso”, escriben, advirtiendo: “Esta laguna socava el propósito de la base de datos, ya que evitará que el público se entere. dónde, por quién y con qué propósito (s) se utilizan realmente los sistemas de IA de alto riesgo”.

Otra recomendación aborda una crítica clave de la sociedad civil al marco propuesto: que no ofrece derechos a las personas ni vías de reparación cuando se ven afectadas negativamente por la IA.

Esto marca una desviación sorprendente de la ley de protección de datos de la UE existente, que confiere una serie de derechos a las personas adjuntas a sus datos personales y, al menos en papel, les permite buscar reparación por infracciones, así como que terceros busquen reparación en nombre de los individuos. (Además, el Reglamento General de Protección de Datos incluye disposiciones relacionadas con el tratamiento automatizado de datos personales; el artículo 22 otorga a las personas sujetas a decisiones con un efecto legal o similar que se basen únicamente en la automatización el derecho a la información sobre el tratamiento; y/o a solicitar una revisión humana o impugnar la decisión).

La falta de “significado de derechos y compensación” para las personas afectadas por los sistemas de IA representa un gran vacío en la capacidad del marco para protegerse contra la automatización de alto riesgo de daños crecientes, argumentan los grupos.

“Actualmente, la AIA no confiere derechos individuales a las personas afectadas por los sistemas de IA, ni contiene ninguna disposición para la reparación individual o colectiva, o un mecanismo por el cual las personas o la sociedad civil puedan participar en el proceso de investigación de los sistemas de IA de alto riesgo. Como tal, la AIA no aborda por completo los innumerables daños que surgen de la opacidad, la complejidad, la escala y el desequilibrio de poder en los que se implementan los sistemas de IA”, advierten.

Están recomendando que se modifique la legislación para incluir dos derechos individuales como base para los recursos judiciales, a saber:

(a) El derecho a no estar sujeto a sistemas de IA que representen un riesgo inaceptable o no cumplan con la Ley; y (b) El derecho a recibir una explicación clara e inteligible, de manera accesible para las personas con discapacidad, de las decisiones tomadas con la asistencia de los sistemas dentro del alcance de la AIA;

También sugieren el derecho a un “recurso efectivo” para aquellos cuyos derechos se infringen “como resultado de la puesta en servicio de un sistema de IA”. Y, como era de esperar, las organizaciones de la sociedad civil quieren un mecanismo para que los grupos de interés público como ellos mismos puedan presentar una queja ante las autoridades nacionales de supervisión por una violación o en relación con los sistemas de IA que socavan los derechos fundamentales o el interés público: que especifican deben desencadenar una investigación. (Las quejas de GDPR simplemente ignoradas por los órganos de supervisión es un problema importante con la aplicación efectiva de ese régimen).

Otras recomendaciones en la declaración de los grupos incluyen la necesidad de que se considere la accesibilidad a lo largo del ciclo de vida del sistema de IA, y señalan la falta de requisitos de accesibilidad en la regulación, advirtiendo que los riesgos que conducen al desarrollo y uso de IA con “barreras adicionales para Personas con discapacidades”; también quieren límites explícitos para garantizar que las normas armonizadas de seguridad de los productos que el reglamento propone delegar en organismos privados de normalización solo cubran aspectos “genuinamente técnicos” de los sistemas de IA de alto riesgo (para que las decisiones políticas y de derechos fundamentales “permanezcan firmemente dentro del escrutinio democrático de los legisladores de la UE”, como ellos mismos lo expresan); y quieren que los requisitos para los usuarios y proveedores del sistema de IA se apliquen no solo cuando los resultados se aplican dentro de la UE sino también en otros lugares, “para evitar el riesgo de discriminación, vigilancia y abuso a través de tecnologías desarrolladas en la UE”.

La sostenibilidad y la protección del medio ambiente también se han pasado por alto, según la evaluación de los grupos.

Sobre eso, piden “requisitos de transparencia horizontales y de cara al público sobre el consumo de recursos y los impactos de las emisiones de gases de efecto invernadero de los sistemas de IA”, independientemente del nivel de riesgo; y cubre el diseño del sistema de IA, la gestión y capacitación de datos, la aplicación y las infraestructuras subyacentes (hardware, centros de datos, etc.).

La Comisión Europea justifica con frecuencia su objetivo de fomentar la actualización de la IA promocionando la automatización como una tecnología clave para permitir la transición buscada por el bloque a un continente “climáticamente neutral” para 2050; sin embargo, el propio consumo de energía y recursos de la IA es un componente muy pasado por alto. de estos llamados sistemas ‘inteligentes’. Sin requisitos sólidos de auditoría ambiental que también se apliquen a la IA, es simplemente relaciones públicas afirmar que la IA proporcionará la respuesta al cambio climático.

Se ha contactado a la Comisión para obtener una respuesta a las recomendaciones de la sociedad civil.

El mes pasado, los eurodiputados del Parlamento Europeo votaron a favor de la prohibición total de las tecnologías de vigilancia biométrica remota, como el reconocimiento facial, la prohibición del uso de bases de datos privadas de reconocimiento facial y la prohibición de la vigilancia predictiva basada en datos de comportamiento.

También votaron a favor de prohibir los sistemas de puntuación social que buscan calificar la confiabilidad de los ciudadanos en función de su comportamiento o personalidad, y prohibir que la IA ayude en las decisiones judiciales, otra área muy controvertida donde ya se ha aplicado la automatización.

Por lo tanto, es probable que los eurodiputados tomen nota detenidamente de las recomendaciones de la sociedad civil mientras trabajan en las enmiendas a la Ley de IA.

Paralelamente, el Consejo está en proceso de determinar su mandato de negociación sobre la regulación, y las propuestas actuales están presionando para que las empresas privadas prohíban la puntuación social, pero buscan excepciones para la I + D y los usos de seguridad nacional de la IA.

Las discusiones entre la Comisión, el Parlamento y el Consejo determinarán la forma final del reglamento, aunque el parlamento también debe aprobar el texto final del reglamento en una votación plenaria, por lo que las opiniones de los eurodiputados jugarán un papel clave.