Los rostros renderizados en 3D son una gran parte de cualquier película o juego importante ahora, pero la tarea de capturarlos y animarlos de forma natural puede ser difícil. Disney Research está trabajando en formas de suavizar este proceso, entre ellas una herramienta de aprendizaje automático que lo convierte en mucho más fácil de generar y manipular caras 3D sin sumergirse en el valle inquietante.

Por supuesto, esta tecnología ha recorrido un largo camino desde las expresiones de madera y los detalles limitados de días anteriores. Los rostros 3D convincentes de alta resolución se pueden animar rápidamente y bien, pero las sutilezas de la expresión humana no solo son ilimitadas en variedad, son muy fáciles de equivocar.

Piense en cómo cambia todo el rostro de una persona cuando sonríe; es diferente para todos, pero hay suficientes similitudes que nos imaginamos que podemos decir cuando alguien está “realmente” sonriendo o simplemente fingiendo. ¿Cómo se puede lograr ese nivel de detalle en un rostro artificial?

Los modelos “lineales” existentes simplifican la sutileza de la expresión, haciendo que la “felicidad” o la “ira” se puedan ajustar minuciosamente, pero a costa de la precisión: no pueden expresar todos los rostros posibles, pero pueden resultar fácilmente en rostros imposibles. Los modelos neuronales más nuevos aprenden complejidad al observar la interconexión de las expresiones, pero al igual que otros modelos similares, su funcionamiento es oscuro y difícil de controlar, y quizás no generalizable más allá de las caras de las que aprendieron. No permiten el nivel de control que necesita un artista que trabaja en una película o un juego, ni dan como resultado caras que (los humanos son notablemente buenos para detectar esto) simplemente están fuera de lugar de alguna manera.

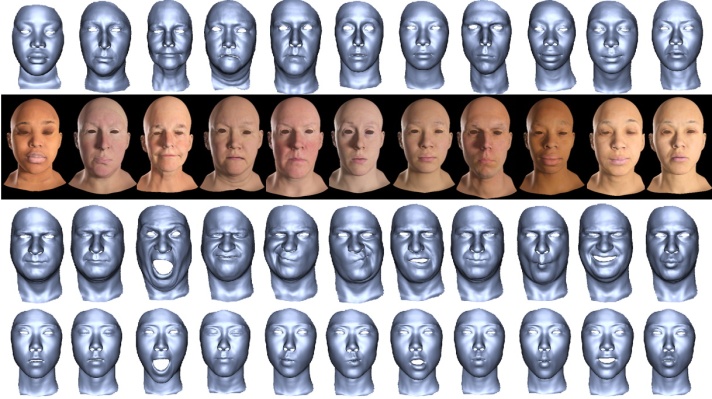

Un equipo de Disney Research propone un nuevo modelo con lo mejor de ambos mundos, lo que llama un “modelo semántico de rostro profundo”. Sin entrar en la ejecución técnica exacta, la mejora básica es que es un modelo neuronal que aprende cómo una expresión facial afecta a todo el rostro, pero no es específico de un solo rostro, y además no es lineal, lo que permite flexibilidad en la forma en que las expresiones interactúan con un rostro. geometría de la cara y entre sí.

Piénselo de esta manera: un modelo lineal le permite tomar una expresión (una sonrisa o un beso, digamos) de 0 a 100 en cualquier rostro en 3D, pero los resultados pueden no ser realistas. Un modelo neuronal le permite tomar una expresión aprendida de 0 a 100 de manera realista, pero solo en la cara de la que lo aprendió. Este modelo puede tomar una expresión de 0 a 100 sin problemas en cualquier rostro 3D. Eso es una simplificación excesiva, pero entiendes la idea.

Créditos de imagen: Investigación de Disney

Los resultados son poderosos: podrías generar mil caras con diferentes formas y tonos, y luego animarlas todas con las mismas expresiones sin ningún trabajo extra. Piense en cómo eso podría resultar en diversas multitudes de CG que puede convocar con un par de clics, o personajes en juegos que tienen expresiones faciales realistas, independientemente de si fueron hechos a mano o no.

No es una solución mágica, y es solo parte de un gran conjunto de mejoras que los artistas e ingenieros están haciendo en las diversas industrias donde se emplea esta tecnología: seguimiento facial sin marcadores, mejor deformación de la piel, movimientos oculares realistas y docenas más de áreas de interés. partes importantes de este proceso.

El artículo de Disney Research se presentó en la Conferencia Internacional sobre Visión 3D; puedes leer la cosa completa aquí.

Source link