El último CES fue un momento de ajuste de cuentas para las empresas lidar, muchas de las cuales se estaban hundiendo debido a la falta de demanda de una industria de vehículos autónomos (aún) inexistente. Los pocos que sobresalieron lo hicieron especializándose, y este año la tendencia ha ido más allá del lidar, con nuevos métodos de detección e imágenes que empujan a competir y complementar la tecnología basada en láser.

Lidar se adelantó a las cámaras tradicionales porque podía hacer cosas que ellos no podían, y ahora algunas empresas están presionando para hacer lo mismo con tecnología que es un poco menos exótica.

Un buen ejemplo de cómo abordar el problema o la percepción por diferentes medios es la plataforma de seguimiento de vehículos a x de Eye Net. Esta es una de esas tecnologías de las que se ha hablado en el contexto de 5G (es cierto que todavía es algo exótico), que a pesar de todo el bombo realmente permite aplicaciones de corta distancia y baja latencia que podrían salvar vidas.

Eye Net proporciona advertencias de colisión entre vehículos equipados con su tecnología, ya sea que tengan cámaras u otra tecnología de detección equipada o no. El ejemplo que brindan es un automóvil que atraviesa un estacionamiento, sin saber que una persona en uno de esos patinetes eléctricos horriblemente inseguros se está moviendo perpendicularmente hacia adelante, a punto de acercarse a su camino, pero totalmente oculto por autos estacionados. Los sensores de Eye Net detectan la posición de los dispositivos en ambos vehículos y envían advertencias a tiempo para que uno o ambos frenen.

Créditos de imagen: Red de ojos

No son los únicos que intentan algo como esto, pero esperan que al proporcionar una especie de solución de marca blanca, se pueda construir una red de buen tamaño con relativa facilidad, en lugar de no tener ninguna, y luego todos los VW equipados, y algo más. Ford y algunas bicicletas eléctricas, etc.

Pero la visión seguirá siendo una parte importante de cómo navegan los vehículos, y se están logrando avances en múltiples frentes.

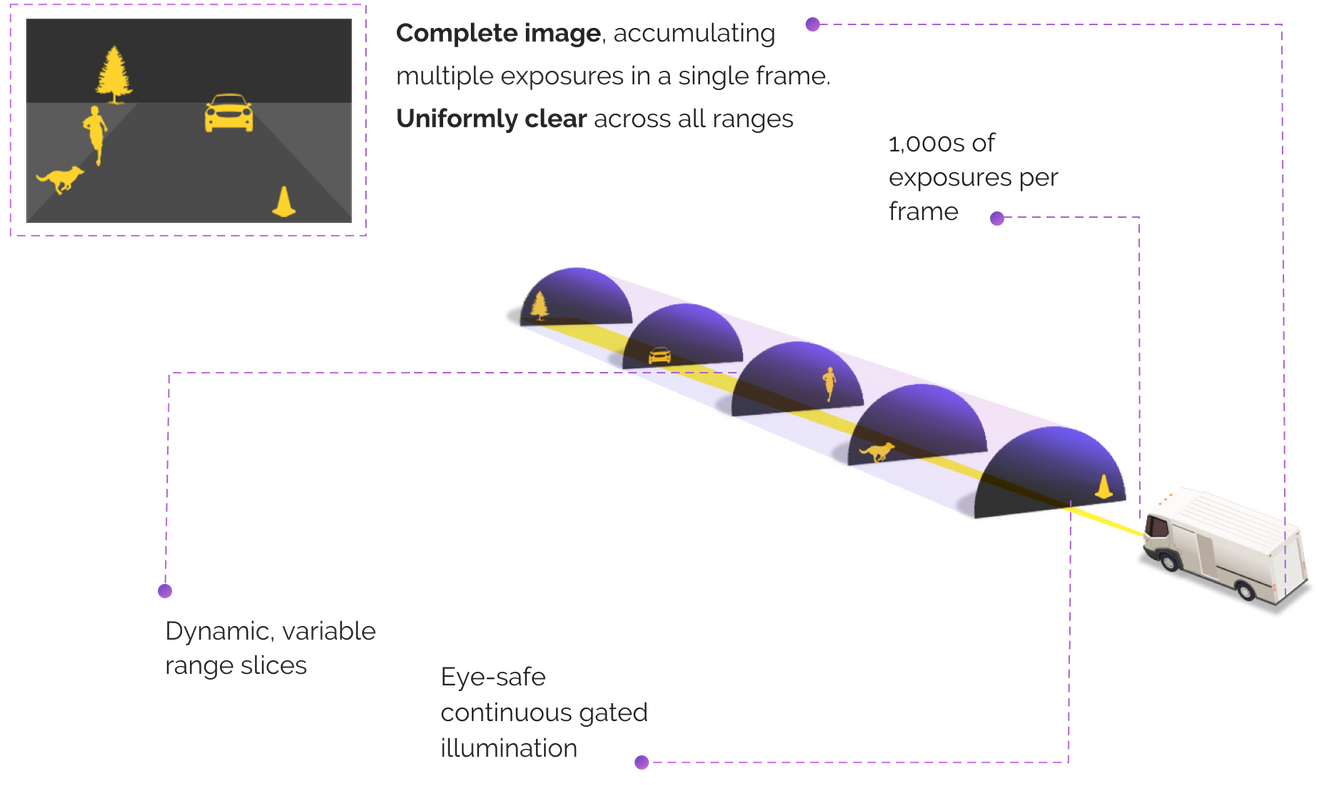

Brightway Vision, por ejemplo, aborda el problema de las cámaras RGB normales que tienen visibilidad limitada en muchas condiciones del mundo real al ser multiespectrales. Además de las imágenes de luz visible ordinarias, la cámara de la empresa está acoplada a un proyector de infrarrojo cercano que escanea la carretera a intervalos de distancia establecidos muchas veces por segundo.

Créditos de imagen: Visión Brightway

La idea es que si la cámara principal no puede ver 100 pies hacia afuera debido a la niebla, las imágenes NIR aún detectarán cualquier obstáculo o característica de la carretera cuando escanee ese “corte” en su barrido regular del área entrante. Combina las bondades de las cámaras tradicionales con las de las IR, pero consigue evitar las deficiencias de ambas. El argumento es que no hay razón para usar una cámara normal cuando puede usar una de estas, que hace el mismo trabajo mejor e incluso puede permitir que se corte otro sensor.

Foresight Automotive también usa imágenes multiespectrales en sus cámaras (es probable que ninguna cámara de vehículo se limite al espectro visible en unos pocos años), sumergiéndose en la térmica a través de una asociación con FLIR, pero lo que realmente está vendiendo es otra cosa.

Para proporcionar una cobertura de 360 grados (o cercana), generalmente se requieren varias cámaras. Pero el lugar donde van esas cámaras difiere en un sedán compacto frente a un SUV del mismo fabricante, y mucho menos en un vehículo de carga autónomo. Debido a que esas cámaras tienen que trabajar juntas, necesitan estar perfectamente calibradas, conscientes de la posición exacta de las demás, para que sepan, por ejemplo, que ambas están mirando al mismo árbol o ciclista y no a dos idénticos.

Créditos de imagen: Foresight Automotive

El avance de Foresight consiste en simplificar la etapa de calibración, por lo que un fabricante, diseñador o plataforma de prueba no necesita volver a probarse y certificarse laboriosamente cada vez que las cámaras deben moverse media pulgada en una dirección u otra. La demostración de Foresight los muestra colocando las cámaras en el techo del automóvil segundos antes de conducirlo.

Tiene similitudes con otra startup llamada Nodar que también se basa en cámaras estereoscópicas, pero adopta un enfoque diferente. La técnica de derivar la profundidad de la triangulación binocular, como señala la compañía, se remonta a décadas, o millones de años si contamos nuestro propio sistema de visión, que funciona de manera similar. La limitación que ha frenado este enfoque no es que las cámaras ópticas fundamentalmente no puedan proporcionar la información de profundidad que necesita un vehículo autónomo, sino que no se puede confiar en que permanezcan calibradas.

Nodar muestra que sus cámaras estéreo emparejadas ni siquiera necesitan montarse en la masa principal del automóvil, lo que reduciría la fluctuación y los desajustes fraccionales entre las vistas de las cámaras. Adjunto a los espejos retrovisores, su configuración de cámara “Hammerhead” tiene una postura amplia (como la del tiburón), que proporciona una precisión mejorada debido a la mayor disparidad entre las cámaras. Dado que la distancia está determinada por las diferencias entre las dos imágenes, no hay necesidad de reconocimiento de objetos o aprendizaje automático complejo para decir “esta es una forma, probablemente un automóvil, probablemente de este tamaño, lo que significa que probablemente esté tan lejos”. podría con una solución de cámara única.

Créditos de imagen: Nodar

“La industria ya ha demostrado que las matrices de cámaras funcionan bien en condiciones climáticas adversas, al igual que los ojos humanos ”, dijo el director de operaciones y cofundador de Nodar, Brad Rosen. “Por ejemplo, los ingenieros de Daimler han publicado resultados que muestran que los enfoques estereoscópicos actuales proporcionan estimaciones de profundidad significativamente más estables que los métodos monoculares y la terminación LiDAR en condiciones meteorológicas adversas. La belleza de nuestro enfoque es que el hardware que usamos está disponible hoy, en grado automotriz, y con muchas opciones para fabricantes y distribuidores “.

De hecho, un gran impacto contra el lidar ha sido el costo de la unidad; incluso las “económicas” tienden a ser órdenes de magnitud más caras que las cámaras normales, algo que se suma muy rápidamente. Pero el equipo lidar tampoco se ha quedado quieto.

Sense Photonics entró en escena con un nuevo enfoque que parecía combinar lo mejor de ambos mundos: un flash Lidar relativamente barato y simple (en lugar de girar o escanear, que tienden a agregar complejidad) acoplado a una cámara tradicional para que los dos ver versiones de la misma imagen, lo que les permite trabajar juntos para identificar objetos y establecer distancias.

Desde su debut en 2019, Sense ha perfeccionado su tecnología para la producción y más allá. El último avance es el hardware personalizado que le ha permitido obtener imágenes de objetos a una distancia de 200 metros, lo que generalmente se considera en el otro extremo tanto para cámaras lidar como tradicionales.

“En el pasado, obtuvimos un detector estándar para emparejarlo con nuestra fuente láser (Sense Illuminator). Sin embargo, nuestros 2 años de desarrollo de detectores internos se han completado y son un gran éxito, lo que nos permite construir productos automotrices de corto y largo alcance ”, dijo la directora ejecutiva Shauna McIntyre.

“Sense ha creado ‘bloques de construcción’ para un diseño LiDAR similar a una cámara que se puede combinar con diferentes conjuntos de ópticas para lograr diferentes FOV, rango, resolución, etc.”, continuó. “Y lo hemos hecho con un diseño muy simple que realmente se puede fabricar en grandes volúmenes. Puedes pensar en nuestra arquitectura como una cámara DSLR en la que tienes la ‘cámara base’ y puedes emparejarla con una lente macro, una lente de zoom, una lente de ojo de pez, etc. para lograr diferentes funciones “.

Una cosa en la que todas las empresas parecían estar de acuerdo es que ninguna modalidad de detección dominará la industria de arriba a abajo. Dejando de lado que las necesidades de un vehículo completamente autónomo (es decir, nivel 4-5) tienen necesidades muy diferentes a las de un sistema de asistencia al conductor, el campo se mueve demasiado rápido para que cualquier enfoque permanezca en la cima por mucho tiempo.

“Las empresas de AV no pueden tener éxito si el público no está convencido de que su plataforma es segura y los márgenes de seguridad solo aumentan con modalidades de sensores redundantes que operan en diferentes longitudes de onda”, dijo McIntyre.

Ya sea que eso signifique luz visible, infrarrojo cercano, imágenes térmicas, radar, lidar o, como hemos visto aquí, una combinación de dos o tres de estos, está claro que el mercado seguirá favoreciendo la diferenciación, aunque como con el auge. ciclo de colapso visto en la industria lidar hace unos años, también es una advertencia de que la consolidación no se quedará atrás.