La Comisión Europea estudia una prohibición temporal del uso de la tecnología de reconocimiento facial, según un borrador de propuesta para regular la inteligencia artificial obtenido por Euroactiv.

La creación de reglas para garantizar que la IA sea “confiable y humana” ha sido una de las primeras promesas políticas emblemáticas de la nueva Comisión, encabezada por la presidenta Ursula von der Leyen.

Pero la propuesta filtrada sugiere que el órgano ejecutivo de la UE, de hecho, se inclina hacia ajustes de las normas existentes y evaluaciones de riesgo y requisitos específicos del sector/aplicación, en lugar de algo tan firme como los requisitos o prohibiciones sectoriales generales.

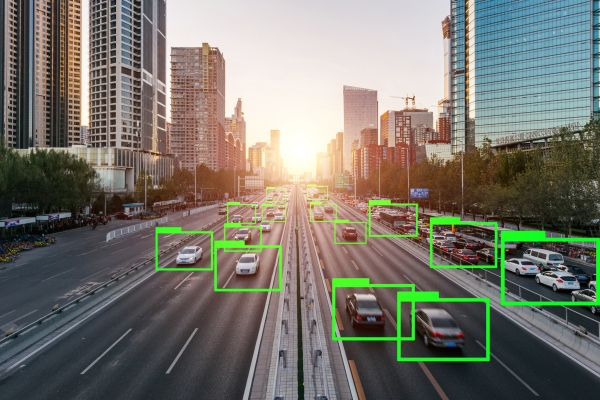

La Comisión filtrada papel blanco plantea la idea de un período de tres a cinco años en el que podría prohibirse el uso de la tecnología de reconocimiento facial en lugares públicos, para dar a los legisladores de la UE tiempo para idear formas de evaluar y gestionar los riesgos relacionados con el uso de la tecnología, como a los derechos de privacidad de las personas o el riesgo de impactos discriminatorios de algoritmos sesgados.

“Esto salvaguardaría los derechos de las personas, en particular contra cualquier posible abuso de la tecnología”, escribe la Comisión, y agrega que: “Sería necesario prever algunas excepciones, en particular para las actividades en el contexto de la investigación y el desarrollo y para la seguridad. propósitos.”

Sin embargo, el texto plantea preocupaciones inmediatas sobre la imposición incluso de una prohibición de tiempo limitado, que se describe como “una medida de gran alcance que podría obstaculizar el desarrollo y la adopción de esta tecnología”, y la Comisión continúa afirmando que su preferencia “en este momento etapa” es confiar en las normas de protección de datos de la UE existentes, también conocido como el Reglamento General de Protección de Datos (GDPR).

El libro blanco contiene una serie de opciones que la Comisión aún está considerando para regular el uso de la inteligencia artificial de manera más general.

Estos van desde el etiquetado voluntario; a la imposición de requisitos sectoriales para el sector público (incluido el uso de tecnología de reconocimiento facial); a los requisitos obligatorios basados en el riesgo para las aplicaciones de “alto riesgo” (como en sectores de riesgo como la atención médica, el transporte, la policía y el poder judicial, así como para las aplicaciones que pueden “producir efectos jurídicos para la persona física o jurídica o plantear un riesgo de lesiones, muerte o daños materiales importantes”); a modificaciones específicas de la legislación vigente en materia de seguridad y responsabilidad de los productos de la UE.

La propuesta también enfatiza la necesidad de un régimen de gobernanza de supervisión para garantizar que se sigan las reglas, aunque la Comisión sugiere dejar abierto a los Estados miembros la elección de confiar en los órganos de gobernanza existentes para esta tarea o crear otros nuevos dedicados a regular la IA.

Según el borrador del libro blanco, la Comisión dice que su preferencia por regular la IA son las opciones 3 combinadas con 4 y 5: también conocidos como requisitos obligatorios basados en el riesgo para los desarrolladores (de cualquier subconjunto de aplicaciones de IA que se consideren de “alto riesgo”) que podrían dar como resultado algunos “criterios obligatorios”, combinados con ajustes relevantes a la legislación existente sobre responsabilidad y seguridad de productos, y un marco de gobernanza general.

Por lo tanto, parece estar inclinándose hacia un enfoque relativamente ligero, centrado en “construir sobre la legislación existente de la UE” y crear reglas específicas de aplicaciones para un subconjunto de aplicaciones/usos de IA de “alto riesgo”, y que probablemente ganará. t se extiende incluso a una prohibición temporal de la tecnología de reconocimiento facial.

Gran parte del libro blanco también se ocupa de la discusión de estrategias sobre “apoyar el desarrollo y la adopción de la IA” y “facilitar el acceso a los datos”.

“Este enfoque basado en el riesgo se centraría en áreas en las que el público está en riesgo o en un interés legal importante”, escribe la Comisión. “Este enfoque estrictamente dirigido no agregaría ninguna nueva carga administrativa adicional a las solicitudes que se consideran de ‘bajo riesgo’”.

El comisionado de la UE, Thierry Breton, que supervisa la cartera del mercado interno, expresó su resistencia a crear reglas para la inteligencia artificial el año pasado y le dijo al parlamento de la UE que él “no será la voz de la regulación de la IA“.

Para las aplicaciones de IA de “bajo riesgo”, el libro blanco señala que se aplicarían las disposiciones del RGPD que otorgan a las personas el derecho a recibir información sobre el procesamiento y la elaboración de perfiles automatizados, y establecen el requisito de llevar a cabo una evaluación de impacto de la protección de datos.

Aunque la regulación solo define derechos y restricciones limitados sobre el procesamiento automatizado, en los casos en que existe un efecto legal o similarmente significativo en las personas involucradas. Por lo tanto, no está claro en qué medida se aplicaría de hecho a las aplicaciones de “bajo riesgo”.

Si la intención de la Comisión es confiar también en el RGPD para regular cosas de mayor riesgo, como, por ejemplo, el uso de tecnología de reconocimiento facial por parte de las fuerzas policiales, en lugar de crear un marco sectorial más explícito para restringir el uso de una IA altamente hostil a la privacidad. tecnologías: podría exacerbar una imagen legislativa ya confusa en lo que respecta a la aplicación de la ley, según el Dr. Michael Veale, profesor de derechos digitales y regulación en UCL.

“La situación es extremadamente confusa en el área de la aplicación de la ley y, en particular, el uso de asociaciones público-privadas en la aplicación de la ley. Yo diría que el RGPD en la práctica prohíbe el reconocimiento facial por parte de empresas privadas en un contexto de vigilancia sin que los estados miembros legislen activamente una exención en la ley usando sus poderes para derogar. Sin embargo, los mercaderes de la duda en las firmas de reconocimiento facial desean sembrar una gran incertidumbre en esa área de la ley para legitimar sus negocios”, dijo a TechCrunch.

“Como resultado, una mayor claridad sería muy bienvenida”, agregó Veale. “Sin embargo, el problema no se limita al reconocimiento facial: cualquier tipo de monitoreo biométrico, como el reconocimiento de voz o de la marcha, debería estar cubierto por cualquier prohibición, porque en la práctica tienen el mismo efecto en las personas”.

Un organismo asesor creado para asesorar a la Comisión sobre la política de IA estableció una serie de recomendaciones en un informe el año pasado, incluida la sugerencia de prohibir el uso de IA para la vigilancia masiva y los sistemas de puntuación de crédito social de los ciudadanos.

Pero sus recomendaciones fueron criticadas por expertos en privacidad y derechos por quedarse cortas al no comprender los desequilibrios de poder social más amplios y los problemas de desigualdad estructural que la IA corre el riesgo de exacerbar, incluso al sobrecargar los modelos comerciales existentes que erosionan los derechos.

en un papel el año pasado, Veale calificó el trabajo del organismo asesor como una “oportunidad perdida” y escribió que el grupo “ignora en gran medida la infraestructura y la energía, que deberían ser una de las preocupaciones centrales, si no la más importante, en torno a la regulación y el gobierno de los datos, la optimización y el ‘artificial’”. inteligencia’ en Europa de cara al futuro”.