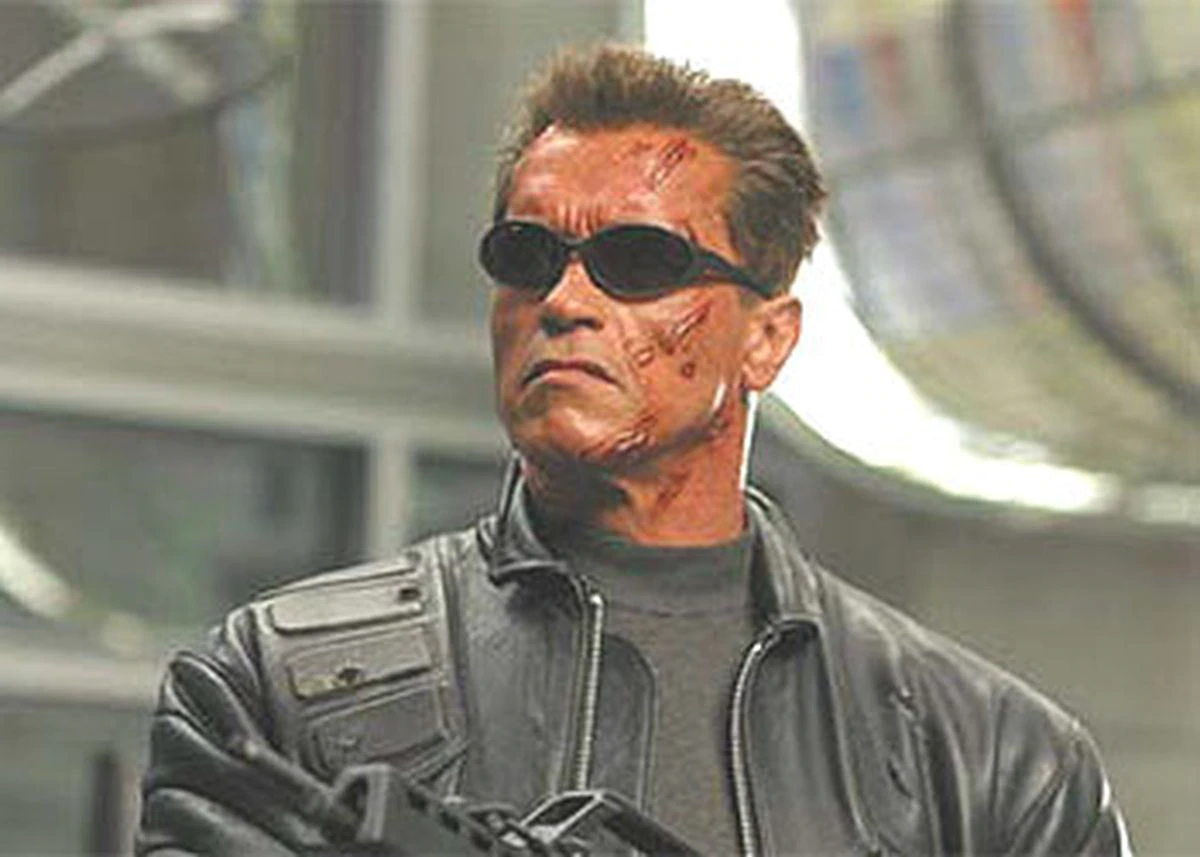

Terminator presumía de español en cada despedida. Con su icónico Hasta la vista, baby (traducido en España como Sayonara, baby) el androide más famoso del cine demostró que, aunque fuera angloparlante, tenía interés en otros idiomas. Es lo que está sucediendo, salvando las distancias y los viajes en el tiempo, con las tecnologías del lenguaje del mundo real. Internet habla inglés y por eso las inteligencias artificiales han aprendido antes el idioma de Shakespeare que cualquier otro. Pero la cosa está empezando a cambiar. Alexa se defiende en español, catalán, italiano, portugués, alemán, chino y japonés. Siri y Ok Google también son políglotas. Estos son los alumnos aventajados de la clase, los más inteligentes de entre todas las inteligencias artificiales. El resto de algoritmos van rezagados en el complicado camino al multilingüismo. Y eso tiene consecuencias.

La tecnología, en la actualidad, es eminentemente angloparlante, lo que amplifica la brecha del idioma de millones de personas. Hace, por ejemplo, que las campañas de desinformación sean más difíciles de detectar en español que en inglés. El grupo Ya Basta, Facebook, liderado por una asociación de juristas y activistas estadounidenses, denunciaba a principios de año como la red social se ha mostrado menos efectiva a la hora de combatir la desinformación sobre la campaña electoral de EE UU en español que en inglés. Cinco de cada 10 publicaciones falsas en inglés son rápidamente etiquetadas por Facebook. Solo una de cada 10 publicaciones falsas en español corren la misma suerte, según un análisis de Avaaz.

Una traducción de páginas webs garantiza (o dificulta) el acceso a servicios básicos. Esto es especialmente relevante en un entorno en el que las gestiones más ordinarias, desde la cita médica hasta la declaración de la renta, se realizan por ordenador. Un estudio del Hospital Brigham and Women’s de Boston (EE. UU.) descubrió que los pacientes que no hablaban inglés tenían un 35 % más probabilidades de morir de COVID-19 que aquellos que sí lo hablaban. Por eso es importante que cada idioma hablado en el mundo offline tenga su representación en el online. Y esto solo se puede conseguir alimentando con palabras a las voraces inteligencias artificiales.

Más información

“Ya que estamos hablando de lenguaje, es importante llamar a las cosas por su nombre”, señala en conversación telefónica Nuria Bel, catedrática de Tecnologías del Lenguaje de la Universidad Pompeu Fabra. “La inteligencia artificial no es un resultado, es un método. Uno por el cual se entrena a los algoritmos con una gran cantidad de datos”. Esto se aplica a tres grandes campos. A la robótica, con resultados que van desde las aspiradoras inteligentes hasta el coche autónomo; a lo visual, detectando y clasificando imágenes; y, por último, a las tecnologías del lenguaje. Bel cree que en los últimos años hemos optado por hablar, en general, de inteligencia artificial “porque suena menos prosaico” que tecnologías del lenguaje. Más épico. Pero no hay que olvidar que estas tienen una problemática propia. La más evidente es la atomización de sus resultados.

La robótica y la imagen se pueden entrenar de forma internacional sin grandes problemas. Los avances que hagan las empresas estadounidenses pueden beneficiar al resto del mundo por igual. Pero en las tecnologías del lenguaje no. Aquí se necesita una apuesta de cada país para potenciar sus propias lenguas. Es lo que está empezando a suceder. “Estamos en un momento similar al que se dio en el siglo XIX con la cartografía”, explica la experta. “En los siglos anteriores los mapas reflejaban muy bien el Mediterráneo y muy mal el resto del mundo. Pero en el XIX los países se vieron en la necesidad de cartografiar en detalle su territorio. Esto es lo mismo pero con lenguas”.

Nuria Bel capitaneó en 2015 (junto a su compañero Germán Rigau) la iniciativa española para cartografiar su territorio lingüístico. El Plan de Impulso de las Tecnologías del Lenguaje se inició con un informe en el que señalaba el problema del uso de la inteligencia artificial en este campo. “Para garantizar la disponibilidad de aplicaciones en español y lenguas cooficiales en España hay que aumentar el número, la calidad y la disponibilidad de los recursos que les dan soporte”, se señalaba entonces. Hay que alimentar a los algoritmos con más palabras.

Wikipedia, la única escuela pública de idiomas para algoritmos

La inteligencia artificial no convierte a un algoritmo en inteligente. Para que eso ocurra, pasa con los algoritmos como con las personas, este tiene que haber leído mucho. “Las redes neuronales van fatal hasta que no consiguen analizar una masa crítica importante de texto”, confirma Bel. Para que un generador de textos funcione, por ejemplo, hacen falta 3.000 millones de palabras. “Eso es toda la Wikipedia, todo Google Books y algún que otro corpus más”, asegura. Esto supone varios problemas. El primero es que no todas las lenguas tienen esa cantidad de palabras digitalizadas. Si quieres saber qué tal funciona una tecnología del lenguaje en un idioma en concreto, lo mejor es que eches un vistazo a cómo está representado ese idioma en internet.

La realidad lingüística en el mundo online no siempre es igual que en el offline. En Wikipedia hay 53 millones de páginas en inglés, frente a los siete millones de páginas en castellano. El mismo número de entradas tiene la enciclopedia online en italiano, un idioma mucho menos hablado. Esto desdibuja la importancia del castellano en el entorno online.

Hay casos más extremos. Solo hay 52.000 artículos en la Wikipedia bengalí, un idioma hablado por 237 millones de personas. La versión sueca tiene cerca de cuatro millones de entradas para una lengua que apenas hablan 10 millones de personas. En el mapa mundi de las lenguas digitales aún hay zonas ignotas, mientras que otras están representadas con fidelidad.

La enciclopedia online es una de las mejores bases de datos para entrenar a las tecnologías del lenguaje.”Wikipedia es muy usada en este entorno porque es abierta y pública”, señala German Rigau, director adjunto del Basque Research Center for Language Technologies. Pero es una excepción. La mayoría de grandes bases de datos están en manos de empresas privadas estadounidenses. Google, Facebook, Amazon, Microsoft… Son las que están ganando esta carrera. En este sentido, Europa se encuentra en clara desventaja frente a EE UU: sus empresas son más pequeñas y su población habla decenas de idiomas que parten de posiciones bien distintas. Pero algunas iniciativas, públicas y privadas, están luchando por cambiar esta situación.

Rigau forma parte de una de ellas, el programa European Language Equality. “Estamos diseñando una agenda y una hoja de ruta, cumpliendo un mandato del Parlamento Europeo, para llegar a la igualdad de las lenguas en Europa en el entorno online, para 2030”, señala el experto. Más de 21 idiomas europeos están en peligro de extinción digital según explica esta iniciativa en su web. Rigau denuncia cómo lenguas no oficiales, con implementación en lo oral, pero poco uso en lo online, se ven abocadas a este final. “El aragonés se va a perder, el asturiano se va a perder. Apenas hay textos digitales escritos con estas lenguas”, lamenta. Para evitarlo, lo primero que se necesita son “herramientas muy básicas para crear plantillas de esos idiomas en Wikipedia. De esa forma ya se puede empezar a construir una base de datos”.

Wikipedia es el único campo de entrenamiento de muchos algoritmos, pues sus datos son públicos en un entorno, el online, dominado por grandes empresas privadas. Es, para entendernos, la única gran escuela pública de idiomas para algoritmos. Y este es el segundo gran problema. “Las tecnologías del lenguaje están en manos de quien tiene los datos y estas son las grandes empresas privadas”, denuncia Rigau.

Bel se muestra de acuerdo en este análisis y explica su preocupación al respecto. “Es un poco como con la banca, que nos decían que se autorregulaba. Aquí pasa lo mismo, unas pocas empresas tienen todos los datos, y nos dicen que hay que hablar de inteligencia artificial ética, que hay que confiar en que hagan las cosas bien”. Por eso Bel anima a que no se abandonen otras líneas de investigación en las tecnologías del lenguaje. La inteligencia artificial da buenos resultados, pero los procesos para llegar hasta ellos son complicados y opacos, señala.

Estos resultados son cada vez más evidentes. Los algoritmos hablan inglés, pero están aprendiendo otros idiomas, adentrándose en nuevos territorios. Para que el viaje sea fructífero tienen que consultar un mapa preciso, hay que cartografiar las realidades lingüísticas de todos los rincones del planeta. En este contexto el castellano, segunda lengua materna del mundo por número de hablantes, parte de una situación de ventaja. Aprovecharlo, coinciden los expertos, no solo es una cuestión de impulso económico y estrategia sociopolítica. Es un aspecto clave para que los hispanohablantes se encuentren igual de protegidos y beneficiados que quienes hablan inglés. El idioma que hablen y entiendan las máquinas incidirá, de manera directa, en los derechos de los humanos que lo hablen.

Puedes seguir a EL PAÍS TECNOLOGÍA en Facebook y Twitter o apuntarte aquí para recibir nuestra newsletter semanal.