La investigación en el campo del aprendizaje automático y la IA, ahora una tecnología clave en prácticamente todas las industrias y empresas, es demasiado voluminosa para que alguien la lea en su totalidad. Esta columna, Perceptron (anteriormente Deep Science), tiene como objetivo recopilar algunos de los descubrimientos y artículos recientes más relevantes, particularmente en inteligencia artificial, entre otros, y explicar por qué son importantes.

Esta semana en AI, ingenieros en Penn State Anunciado que han creado un chip que puede procesar y clasificar casi dos mil millones de imágenes por segundo. Mientras tanto, Carnegie Mellon ha firmado un contrato del Ejército de los EE. UU. por valor de 10,5 millones de dólares para ampliar el uso de la IA en el mantenimiento predictivo. Y en UC Berkeley, un equipo de científicos está aplicando la investigación de IA para resolver problemas climáticos, como comprensión La nieve como recurso hídrico.

El trabajo de Penn State tuvo como objetivo superar las limitaciones de los procesadores tradicionales cuando se aplican a cargas de trabajo de IA, específicamente reconociendo y clasificando imágenes o los objetos en ellas. Antes de que un sistema de aprendizaje automático pueda procesar una imagen, debe ser capturada por el sensor de imagen de una cámara (asumiendo que es una imagen del mundo real), convertida por el sensor de luz a señales eléctricas y luego convertida nuevamente en datos binarios. Solo entonces el sistema puede “comprender” suficientemente la imagen para procesarla, analizarla y clasificarla.

Los ingenieros de Penn State, incluido el becario postdoctoral Farshid Ashtiani, el estudiante de posgrado Alexander J. Geers y el profesor asociado de ingeniería eléctrica y de sistemas Firooz Aflatouni, diseñaron una solución alternativa que, según afirman, elimina los aspectos que consumen más tiempo del procesamiento tradicional de imágenes de IA basado en chips. Su procesador personalizado de 9,3 milímetros cuadrados procesa directamente la luz recibida de un “objeto de interés” utilizando lo que ellos llaman una “red neuronal profunda óptica”.

Representación 3D, placa de computadora con circuitos y chip

Básicamente, el procesador de los investigadores utiliza “neuronas ópticas” interconectadas mediante cables ópticos, conocidos como guías de ondas, para formar una red profunda de muchas capas. La información pasa a través de las capas, y cada paso ayuda a clasificar la imagen de entrada en una de sus categorías aprendidas. Gracias a la capacidad del chip para calcular a medida que la luz se propaga a través de él y leer y procesar señales ópticas directamente, los investigadores afirman que el chip no necesita almacenar información y puede realizar una clasificación de imagen completa en aproximadamente medio nanosegundo.

“No somos los primeros en idear tecnología que lee señales ópticas directamente”, dijo Geers en un comunicado, “pero somos los primeros en crear el sistema completo dentro de un chip que es compatible con la tecnología existente y escalable para funcionar. con datos más complejos”. Él espera que el trabajo tenga aplicaciones para detectar automáticamente texto en fotos, ayudar a los autos autónomos a reconocer obstáculos y otras tareas relacionadas con la visión por computadora.

En Carnegie Mellon, el Auton Lab de la universidad se centra en un conjunto diferente de casos de uso: aplicar técnicas de mantenimiento predictivo a todo, desde vehículos terrestres hasta generadores de energía. Con el apoyo del contrato antes mencionado, el director de Auton Lab, Artur Dubrawski, liderará un esfuerzo para realizar una investigación fundamental para ampliar la aplicabilidad de los modelos informáticos de sistemas físicos complejos, conocidos como gemelos digitales, a muchos dominios.

Las tecnologías de gemelos digitales no son nuevas. GEAWS y otras empresas ofrecen productos que permiten a los clientes modelar gemelos digitales de maquinas con sede en Londres SenSat crea modelos gemelos digitales de ubicaciones para proyectos de construcción, minería y energía. Mientras tanto, nuevas empresas como Lacuna y Nexar están construyendo gemelos digitales de ciudades enteras.

Pero las tecnologías de gemelos digitales comparten las mismas limitaciones, entre las que destaca el modelado inexacto procedente de datos inexactos. Como en otros lugares, es basura que entra, basura que sale.

Para abordar este y otros obstáculos para lograr un uso más amplio de los gemelos digitales, el equipo de Dubrawski está colaborando con una variedad de partes interesadas, como médicos en cuidados intensivos, para explorar escenarios que incluyen la atención médica. Auton Lab tiene como objetivo desarrollar métodos nuevos y más eficientes para “capturar la experiencia humana” para que los sistemas de IA puedan comprender contextos que no están bien representados en los datos, así como métodos para compartir esa experiencia con los usuarios.

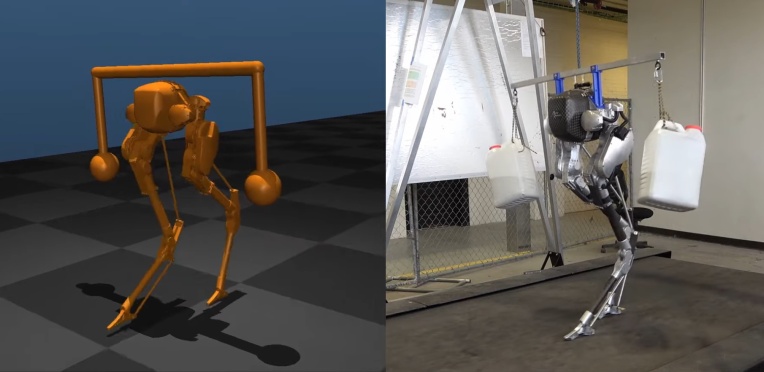

Una cosa que la IA puede tener pronto y que algunas personas parecen carecer es sentido común. DARPA ha estado financiando una serie de iniciativas en diferentes laboratorios que tienen como objetivo imbuir a los robots con un sentido general de qué hacer si las cosas no están del todo bien cuando están caminando, cargando algo o agarrando un objeto.

Por lo general, estos modelos son bastante frágiles y fallan miserablemente tan pronto como se exceden ciertos parámetros o ocurren eventos inesperados. Entrenarles el “sentido común” significa que serán más flexibles, con un sentido general de cómo salvar una situación. Estos no son conceptos particularmente de alto nivel, sino formas más inteligentes de manejarlos. Por ejemplo, si algo se sale de los parámetros esperados, puede ajustar otros parámetros para contrarrestarlo, incluso si no están diseñados específicamente para hacerlo.

Esto no significa que los robots vayan a improvisar todo, simplemente no fallarán tan fácilmente o tan fuerte como lo hacen actualmente. La investigación actual muestra que la locomoción en terreno accidentado es mejor, las cargas móviles se transportan mejor y los objetos desconocidos se sujetan mejor cuando se incluye entrenamiento de “sentido común”.

El equipo de investigación de UC Berkeley, por el contrario, se está concentrando en un dominio en particular: el cambio climático. La Iniciativa Climática de Investigación de IA de Berkeley (BAIR), que se lanzó recientemente, organizada por los candidatos a doctorado en ciencias de la computación Colorado Reed y Medhini Narasimhan y el estudiante de doctorado en ciencias de la computación Ritwik Gupta, busca socios entre expertos en clima, agencias gubernamentales y la industria para lograr objetivos significativos para ambos. clima e IA.

Uno de los primeros proyectos que la iniciativa planea abordar utilizará una técnica de IA para combinar mediciones de observaciones de nieve desde aeronaves y fuentes de datos satelitales y meteorológicos disponibles abiertamente. AI ayudará a rastrear el ciclo de vida de la nieve, lo que actualmente no es posible sin un gran esfuerzo, lo que permitirá a los investigadores estimar y predecir cuánta agua hay en la nieve en las montañas de Sierra Nevada, y pronosticar el impacto en el caudal de la región.

Un comunicado de prensa que detalla los esfuerzos de BAIR señala que el estado de la nieve afecta la salud pública y la economía. Aproximadamente 1200 millones de personas dependen del derretimiento de la nieve en todo el mundo para el consumo de agua u otros fines, y las montañas de la Sierra por sí solas proporcionan agua a más de la mitad de la población de California.

Cualquier tecnología o investigación realizada por la iniciativa climática se publicará abiertamente y no tendrá licencia exclusiva, dijo Trevor Darrel, cofundador de BAIR y profesor de informática de Berkeley.

Un gráfico que muestra la producción de CO2 de diferentes procesos de entrenamiento del modelo de IA.

Sin embargo, la propia IA también contribuye al cambio climático, ya que se necesitan enormes recursos informáticos para entrenar modelos como GPT-3 y DALL-E. El Instituto Allen para la IA (AI2) hizo un estudio sobre cómo estos periodos de formación podrían realizarse de forma inteligente para reducir su impacto en el clima. No es un cálculo trivial: el lugar de donde proviene la electricidad está en constante cambio y el uso máximo, como una ejecución de supercomputación de un día, no se puede dividir para funcionar la próxima semana cuando sale el sol y la energía solar es abundante.

El trabajo de AI2 analiza la intensidad de carbono del entrenamiento de varios modelos en varios lugares y momentos, como parte de un proyecto más grande en Green Software Foundation para reducir la huella de estos procesos importantes pero que consumen mucha energía.

Por último, pero no menos importante, OpenAI reveló esta semana Video de preentrenamiento (VPT), una técnica de entrenamiento que utiliza una pequeña cantidad de datos etiquetados para enseñar a un sistema de IA a completar tareas como la elaboración de herramientas de diamante en Minecraft. VPT implica buscar videos en la web y hacer que los contratistas produzcan datos (por ejemplo, 2000 horas de videos etiquetados con acciones del mouse y el teclado), y luego entrenar un modelo para predecir acciones dados fotogramas de video pasados y futuros. En el último paso, los videos originales de la web se etiquetan con los datos del contratista para entrenar un sistema que prediga acciones solo con fotogramas pasados.

OpenAI usó Minecraft como un caso de prueba para VPT, pero la firma afirma que el enfoque es bastante general, lo que representa un paso hacia “agentes generales que usan computadoras”. En cualquier caso, el modelo está disponible en código abierto, así como los datos del contratista que OpenAI obtuvo para sus experimentos.