El CEO de Tesla, Elon Musk, ha estado probando una computadora de entrenamiento de redes neuronales llamada “Dojo” desde al menos 2019. Musk dice que Dojo podrá procesar grandes cantidades de datos de video para lograr una conducción autónoma solo con visión. Si bien Dojo todavía está en desarrollo, Tesla reveló hoy una nueva supercomputadora que servirá como una versión prototipo de desarrollo de lo que Dojo finalmente ofrecerá.

En la Conferencia de 2021 sobre Visión por Computadora y Reconocimiento de Patrones el lunes, el jefe de inteligencia artificial de Tesla, Andrej Karpathy, reveló la nueva supercomputadora de la compañía que permite al fabricante de automóviles deshacerse de los sensores de radar y lidar en automóviles autónomos en favor de cámaras ópticas de alta calidad. Durante su taller sobre conducción autónoma, Karpathy explicó que para que una computadora responda a un nuevo entorno de una manera que un ser humano puede, requiere un inmenso conjunto de datos y una supercomputadora enormemente poderosa para entrenar la tecnología de conducción autónoma basada en la red neuronal de la compañía utilizando ese conjunto de datos. De ahí el desarrollo de estos predecesores de Dojo.

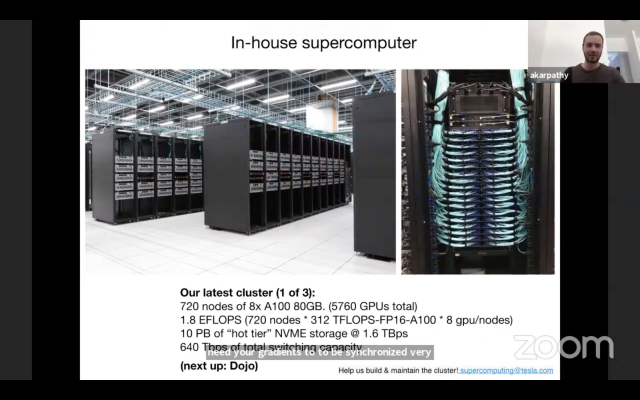

La supercomputadora de última generación de Tesla tiene 10 petabytes de almacenamiento NVME de “nivel caliente” y funciona a 1,6 terbytes por segundo, según Karpathy. Con 1.8 EFLOPS, dijo que podría ser la quinta supercomputadora más poderosa del mundo, pero admitió más tarde que su equipo aún no ha ejecutado el punto de referencia específico necesario para ingresar al ranking TOP500 de supercomputación.

“Dicho esto, si tomas el número total de FLOPS, de hecho se ubicaría en algún lugar alrededor del quinto lugar”, dijo Karpathy a TechCrunch. “El quinto lugar lo ocupa actualmente Nvidia con su clúster Selene, que tiene una arquitectura muy comparable y un número similar de GPU (4480 frente a nuestro 5760, un poco menos)”.

Musk ha estado abogando por un enfoque de la autonomía basado únicamente en la visión durante algún tiempo, en gran parte porque las cámaras son más rápidas que el radar o lidar. A partir de mayo, los vehículos Tesla Model Y y Model 3 en América del Norte se están construyendo sin radar, confiando en cámaras y aprendizaje automático para respaldar su avanzado sistema de asistencia al conductor y piloto automático.

Cuando el radar y la visión no concuerdan, ¿en cuál crees? La visión tiene mucha más precisión, por lo que es mejor duplicar la visión que la fusión de sensores.

– Elon Musk (@elonmusk) 10 de abril de 2021

Muchas empresas de conducción autónoma utilizan LIDAR y mapas de alta definición, lo que significa que requieren mapas increíblemente detallados de los lugares donde operan, incluidos todos los carriles de la carretera y cómo se conectan, semáforos y más.

“El enfoque que adoptamos se basa en la visión, utilizando principalmente redes neuronales que, en principio, pueden funcionar en cualquier lugar de la tierra”, dijo Karpathy en su taller.

Reemplazar una “computadora de carne”, o más bien, un humano, con una computadora de silicio da como resultado latencias más bajas (mejor tiempo de reacción), conciencia de la situación de 360 grados y un conductor completamente atento que nunca revisa su Instagram, dijo Karpathy.

Karpathy compartió algunos escenarios de cómo la supercomputadora de Tesla emplea la visión por computadora para corregir el mal comportamiento del conductor, incluido un escenario de frenado de emergencia en el que la detección de objetos de la computadora se activa para evitar que un peatón sea golpeado, y una advertencia de control de tráfico que puede identificar una luz amarilla en el distancia y envíe una alerta a un conductor que aún no ha comenzado a reducir la velocidad.

Los vehículos Tesla también han probado una función llamada mitigación de la aplicación incorrecta del pedal, en la que el automóvil identifica a los peatones en su camino, o incluso la falta de un camino de conducción, y responde cuando el conductor pisa el acelerador accidentalmente en lugar de frenar, lo que potencialmente salva a los peatones en su camino. delante del vehículo o evitar que el conductor acelere hacia un río.

La supercomputadora de Tesla recopila video de ocho cámaras que rodean el vehículo a 36 cuadros por segundo, lo que proporciona cantidades increíbles de información sobre el entorno que rodea al automóvil, explicó Karpathy.

Si bien el enfoque de solo visión es más escalable que recopilar, construir y mantener mapas de alta definición en todo el mundo, también es un desafío mucho mayor, porque las redes neuronales que detectan objetos y manejan la conducción tienen que ser capaces de recopilar y procesar grandes cantidades de datos a velocidades que coinciden con las capacidades de reconocimiento de profundidad y velocidad de un ser humano.

Karpathy dice que después de años de investigación, cree que se puede lograr si se trata el desafío como un problema de aprendizaje supervisado. Los ingenieros que probaron la tecnología descubrieron que podían conducir por áreas escasamente pobladas sin intervenciones, dijo Karpathy, pero “definitivamente luchan mucho más en entornos muy adversarios como San Francisco”. Para que el sistema funcione realmente bien y mitigue la necesidad de cosas como mapas de alta definición y sensores adicionales, tendrá que mejorar mucho en el manejo de áreas densamente pobladas.

Uno de los elementos que cambiaron el juego del equipo Tesla AI ha sido el etiquetado automático, a través del cual puede etiquetar automáticamente cosas como peligros en las carreteras y otros objetos de millones de videos capturados por vehículos en una cámara Tesla. Los grandes conjuntos de datos de IA a menudo han requerido mucho etiquetado manual, lo que lleva mucho tiempo, especialmente cuando se intenta llegar al tipo de conjunto de datos claramente etiquetado necesario para que un sistema de aprendizaje supervisado en una red neuronal funcione bien.

Con esta última supercomputadora, Tesla ha acumulado 1 millón de videos de alrededor de 10 segundos cada uno y etiquetado 6 mil millones de objetos con profundidad, velocidad y aceleración. Todo esto ocupa la friolera de 1,5 petabytes de almacenamiento. Eso parece una cantidad enorme, pero tomará mucho más antes de que la empresa pueda lograr el tipo de confiabilidad que requiere de un sistema de conducción automatizado que se basa solo en sistemas de visión, de ahí la necesidad de continuar desarrollando supercomputadoras cada vez más poderosas en La búsqueda de Tesla de una IA más avanzada.