A medida que el futuro de la propiedad de TikTok de ByteDance continúa dividiéndose entre leviatanes de tecnología y minoristas, inversionistas y funcionarios gubernamentales, la aplicación de video publicó hoy su último informe de transparencia. En total, se eliminaron más de 104,5 millones de videos; tenía cerca de 1.800 solicitudes legales; y recibió 10,600 avisos de eliminación por derechos de autor durante la primera mitad de este año.

Además de eso, y posiblemente para compensar la gran cantidad de videos ilícitos y también para coincidir con una aparición hoy frente a un comité parlamentario en el Reino Unido sobre contenido dañino, TikTok también anunció una nueva iniciativa, potencialmente en asociación con otras aplicaciones sociales, contra contenido nocivo.

Las cifras del informe de transparencia subrayan un aspecto importante en torno al impacto de la popular aplicación. Es posible que el gobierno quiera cerrar TikTok por preocupaciones de seguridad nacional (a menos que ByteDance encuentre una nueva estructura de control no china que satisfaga a los legisladores).

Pero en realidad, al igual que otras aplicaciones de redes sociales, TikTok tiene otro fuego no insignificante que combatir: está lidiando con una gran cantidad de contenido ilegal y dañino publicado y compartido en su plataforma, y a medida que continúa creciendo en popularidad (ahora tiene más de 700 millones de usuarios en todo el mundo), ese problema también seguirá creciendo.

Ese será un problema continuo para la empresa, independientemente de cómo se desarrolle su propiedad fuera de China. Si bien uno de los grandes problemas en torno al futuro de TikTok ha estado relacionado con sus algoritmos y si estos pueden o serán parte de algún acuerdo, la compañía ha intentado hacer otros esfuerzos para parecer más abierta con respecto a cómo funciona. A principios de este año, abrió un centro de transparencia en los EE. UU. Que, según dijo, ayudaría a los expertos a observar y examinar cómo modera el contenido.

TikTok dijo que el total de 104,543,719 videos que TikTok eliminó a nivel mundial por violar las pautas de la comunidad o sus términos de servicio compuesto menos del 1% de todos los videos subidos en TikTok, lo que le da una idea de la magnitud del servicio.

El volumen de videos que se están eliminando se ha más que duplicado en los últimos seis meses, un reflejo de cómo el volumen total de videos también se ha duplicado.

En el segundo semestre de 2019, la empresa retiró más de 49 millones de videos, según el último informe de transparencia publicado por la empresa (no sé exactamente por qué, pero tardó mucho más en publicar ese informe de transparencia anterior, que salió en julio de 2020.) La proporción del total de videos eliminados fue aproximadamente la misma que en los seis meses anteriores (“menos del 1%”).

Tik Tok dijo que el 96,4% del número total se eliminó antes de que se informara, y el 90,3% se eliminó antes de recibir cualquier visualización. No especifica si estos se encontraron a través de sistemas automatizados o por moderadores humanos, o una combinación de ambos, pero parece que hizo un cambio a la moderación basada en algoritmos al menos en algunos mercados:

“Como resultado de la pandemia de coronavirus, confiamos más en la tecnología para detectar y eliminar automáticamente el contenido infractor en mercados como India, Brasil y Pakistán”, señaló.

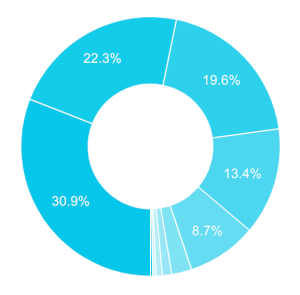

La compañía señala que la categoría más grande de videos eliminados fue la desnudez de adultos y las actividades sexuales, en un 30,9%, con seguridad menor en un 22,3% y actividades ilegales en un 19,6%. Otras categorías incluyeron suicidio y autolesión, contenido violento, discurso de odio e individuos peligrosos. (Y los videos podrían contar en más de una categoría, señaló).

El mercado de origen más grande de videos eliminados es aquel en el que TikTok ha sido prohibido (quizás como era de esperar): India se llevó la mayor parte de los videos con 37,682,924. Estados Unidos, por otro lado, representó 9,822,996 (9.4%) de videos eliminados, lo que lo convierte en el segundo mercado más grande.

Actualmente, parece que la información errónea y la desinformación no son las principales formas en que se abusa de TikTok, pero siguen siendo números significativos: unos 41,820 videos (menos del 0.5% de los eliminados en los EE. UU.) Violaron las políticas de desinformación y desinformación de TikTok, la compañía dijo.

Unos 321,786 videos (alrededor del 3.3% de las eliminaciones de contenido de EE. UU.) Violaron sus políticas de incitación al odio.

Las solicitudes legales, dijo, están en aumento, con 1.768 solicitudes de información de usuarios de 42 países / mercados en los primeros seis meses del año, con 290 (16.4%) provenientes de agencias de aplicación de la ley de EE. UU., Incluidas 126 citaciones, 90 búsquedas. órdenes judiciales y 6 órdenes judiciales. En total, recibió 135 solicitudes de agencias gubernamentales para restringir o eliminar contenido de 15 países / mercados.

Propuesta de coalición de redes sociales

Junto con el informe de transparencia, el anuncio de la coalición de contenido dañino se produce el mismo día en que TikTok compareció ante un comité del Departamento de Cultura, Medios y Deporte, un grupo parlamentario del Reino Unido.

En la práctica, ese interrogatorio, que contó con el director de políticas públicas de la compañía en EMEA, Theo Bertram, no tiene mucha fuerza, pero habla de que el gobierno está ganando una mayor conciencia de la aplicación y su impacto en los consumidores en el Reino Unido.

TikTok dijo que la coalición de contenido dañino se basa en una propuesta que Vanessa Pappas, directora interina de TikTok en Estados Unidos, envió a nueve ejecutivos de otras plataformas de redes sociales. No especifica qué empresas ni cuál fue la respuesta. Estamos preguntando y actualizaremos a medida que sepamos más.

Mientras tanto, la carta, publicada en su totalidad por TikTok y reimpresa a continuación, subraya una respuesta al pensamiento actual sobre cuán proactivas y exitosas han sido las plataformas de redes sociales para tratar de reducir parte del abuso de sus plataformas. No es el primer esfuerzo de este tipo; ha habido varios otros intentos como este en los que varias empresas, que antes eran competidores por la participación del consumidor, se unen en un frente unido para abordar cuestiones como la desinformación.

Este, específicamente, identifica contenido no político y propone un “enfoque colaborativo para la identificación y notificación tempranas entre los participantes de la industria de contenido gráfico extremadamente violento, incluido el suicidio”. El memorando de entendimiento propuesto por Pappas sugirió que las plataformas de redes sociales se comuniquen para mantenerse informados entre sí sobre el contenido, un movimiento inteligente, considerando cuánto se comparte en múltiples plataformas, desde otras plataformas.

Los esfuerzos de la compañía en la coalición de contenido dañino es un ejemplo más de cómo las empresas de redes sociales están tratando de tomar su propia iniciativa y demostrar que están tratando de ser responsables, una forma clave de presionar a los gobiernos para que no los regulen. Con Facebook, Twitter, YouTube y otros continúan en problemas por el contenido que se comparte en sus plataformas, a pesar de sus intentos de frenar el abuso y la manipulación, es poco probable que esta sea la última palabra en todo esto.

Nota completa a continuación:

Recientemente, las plataformas sociales y de contenido han vuelto a ser desafiadas por la publicación y publicación cruzada de contenido suicida explícito que nos ha afectado a todos, así como a nuestros equipos, usuarios y comunidades en general.

Como cada uno de ustedes, trabajamos diligentemente para mitigar su proliferación eliminando el contenido original y sus muchas variantes, y evitando que otros lo vean o compartan. Sin embargo, creemos que cada uno de nuestros esfuerzos individuales para proteger a nuestros propios usuarios y a la comunidad colectiva se vería impulsado de manera significativa a través de un enfoque formal y colaborativo para la identificación y notificación tempranas entre los participantes de la industria de contenido gráfico extremadamente violento, incluido el suicidio.

Con este fin, nos gustaría proponer el desarrollo cooperativo de un Memorando de Entendimiento (MOU) que nos permitirá notificarnos rápidamente unos a otros de dicho contenido.

Por separado, estamos llevando a cabo un análisis exhaustivo de los eventos en relación con el intercambio reciente de contenido suicida, pero está claro que la identificación temprana permite que las plataformas respondan más rápidamente para suprimir material violento altamente objetable.

Somos conscientes de la necesidad de que cualquier acuerdo negociado de este tipo esté claramente definido con respecto a los tipos de contenido que podría capturar, y lo suficientemente ágil como para permitir que cada uno de nosotros se mueva rápidamente para notificarnos unos a otros de lo que sería capturado por el MOU. También apreciamos que puede haber restricciones regulatorias en las regiones que ameriten un mayor compromiso y consideración.

Con este fin, nos gustaría convocar una reunión de nuestros respectivos equipos de Confianza y Seguridad para discutir más a fondo dicho mecanismo, que creemos que nos ayudará a todos a mejorar la seguridad de nuestros usuarios.

Esperamos su respuesta positiva y trabajar juntos para ayudar a proteger a nuestros usuarios y a la comunidad en general.

Sinceramente,

Vanessa Pappas

Jefe de TikTok

Más por venir.

Source link