WhatsApp grupos de chat se están utilizando para difundir pornografía infantil ilegal, encubierta por el cifrado de extremo a extremo de la aplicación. Sin el número necesario de moderadores humanos, el contenido perturbador se está deslizando por los sistemas automatizados de WhatsApp. Un informe de dos ONG israelíes revisado por TechCrunch detalla cómo las aplicaciones de terceros para descubrir los grupos de WhatsApp incluyen secciones “Adultos” que ofrecen enlaces de invitación para unirse a grupos de usuarios que intercambian imágenes de explotación infantil. TechCrunch ha revisado materiales que muestran que muchos de estos grupos están actualmente activos.

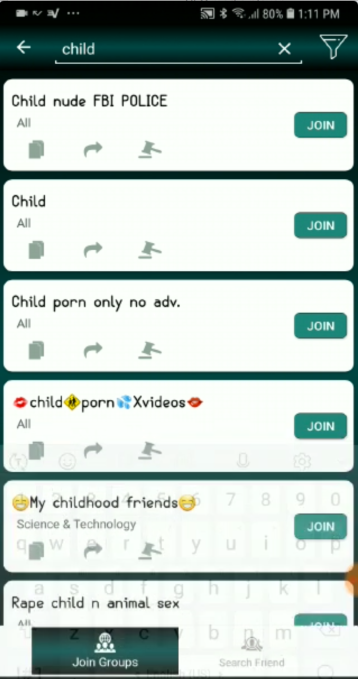

La investigación de TechCrunch muestra que Facebook podría hacer más para controlar WhatsApp y eliminar este tipo de contenido. Incluso sin soluciones técnicas que requieran un debilitamiento del cifrado, los moderadores de WhatsApp deberían haber podido encontrar estos grupos y detenerlos. Grupos con nombres como “pornografía infantil solo no adv” y “videos de pornografía infantil” encontrados en la aplicación de descubrimiento de grupo “Enlaces de grupo para lo que” por Lisa Studio ni siquiera intentes ocultar su naturaleza. Y una captura de pantalla proporcionada por la empresa anti-explotación AntiToxin revela grupos activos de WhatsApp con nombres como “Niños ???”O“ videos cp ”: una abreviatura conocida de“ pornografía infantil ”.

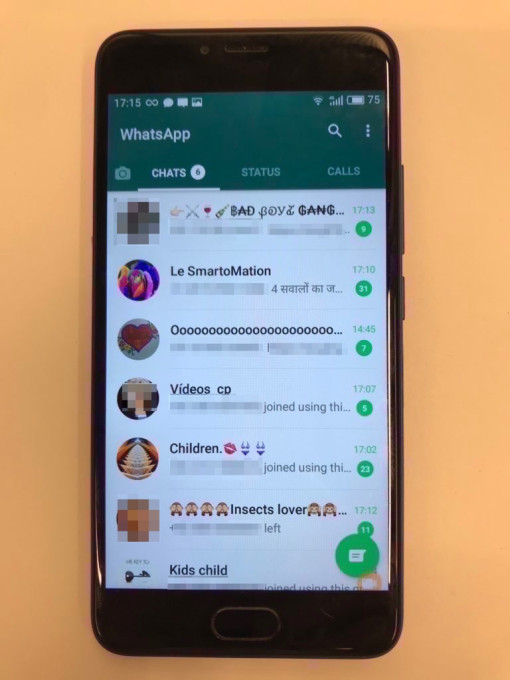

Una captura de pantalla de hoy de los grupos activos de explotación infantil en WhatsApp. Números de teléfono y fotos redactados. Proporcionado por AntiToxin.

Una mejor investigación manual de estas aplicaciones de descubrimiento de grupos y el propio WhatsApp debería haber llevado a que estos grupos se eliminen de inmediato y se elimine a sus miembros. Mientras que Facebook duplicó su personal de moderación de 10,000 a 20,000 en 2018 para acabar con la interferencia electoral, el acoso escolar y otras violaciones de políticas, ese personal no modera el contenido de WhatsApp. Con solo 300 empleados, WhatsApp funciona de manera semi-independiente, y la compañía confirma que maneja sus propios esfuerzos de moderación. Eso está resultando inadecuado para la vigilancia de una comunidad de 1.500 millones de usuarios.

Los hallazgos de las ONG Screen Savers y Netivei Reshet fueron escritos hoy por Tiempos financieros, pero TechCrunch está publicando el informe completo, su carta traducida a Facebook, los correos electrónicos traducidos con Facebook, su informe policial, además de los nombres de los grupos de pornografía infantil en WhatsApp y las aplicaciones de descubrimiento de grupos enumeradas anteriormente. Una nueva empresa llamada AntiToxin Technologies que investiga el tema respaldó el informe, proporcionó la captura de pantalla anterior y dijo que identificó más de 1,300 videos y fotografías de menores involucrados en actos sexuales en grupos de WhatsApp. Dado que la aplicación de Tumblr se retiró temporalmente de la tienda de aplicaciones de Apple por presuntamente albergar pornografía infantil, le hemos preguntado a Apple si suspenderá temporalmente a WhatsApp, pero no hemos recibido respuesta.

Descubriendo una pesadilla

En julio de 2018, las ONG se dieron cuenta del problema cuando un hombre informó a una de sus líneas directas que había visto pornografía hardcore en WhatsApp. En octubre, pasaron 20 días catalogando a más de 10 grupos de pornografía infantil, su contenido y las aplicaciones que permiten a las personas encontrarlos.

Las ONG comenzaron a comunicarse con la jefa de Política de Facebook, Jordana Cutler, a partir del 4 de septiembre. Pidieron una reunión cuatro veces para discutir sus hallazgos. Cutler solicitó pruebas por correo electrónico, pero no estuvo de acuerdo con una reunión, en lugar de eso, siguió las instrucciones de la policía israelí para instruir a los investigadores a ponerse en contacto con las autoridades. La ONG informó sus hallazgos a la policía israelí, pero se negó a proporcionar a Facebook su investigación. WhatsApp solo recibió su informe y la captura de pantalla de los grupos activos de pornografía infantil de TechCrunch.

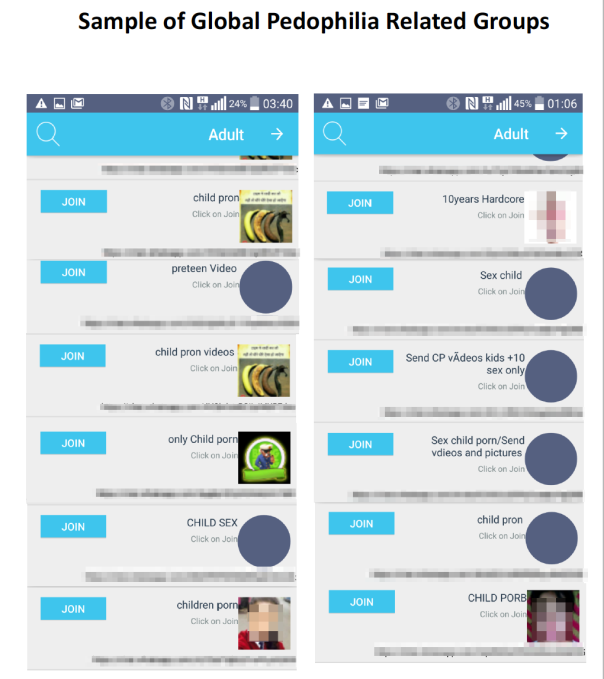

Listados de una aplicación de descubrimiento de grupos de grupos de explotación infantil en WhatsApp. Las URL y las fotos han sido redactadas.

WhatsApp me dice que ahora está investigando los grupos visibles a partir de la investigación que proporcionamos. Un portavoz de Facebook le dice a TechCrunch, “Mantener a las personas seguras en Facebook es fundamental para el trabajo de nuestros equipos en todo el mundo. Nos ofrecimos trabajar junto con la policía en Israel para iniciar una investigación para detener este abuso “. Una declaración del jefe de la Oficina de Protección Infantil en Línea de la Policía de Israel, Meir Hayoun, señala que:” En reuniones anteriores con Jordana, le pedí que siempre dile a cualquiera que quiera informar sobre cualquier contenido de pedofilia que se comunique con la policía israelí para reportar una queja “.

Un portavoz de WhatsApp me dice que si bien la pornografía legal para adultos está permitida en WhatsApp, prohibió 130,000 cuentas en un período reciente de 10 días por violar sus políticas contra la explotación infantil. En una declaración, WhatsApp escribió que:

WhatsApp tiene una política de tolerancia cero con respecto al abuso sexual infantil. Implementamos nuestra tecnología más avanzada, incluida la inteligencia artificial, para escanear fotos e imágenes de perfil en el contenido informado, y prohibir activamente las cuentas sospechosas de compartir este contenido vil. También respondemos a solicitudes de aplicación de la ley en todo el mundo e informamos de inmediato el abuso al Centro Nacional para Niños Desaparecidos y Explotados. Lamentablemente, dado que tanto las tiendas de aplicaciones como los servicios de comunicaciones están siendo utilizados para difundir contenido abusivo, las compañías de tecnología deben trabajar juntas para detenerlo.

Pero es esa excesiva dependencia de la tecnología y la subsiguiente falta de personal lo que parece haber permitido que el problema se agrave. El director ejecutivo de AntiToxin, Zohar Levkovitz, me dice: “¿Se puede argumentar que Facebook, sin saberlo, ha pirateado la pedofilia? Sí. Como padres y ejecutivos de tecnología, no podemos permanecer complacientes con eso “.

La moderación automatizada no lo corta

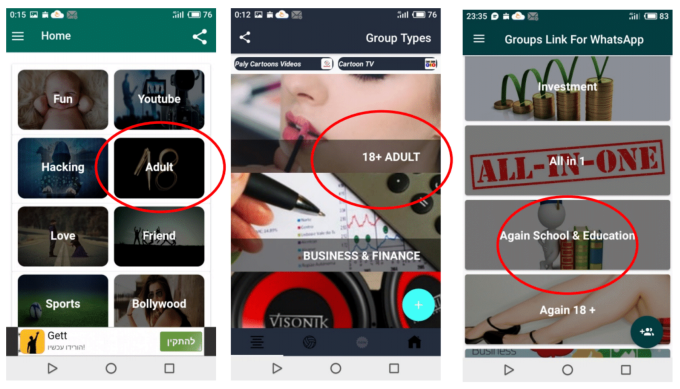

WhatsApp introdujo una función de enlace de invitación para grupos a finales de 2016, lo que hace que sea mucho más fácil descubrir y unirse a grupos sin conocer a ningún miembro. Los competidores como Telegram se habían beneficiado al aumentar la participación en las charlas de sus grupos públicos. WhatsApp probablemente vio a los grupos invitar a los enlaces como una oportunidad de crecimiento, pero no asignó suficientes recursos para monitorear grupos de extraños reuniéndose en torno a diferentes temas. Surgieron aplicaciones para permitir a las personas navegar por diferentes grupos por categoría. Cierto uso de estas aplicaciones es legítimo, ya que las personas buscan comunidades para hablar sobre deportes o entretenimiento. Pero muchas de estas aplicaciones ahora cuentan con secciones “para adultos” que pueden incluir enlaces de invitación a grupos legales para compartir pornografía, así como contenido ilegal de explotación infantil.

Un portavoz de WhatsApp me dice que analiza toda la información no cifrada en su red, básicamente todo lo que está fuera de los hilos del chat, incluidas las fotos de perfil de usuario, las fotos de perfil de grupo y la información de grupo. Busca hacer coincidir el contenido con los bancos PhotoDNA de pornografía infantil indexada que muchas compañías de tecnología utilizan para identificar imágenes inapropiadas previamente informadas. Si encuentra una coincidencia, esa cuenta o ese grupo y todos sus miembros, recibirá una prohibición de por vida de WhatsApp.

Las listas de una aplicación de descubrimiento de grupo de WhatsApp de grupos de explotación infantil en WhatsApp

Si las imágenes no coinciden con la base de datos pero se sospecha que muestran explotación infantil, se revisan manualmente. Si se descubre que es ilegal, WhatsApp prohíbe las cuentas y / o grupos, evita que se carguen en el futuro e informa sobre el contenido y las cuentas al Centro Nacional para Niños Desaparecidos y Explotados. El sistema de un solo ejemplo informado a WhatsApp por Financial Times ya fue marcado para revisión humana por su sistema automatizado, y luego fue prohibido junto con los 256 miembros.

Para desalentar el abuso, WhatsApp dice que limita los grupos a 256 miembros y, a propósito, no proporciona una función de búsqueda para personas o grupos dentro de su aplicación. No alienta la publicación de enlaces de invitación a grupos y la gran mayoría de los grupos tienen seis o menos miembros. Ya está trabajando con Google y Apple para hacer cumplir sus términos de servicio contra aplicaciones como las aplicaciones de descubrimiento de grupos de explotación infantil que abusan de WhatsApp. Ese tipo de grupos ya no se pueden encontrar en la App Store de Apple, pero siguen estando disponibles en Google Play. Nos contactamos con Google Play para preguntarle cómo aborda las aplicaciones ilegales de descubrimiento de contenido y si Group Links For Whats by Lisa Studio seguirá estando disponible, y se actualizará si nos comunicamos. [Update 3pm PT: Google has not provided a comment but the Group Links For Whats app by Lisa Studio has been removed from Google Play. That’s a step in the right direction.]

Pero la pregunta más importante es que si WhatsApp ya conocía estas aplicaciones de descubrimiento de grupos, ¿por qué no las estaba utilizando para localizar y prohibir grupos que violan sus políticas? Un portavoz afirmó que los nombres de grupo con “CP” u otros indicadores de explotación infantil son algunas de las señales que utiliza para cazar a estos grupos, y que los nombres en las aplicaciones de descubrimiento de grupo no necesariamente se correlacionan con los nombres de grupo en WhatsApp. Pero TechCrunch luego proporcionó una captura de pantalla que muestra grupos activos dentro de WhatsApp a partir de esta mañana, con nombres como “Niños ???”O“ videos cp ”. Eso demuestra que los sistemas automatizados y el personal magro de WhatsApp no son suficientes para evitar la propagación de imágenes ilegales.

La situación también plantea interrogantes acerca de las ventajas y desventajas del cifrado, ya que algunos gobiernos como Australia intentan evitar su uso mediante aplicaciones de mensajería. La tecnología puede proteger la libertad de expresión, mejorar la seguridad de los disidentes políticos y prevenir la censura por parte de los gobiernos y las plataformas tecnológicas. Sin embargo, también puede dificultar la detección de delitos y exacerbar el daño causado a las víctimas.

El portavoz de WhatsApp me dice que está detrás de un cifrado sólido de extremo a extremo que protege las conversaciones con sus seres queridos, médicos y más. Dijeron que hay muchas buenas razones para el cifrado de extremo a extremo y que continuará respaldándolo. Cambiar eso de cualquier manera, incluso para ayudar a atrapar a aquellos que explotan a los niños, requeriría un cambio significativo en la privacidad que garantiza a los usuarios. Sugirieron que los fabricantes de teléfonos tendrían que implementar el escaneo en el dispositivo en busca de contenido ilegal para evitar que se propague sin obstaculizar el cifrado.

Pero por ahora, WhatsApp necesita más moderadores humanos dispuestos a usar la investigación manual proactiva y no escalable para abordar su problema de pornografía infantil. Con Facebook ganando miles de millones en ganancias por trimestre y dotando de personal a sus propios rangos de moderación, no hay ninguna razón para que la supuesta autonomía de WhatsApp impida que aplique los recursos adecuados al problema. WhatsApp buscó crecer a través de grandes grupos públicos, pero no implementó las precauciones necesarias para garantizar que no se convirtieran en refugios para la explotación infantil. Las empresas tecnológicas como WhatsApp deben dejar de asumir que las soluciones tecnológicas baratas y eficientes son suficientes. Si quieren ganar dinero con grandes bases de usuarios, deben estar dispuestos a pagar para protegerlos y vigilarlos.