Si encuentras a los asistentes de voz frustrantemente tontos, no estás solo. La promesa muy publicitada de la conveniencia vocal impulsada por la IA rápidamente cae por las grietas de la pedantería robótica.

Una inteligencia artificial inteligente que tiene que volver (y a veces otra vez) para solicitar una entrada adicional para ejecutar su solicitud puede parecer especialmente tonta, cuando, por ejemplo, no se entiende que el taller de reparaciones más probable por el que está preguntando es no cualquiera de ellos, sino el que está estacionado afuera ahora.

Investigadores en el Instituto de Interacción Humano-Computadora en la Universidad Carnegie Mellon, trabajando con Gierad Laput, ingeniero de aprendizaje automático en Apple, hemos ideado un complemento de software de demostración para asistentes de voz que permite a los usuarios de teléfonos inteligentes aumentar la inteligencia de una IA en el dispositivo al darle una mano de ayuda, o más bien una cabeza de ayuda.

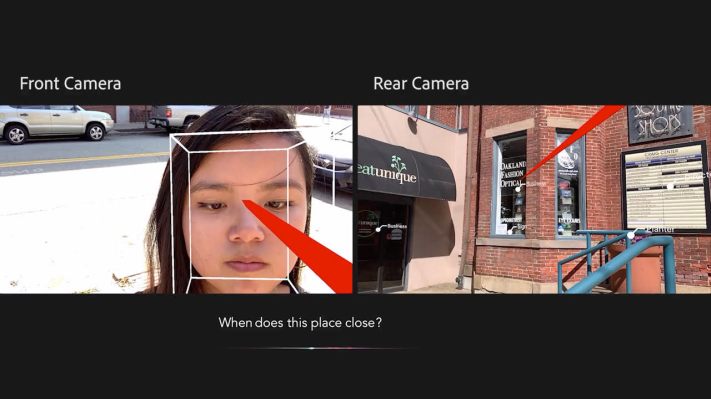

El sistema prototipo hace uso simultáneo de las cámaras delantera y trasera de un teléfono inteligente para poder ubicar la cabeza del usuario en el espacio físico, y más específicamente dentro de los alrededores inmediatos, que se analizan para identificar objetos en las cercanías utilizando tecnología de visión por computadora.

Luego, el usuario puede usar su cabeza como un puntero para dirigir su mirada a lo que sea que estén hablando, es decir, “ese garaje”, llenando sin palabras vacíos contextuales en la comprensión de la IA de una manera que los investigadores sostienen que es más natural.

Entonces, en lugar de necesitar hablar como un robot para aprovechar la utilidad de una IA de voz, puedes sonar un poco más, bueno, humano. Preguntando cosas como “‘ Siri, cuando hace ese ¿Starbucks cerca? O, en un entorno minorista, “¿hay otras opciones de color para ese ¿sofá?” O pedir una comparación de precios instantánea entre “esta silla y ese uno.” O para agregar una lámpara a su lista de deseos.

En un escenario de hogar / oficina, el sistema también podría permitir al usuario controlar de forma remota una variedad de dispositivos dentro de su campo de visión, sin necesidad de ser hiperespecífico al respecto. En cambio, solo podían mirar hacia el televisor inteligente o el termostato y hablar el ajuste de volumen / temperatura requerido.

El equipo ha reunido un video de demostración (a continuación) que muestra el prototipo, que llamaron WorldGaze, en acción. “Utilizamos la cámara frontal del iPhone para rastrear la cabeza en 3D, incluido su vector de dirección. Debido a que se conoce la geometría de las cámaras frontal y posterior, podemos emitir el vector de cabeza al mundo tal como lo ve la cámara trasera “, explican en el video.

“Esto permite al usuario definir intuitivamente un objeto o región de interés utilizando la mirada de la cabeza. Los asistentes de voz pueden utilizar esta información contextual para realizar consultas más precisas y naturales “.

En un trabajo de investigación que presenta el prototipo, también sugieren que podría usarse para “ayuda a socializar las experiencias de AR móvil, actualmente tipificadas por personas caminando por la calle mirando sus dispositivos “.

Cuando se le pidió que ampliara esto, el investigador de CMU Chris Harrison dijo a TechCrunch: “La gente siempre camina y mira sus teléfonos, lo cual no es muy social. No se relacionan con otras personas ni miran el hermoso mundo que los rodea. Con algo como WorldGaze, las personas pueden mirar hacia el mundo, pero aún así hacer preguntas a sus teléfonos inteligentes. Si camino por la calle, puedo preguntar y escuchar comentarios sobre restaurantes o agregar cosas a mi lista de compras sin tener que mirar mi teléfono. Pero el teléfono todavía tiene toda la inteligencia. No tengo que comprar algo extra o especial “.

En el documento, señalan que hay una gran cantidad de investigaciones relacionadas con el seguimiento de la mirada de los usuarios con fines interactivos, pero un objetivo clave de su trabajo aquí fue desarrollar “un prototipo funcional en tiempo real, limitándonos al hardware que se encuentra en los teléfonos inteligentes de consumo. . ” (Aunque el campo de visión de la cámara trasera es una limitación potencial que discuten, incluida la sugerencia de una solución parcial para cualquier hardware que se quede corto).

“Aunque WorldGaze podría iniciarse como una aplicación independiente, creemos que es más probable que WorldGaze se integre como un servicio en segundo plano que se activa con un activador de asistente de voz (por ejemplo,” Hey Siri “)”, también escriben. “Aunque abrir ambas cámaras y realizar el procesamiento de la visión por computadora consume mucha energía, el ciclo de trabajo sería tan bajo que no afectaría significativamente la vida útil de la batería de los teléfonos inteligentes actuales. Incluso puede ser que solo se necesite un solo cuadro de ambas cámaras, después de lo cual pueden apagarse (el tiempo de inicio de WorldGaze es de 7 segundos). Usando equipos de banco, estimamos el consumo de energía en ~ 0.1 mWh por consulta ”.

Por supuesto, todavía hay algo un poco incómodo acerca de un humano sosteniendo una pantalla frente a su cara y hablando con él, pero Harrison confirma que el software podría funcionar con las manos libres en un par de anteojos inteligentes.

“Ambos son posibles”, nos dijo. “Elegimos centrarnos en los teléfonos inteligentes simplemente porque todos tienen uno (y WorldGaze podría ser literalmente una actualización de software), mientras que casi nadie tiene anteojos AR (todavía). Pero la premisa de usar donde está buscando sobrecargar a los asistentes de voz se aplica a ambos “.

“Cada vez más, las gafas AR incluyen sensores para rastrear la ubicación de la mirada (por ejemplo, Magic Leap, que lo usa por razones de enfoque), por lo que en ese caso, solo se necesitan cámaras orientadas hacia afuera ”, agregó.

Dando un salto más, es posible imaginar que este sistema se combine con la tecnología de reconocimiento facial, para permitir que un usuario inteligente de especificaciones pueda inclinar la cabeza en silencio y preguntar “quién es ese? – asumiendo que los datos faciales necesarios estaban legalmente disponibles en los bancos de memoria de la IA.

Las funciones como “agregar a contactos” o “cuándo nos conocimos por última vez” podrían desbloquearse para aumentar una experiencia de redes o socialización. Aunque, en este punto, las implicaciones de privacidad de liberar un sistema de este tipo en el mundo real parecen bastante más desafiantes que unir la ingeniería. (Ver, por ejemplo, Apple que prohíbe la aplicación Clearview AI por violar sus reglas).

“Tendría que haber un nivel de seguridad y permisos para aceptar esto, y no es algo que contemplemos en este momento, pero es una idea interesante (y potencialmente aterradora)”, coincide Harrison cuando preguntamos acerca de tal posibilidad.

El equipo debía presentar la investigación en ACM CHI, pero la conferencia se canceló debido al coronavirus.

Source link