Meta afirma que su nuevo modelo de IA de código abierto, ImageBind, es un paso hacia sistemas que imitan mejor la forma en que los humanos aprenden, estableciendo conexiones entre múltiples tipos de datos a la vez de manera similar a cómo los humanos dependen de múltiples sentidos. El interés generalizado en la IA generativa se ha disparado en los últimos años con el surgimiento de generadores de texto a imagen como DALL-E de OpenAI y modelos conversacionales como ChatGPT. Estos sistemas se entrenan utilizando conjuntos de datos masivos de cierto tipo de material, como imágenes o texto, para que finalmente puedan aprender a producir los suyos propios.

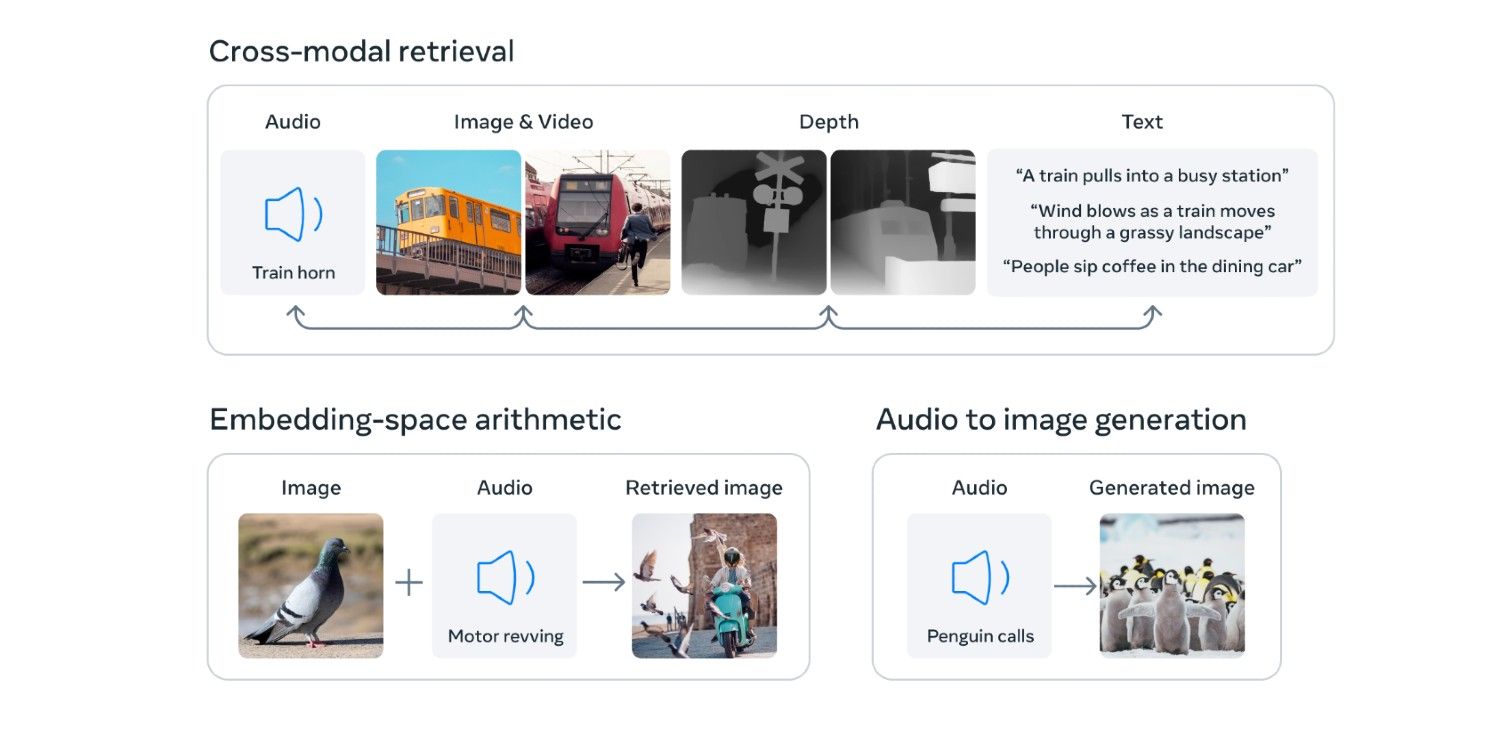

Con ImageBind, Meta tiene como objetivo facilitar el desarrollo de modelos de IA que puedan captar el panorama general. Tomando un más “holístico” para el aprendizaje automático, puede vincular seis tipos diferentes de datos: texto, visual (imagen/video), audio, profundidad, temperatura y movimiento. La capacidad de establecer conexiones entre más tipos de datos permite que el modelo de IA asuma tareas más complejas y produzca resultados más complejos. ImageBind podría usarse para generar imágenes basadas en clips de audio y viceversa, según Meta, o agregar elementos ambientales para una experiencia más inmersiva.

Según Meta, “ImageBind equipa a las máquinas con una comprensión holística que conecta los objetos en una foto con cómo sonarán, su forma 3D, qué tan cálidos o fríos están y cómo se mueven.Los modelos actuales de IA tienen un alcance más limitado. Pueden aprender, por ejemplo, a detectar patrones en conjuntos de datos de imágenes para, a su vez, generar imágenes originales a partir de indicaciones de texto, pero lo que Meta prevé va mucho más allá.

Las imágenes estáticas podrían convertirse en escenas animadas usando indicaciones de audio, dice Meta, o el modelo podría usarse como “una rica manera de explorar los recuerdos” al permitir que una persona busque sus mensajes y bibliotecas de medios para eventos o conversaciones específicos mediante mensajes de texto, audio e imágenes. Podría llevar algo como la realidad mixta a un nuevo nivel. Las versiones futuras podrían incorporar incluso más tipos de datos para impulsar aún más sus capacidades, como “señales del tacto, el habla, el olfato y la resonancia magnética funcional del cerebro” a “habilitar modelos de IA centrados en humanos más ricos.”

Sin embargo, ImageBind aún está en pañales y el Meta Los investigadores están invitando a otros a explorar el modelo de IA de código abierto y desarrollarlo. El equipo ha publicado un artículo junto con la publicación del blog que detalla la investigación, y el código está disponible en GitHub.

Fuente: Meta, GitHub

Source link