Millones de personas se comunican usando el lenguaje de señas, pero hasta ahora los proyectos para capturar sus complejos gestos y traducirlos al habla verbal han tenido un éxito limitado. Un nuevo avance en el seguimiento de manos en tiempo real de los laboratorios de IA de Google, sin embargo, podría ser el gran avance que algunos han estado esperando.

La nueva técnica utiliza algunos atajos inteligentes y, por supuesto, la creciente eficiencia general de los sistemas de aprendizaje automático para producir, en tiempo real, un mapa de alta precisión de la mano y todos sus dedos, utilizando únicamente un teléfono inteligente y su cámara.

“Mientras que los enfoques de vanguardia actuales se basan principalmente en potentes entornos de escritorio para la inferencia, nuestro método logra un rendimiento en tiempo real en un teléfono móvil e incluso se adapta a varias manos”, escriben los investigadores de Google Valentin Bazarevsky y Fan Zhang en un artículo. entrada en el blog. “La percepción sólida de la mano en tiempo real es una tarea de visión por computadora decididamente desafiante, ya que las manos a menudo se ocluyen entre sí (por ejemplo, oclusiones de dedos/palmas y temblores de manos) y carecen de patrones de alto contraste”.

No solo eso, sino que los movimientos de las manos a menudo son rápidos, sutiles o ambos, no necesariamente el tipo de cosas que las computadoras son buenas para captar en tiempo real. Básicamente, es muy difícil hacerlo bien, y hacerlo bien es difícil de hacer rápido. Incluso con equipos de detección de profundidad multicámara como los utilizados por SignAll tienen problemas para rastrear cada movimiento. (Pero eso no los detiene).

El objetivo de los investigadores en este caso, al menos en parte, era reducir la cantidad de datos que los algoritmos necesitaban filtrar. Menos datos significa un cambio más rápido.

Por un lado, abandonaron la idea de tener un sistema que detecte la posición y el tamaño de toda la mano. En su lugar, solo hacen que el sistema encuentre la palma, que no solo es la parte más distintiva y con la forma más confiable de la mano, sino que además es cuadrada, lo que significa que no tenían que preocuparse de que el sistema pudiera manejar objetos rectangulares altos. imágenes, cortos y así sucesivamente.

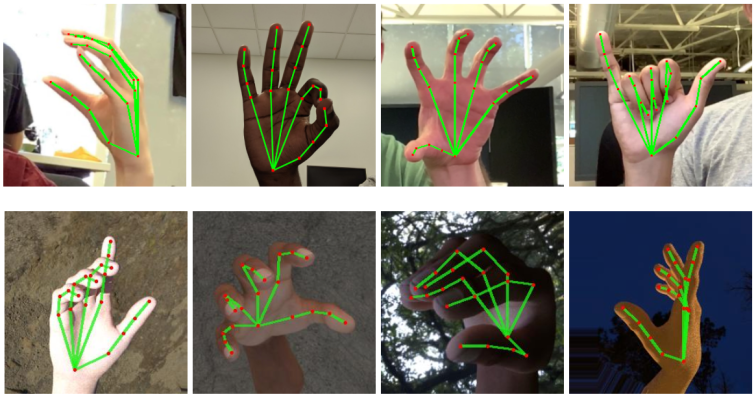

Una vez que se reconoce la palma, por supuesto, los dedos brotan de un extremo y se pueden analizar por separado. Un algoritmo separado mira la imagen y le asigna 21 coordenadas, coordinadas aproximadamente con los nudillos y las yemas de los dedos, incluida la distancia probable (puede adivinar en función del tamaño y el ángulo de la palma, entre otras cosas).

Para hacer esta parte de reconocimiento de dedos, primero tuvieron que agregar manualmente esos 21 puntos a unas 30,000 imágenes de manos en varias poses y situaciones de iluminación para que el sistema de aprendizaje automático las ingiera y aprenda. Como de costumbre, la inteligencia artificial se basa en el arduo trabajo humano para ponerse en marcha.

Una vez que se determina la pose de la mano, esa pose se compara con un montón de gestos conocidos, desde símbolos de lenguaje de señas para letras y números hasta cosas como “paz” y “metal”.

El resultado es un algoritmo de seguimiento manual que es rápido y preciso, y se ejecuta en un teléfono inteligente normal en lugar de en una computadora de escritorio modificada o en la nube (es decir, la computadora de escritorio modificada de otra persona). Todo se ejecuta dentro del marco de MediaPipe, del que la gente de tecnología multimedia ya puede saber algo.

Con suerte, otros investigadores podrán tomar esto y ejecutarlo, tal vez mejorando los sistemas existentes que necesitaban un hardware más robusto para hacer el tipo de reconocimiento de manos que necesitaban para reconocer gestos. Sin embargo, hay un largo camino desde aquí hasta comprender realmente el lenguaje de señas, que usa ambas manos, expresiones faciales y otras señales para producir un rico modo de comunicación como ningún otro.

Esto aún no se está utilizando en ningún producto de Google, por lo que los investigadores pudieron regalar su trabajo de forma gratuita. El código fuente está aquí para que cualquiera lo tome y lo desarrolle.

“Esperamos que proporcionar esta funcionalidad de percepción manual a la comunidad de investigación y desarrollo más amplia resulte en la aparición de casos de uso creativo, estimulando nuevas aplicaciones y nuevas vías de investigación”, escriben.

Source link