Apple a finales de este año lanzará nuevas herramientas que advertirán a los niños y padres si el niño envía o recibe fotos sexualmente explícitas a través de la aplicación Mensajes. La función es parte de un puñado de nuevas tecnologías que Apple está introduciendo con el objetivo de limitar la propagación del Material de Abuso Sexual Infantil (CSAM) en las plataformas y servicios de Apple.

Como parte de estos desarrollos, Apple podrá detectar imágenes CSAM conocidas en sus dispositivos móviles, como iPhone y iPad, y en fotos cargadas a iCloud, sin dejar de respetar la privacidad del consumidor.

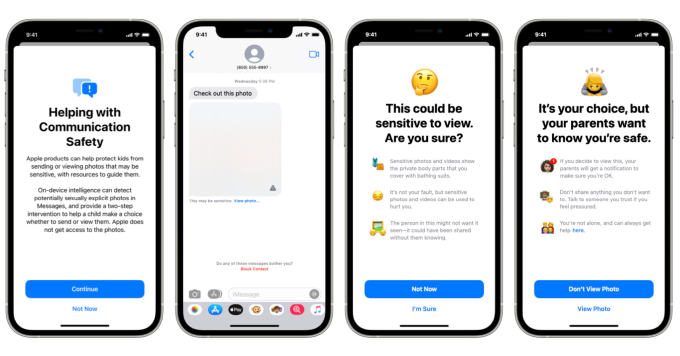

Mientras tanto, la nueva función de Mensajes está destinada a permitir que los padres desempeñen un papel más activo e informado cuando se trata de ayudar a sus hijos a aprender a navegar la comunicación en línea. A través de una actualización de software que se implementará a finales de este año, Messages podrá usar el aprendizaje automático en el dispositivo para analizar los archivos adjuntos de imágenes y determinar si una foto que se comparte es sexualmente explícita. Esta tecnología no requiere que Apple acceda o lea las comunicaciones privadas del niño, ya que todo el procesamiento ocurre en el dispositivo. No se devuelve nada a los servidores de Apple en la nube.

Si se descubre una foto sensible en un hilo de mensajes, la imagen se bloqueará y aparecerá una etiqueta debajo de la foto que dice “esto puede ser sensible” con un enlace para hacer clic para ver la foto. Si el niño elige ver la foto, aparece otra pantalla con más información. Aquí, un mensaje le informa al niño que las fotos y videos sensibles “muestran las partes privadas del cuerpo que cubre con trajes de baño” y “no es su culpa, pero las fotos y videos sensibles pueden usarse para hacerle daño”.

También sugiere que la persona en la foto o el video puede no querer que se vea y podría haber sido compartido sin su conocimiento.

Créditos de imagen: manzana

Estas advertencias tienen como objetivo ayudar a guiar al niño a tomar la decisión correcta al optar por no ver el contenido.

Sin embargo, si el niño hace clic para ver la foto de todos modos, se le mostrará una pantalla adicional que le informa que si eligen ver la foto, se notificará a sus padres. La pantalla también explica que sus padres quieren que estén seguros y sugiere que el niño hable con alguien si se siente presionado. También ofrece un enlace a más recursos para obtener ayuda.

Todavía hay una opción en la parte inferior de la pantalla para ver la foto, pero nuevamente, no es la opción predeterminada. En cambio, la pantalla está diseñada de una manera en la que la opción de no ver la foto está resaltada.

Este tipo de funciones podrían ayudar a proteger a los niños de los depredadores sexuales, no solo mediante la introducción de tecnología que interrumpe las comunicaciones y ofrece consejos y recursos, sino también porque el sistema alertará a los padres. En muchos casos en los que un niño es herido por un depredador, los padres ni siquiera se dieron cuenta de que el niño había comenzado a hablar con esa persona en línea o por teléfono. Esto se debe a que los depredadores de niños son muy manipuladores e intentarán ganarse la confianza del niño y luego aislar al niño de sus padres para mantener las comunicaciones en secreto. En otros casos, los depredadores también han preparado a los padres.

La tecnología de Apple podría ayudar en ambos casos interviniendo, identificando y alertando sobre materiales explícitos que se comparten.

Sin embargo, una cantidad cada vez mayor de material CSAM es lo que se conoce como CSAM autogenerado, o imágenes tomadas por el niño, que luego pueden compartirse de manera consensuada con la pareja o compañeros del niño. En otras palabras, enviar mensajes de texto o compartir “desnudos”. Según una encuesta de 2019 de Thorn, una empresa que desarrolla tecnología para combatir la explotación sexual de niños, esta práctica se ha vuelto tan común que 1 de cada 5 niñas de 13 a 17 años dijo haber compartido sus propios desnudos, y 1 de cada 10 niños lo hizo. lo mismo. Pero es posible que el niño no comprenda completamente cómo compartir esas imágenes lo pone en riesgo de abuso y explotación sexual.

La nueva función de Mensajes también ofrecerá un conjunto similar de protecciones aquí. En este caso, si un niño intenta enviar una foto explícita, se le advertirá antes de que se envíe la foto. Los padres también pueden recibir un mensaje si el niño decide enviar la foto de todos modos.

Apple dice que la nueva tecnología llegará como parte de una actualización de software a finales de este año a las cuentas configuradas como familias en iCloud para iOS 15, iPadOS 15 y macOS Monterey en los EE. UU.

Esta actualización también incluirá actualizaciones de Siri y Search que ofrecerán orientación y recursos ampliados para ayudar a los niños y padres a mantenerse seguros en línea y obtener ayuda en situaciones inseguras. Por ejemplo, los usuarios podrán preguntarle a Siri cómo denunciar CSAM o explotación infantil. Siri y Search también intervendrán cuando los usuarios busquen consultas relacionadas con CSAM para explicar que el tema es dañino y proporcionar recursos para obtener ayuda.

Source link