Las voces en Alexa de Amazon, el Asistente de Google y otros asistentes de IA son más adelante de los dispositivos GPS de la vieja escuela, pero todavía carecen de los ritmos, la entonación y otras cualidades que hacen que el habla suene, bueno, humana. NVIDIA ha presentado nuevas investigaciones y herramientas que pueden capturar esas cualidades naturales del habla al permitirle entrenar el sistema de IA con su propia voz, anunció la compañía en el Interspeech 2021 conferencia.

Para mejorar su síntesis de voz de IA, el equipo de investigación de texto a voz de NVIDIA desarrolló un modelo llamado RAD-TTS, una entrada ganadora en una competencia de la convención de transmisión de NAB para desarrollar el avatar más realista. El sistema permite a una persona entrenar un modelo de conversión de texto a voz con su propia voz, incluido el ritmo, la tonalidad, el timbre y más.

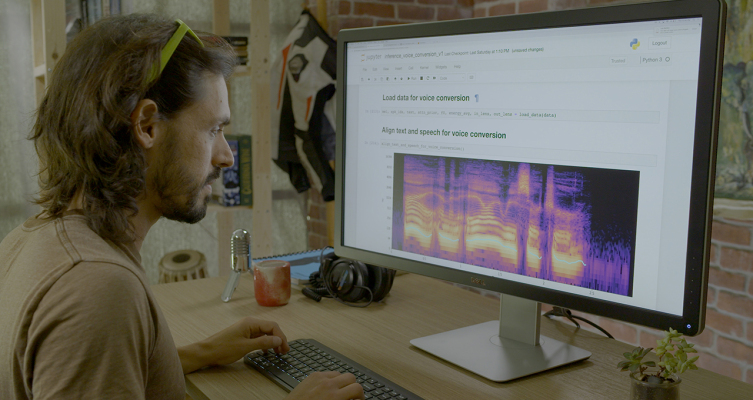

Otra característica de RAD-TTS es la conversión de voz, que permite al usuario pronunciar las palabras de un hablante utilizando la voz de otra persona. Esa interfaz brinda un control fino a nivel de cuadro sobre el tono, la duración y la energía de una voz sintetizada.

Usando esta tecnología, los investigadores de NVIDIA crearon una narración de voz más conversacional para su propia Soy una serie de videos de IA utilizando voces sintetizadas en lugar de humanas. El objetivo era lograr que la narración coincidiera con el tono y el estilo de los videos, algo que no se ha hecho bien en muchos videos narrados por IA hasta la fecha. Los resultados siguen siendo un poco robóticos, pero mejores que cualquier narración de IA que haya escuchado.

“Con esta interfaz, nuestro productor de video podría grabarse a sí mismo leyendo el guión del video y luego usar el modelo de IA para convertir su discurso en la voz de la narradora. Usando esta narración básica, el productor podría dirigir la IA como un actor de voz, ajustando el discurso sintetizado para enfatizar palabras específicas y modificando el ritmo de la narración para expresar mejor el tono del video ”, escribió NVIDIA.

NVIDIA está distribuyendo parte de esta investigación, optimizada para ejecutarse de manera eficiente en las GPU de NVIDIA, por supuesto, a cualquiera que quiera probarla a través de código abierto a través del kit de herramientas NVIDIA NeMo Python para IA conversacional acelerada por GPU, disponible en el centro de contenedores NGC de la compañía. y otro software.

“Varios de los modelos están entrenados con decenas de miles de horas de datos de audio en sistemas NVIDIA DGX. Los desarrolladores pueden ajustar cualquier modelo para sus casos de uso, acelerando el entrenamiento utilizando computación de precisión mixta en las GPU NVIDIA Tensor Core ”, escribió la compañía.

Nota del editor: Esta publicación apareció originalmente en Engadget.

Source link