Un panel de expertos del gobierno recomendó no prohibir las armas guiadas por IA y Estados Unidos sugirió un código de conducta a las Naciones Unidas.

En una reunión de las Naciones Unidas, Estados Unidos argumentó en contra de la prohibición de armas robots, lo que sugiere que pueden manejarse a sí mismos siguiendo un código de conducta. Cuando comenzaron estas discusiones hace varios años, es posible que el público no estuviera muy familiarizado con la inteligencia artificial. Sin embargo, en 2021, la tecnología se ha vuelto omnipresente con todos los teléfonos inteligentes y cada altavoz inteligente que intenta con éxito limitado comprender lo que quiere el ser humano.

La discusión sobre robots armados comenzó en la ONU ya en 2014, pero el tema tiene una historia muy larga. El cuento de Isaac Asimov Corre alrededor detallado el ‘Tres leyes de la robótica’ y la fecha de su creación en la historia de ciencia ficción fue 2058 d.C. Eso es inquietantemente cercano al tiempo presente considerando que la historia fue escrita hace casi ochenta años. El primero es “Un robot no puede dañar a un ser humano o, por inacción, permitir que un ser humano sufra daño”. Las ‘Tres Leyes’ son ampliamente consideradas como un excelente comienzo para el desarrollo robótico avanzado impulsado por IA.

En una reciente reunión de la ONU en Ginebra, el guardián informa, luego de los llamados a prohibir las armas letales autónomas, Estados Unidos sugirió un código de conducta no vinculante como la mejor manera de avanzar, tal vez reconociendo que era poco probable un consenso sobre el tema. De acuerdo a Reuters, El Congreso consultó a un panel de expertos en inteligencia artificial designado por el gobierno dirigido por Eric Schmidt, ex director ejecutivo de Google, sobre el uso de la inteligencia artificial en la seguridad nacional. El panel recomendó la anti-proliferación pero no la prohibición del uso de IA en la investigación y tecnología de armas. Grupo de expertos de Washington DC Fundación de Tecnología de la Información e Innovación organizó un podcast en el que los expertos en defensa advirtieron del peligro de quedarse fuera mientras otros países desarrollan estas tecnologías.

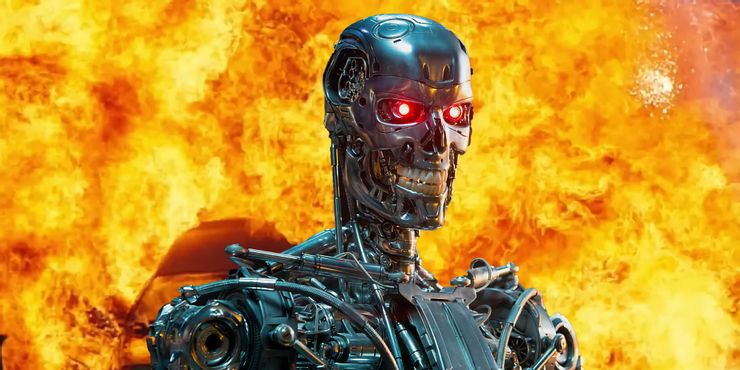

¿Son los robots asesinos una amenaza real?

Si bien la falta de acuerdo sobre la investigación y el uso de inteligencia artificial para automatizar robots armados es inquietante, la amenaza de armas completamente autónomas aún es algo lejana. En la actualidad, todavía se requiere autorización humana para lanzar ataques, sin embargo, nunca es demasiado pronto para considerar la posibilidad e intentar llegar a algún acuerdo, como lo demuestran los muchos años que este tema ha surgido en las reuniones de la ONU sin una resolución.

El argumento a favor de los robots armados es que salvarán la vida de los soldados e incluso podrían utilizarse como elementos disuasorios para las misiones de mantenimiento de la paz. El extremo opuesto sugiere que los ‘robots asesinos’ se volverán locos y destruirán a todos los humanos. La verdad se encuentra en algún punto intermedio. Ciertamente, hay un motivo de preocupación. La pérdida de vidas es un desincentivo para emprender la guerra, sin embargo, si ese riesgo se eliminó por un lado, podría resultar demasiado fácil involucrarse en un comportamiento agresivo. Si bien algunos expertos en inteligencia artificial pueden confiar en la confiabilidad y previsibilidad de las armas autónomas futuras, un “código de conducta no vinculante” para robots Parece un plan demasiado débil para una tecnología tan letal.

Fuente: Guardian, Reuters, Information Technology & Innovation Foundation