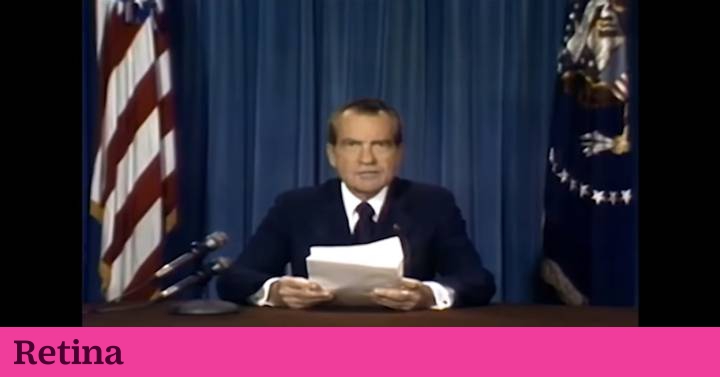

El año pasado, el actor estadounidense Lewis D. Wheeler dio vida a Richard Nixon en un corto ficticio. Pero no fue un trabajo de interpretación convencional: Wheeler solo actuó a través del tono de su voz y los movimientos de su boca y su cara. Basándose en esta información corporal, un grupo de científicos del MIT utilizó varios sistemas de inteligencia artificial para unir la imagen del expresidente a la interpretación del actor. Como resultado, lo que se veía en pantalla no era a alguien caracterizado como Nixon y hablando como él, sino al mismísimo expresidente de los Estados Unidos pronunciando un discurso sobre el fracaso de la llegada a la luna que nunca había dicho realmente.

Los vídeos falsos hiperrealistas se utilizaron inicialmente como una forma de divulgar contenido falso: aplicando la inteligencia artificial se podía hacer que cualquiera dijera cualquier cosa de forma creíble. En los últimos años, se están profesionalizando y cada vez más investigaciones indagan en cómo pueden utilizarse de forma más ética. Uno de esos usos es basarse en la interpretación de un actor de carne y hueso para devolver a la pantalla a personajes fallecidos, como en el caso de Richard Nixon.

Hacer un casting y preparar la actuación para grabar un deepfake es algo relativamente nuevo. A medida que se han vuelto cada vez más realistas, más artistas y cineastas han comenzado a usarlos. Esto muchas veces implica contratar a actores reales para que interpreten algún aspecto de la actuación. Así que Francesca Panetta y Halsey Burgund, dos de los responsables de la investigación del MIT, se asociaron con dos empresas de inteligencia artificial para comprender mejor qué requisitos debía cumplir el intérprete para protagonizar su vídeo. “Necesitábamos encontrar a alguien que estuviera dispuesto a hacer esto, porque es una propuesta un poco extraña”, cuenta Burgund. “Alguien que fuera flexible en su pensamiento sobre lo que hace un actor”.

Al reemplazar los diálogos, se utilizan los movimientos de la boca de Wheeler para adaptar la boca de Nixon en las imágenes originales. El actor actúa como titiritero y nunca se le ve en el producto final. La apariencia, el género, la edad y el origen étnico de la persona realmente no importan. Pero para el audio, encontraron que sería más fácil trabajar con un actor que tuviera un registro y acento similar al de Nixon. Sabiendo esto, Panetta y Burgund comenzaron a publicar anuncios en varios foros de actuación y a enviar correos electrónicos a grupos de actuación locales.

Así fue como Lewis D. Wheeler se encontró encerrado en un estudio durante días escuchando y repitiendo cientos de fragmentos de audio de Nixon, cada uno de solo unos segundos. Algunos de ellos ni siquiera eran palabras completas. A estos fragmentos se les añadía la entonación de Wheeler: dada la gravedad del discurso del supuesto desastre lunar, necesitaban captar el mismo tono sombrío. El trabajo de Wheeler consistía en volver a grabar cada frase con su propia voz, haciendo coincidir el ritmo y la entonación exactos.

La parte visual fue mucho más sencilla. En las imágenes de archivo que serían manipuladas, Nixon ya se encontraba dando un discurso hablando directamente a la cámara. Wheeler solo necesitaba actuar su propuesta, de principio a fin, de la misma manera, para que el equipo de producción capturara los movimientos de su boca en el ángulo correcto.

Fuera del ámbito de la investigación científica, también se están llevando a cabo otros proyectos cinematográficos con esta misma tecnología. Es el caso del corto #Intolerance is still there, de la plataforma Héroes de hoy. La historia está ambientada en los disturbios de Stonewall (NYC) en 1969, la noche en que la comunidad LGTBI+ se rebeló contra una redada policial. Esta pieza denuncia además la historia de Julio Zúñiga, activista gay mexicano. Zúñiga nunca estuvo en los disturbios de Stonewall, ni tampoco en el rodaje del corto, ya que murió asesinado en México en 2017, víctima de un crimen de odio por su condición sexual. Pero, gracias al deepfake y a las técnicas de 3D, aparece en esta película.

“Teníamos a un actor de carne y hueso que estaba en el plató y que nos servía de referencia para recrear la imagen y el movimiento de Zúñiga”, cuenta Daniel Rodriguez, director creativo ejecutivo de DDB España. “Establecimos varios puntos de referencia en su cara para que luego en postproducción, y con la ayuda de la inteligencia artificial, pudiéramos ponerle la cara de Zúñiga”. Rodríguez y su equipo utilizaron esta técnica en los planos intermedios y lejanos, pero se encontraron con ciertas limitaciones. “Cuando el plano se cerraba, se notaba que la cara no era real, así que complementamos esta técnica con el modelado de 3D”.

En su caso, había pocas imágenes disponibles de Zúñiga, lo que dificultó el entrenamiento de los algoritmos para reconstruir su cara sobre las referencias físicas del actor. “Contar con pocos datos para enseñar a la IA supuso un reto para recrear los gestos de nuestro personaje, pero es una tarea mucho más sencilla cuando quieres devolver a la vida a alguien muy famoso de quien tengas muchas referencias visuales”. En este corto necesitaban que la caracterización fuera perfecta para que no se notara que era un actor, así que la combinación de varias técnicas fue clave volver a ver en pantalla a alguien fallecido hace tres años.

Source link