El próximo avance para conquistar el mundo de la IA podrían ser los generadores de modelos 3D. Esta semana, OpenAI Point-E de código abierto, un sistema de aprendizaje automático que crea un objeto 3D al recibir un mensaje de texto. De acuerdo a una papel publicado junto con el código basePoint-E puede producir modelos 3D en 1 a 2 minutos en una sola GPU Nvidia V100.

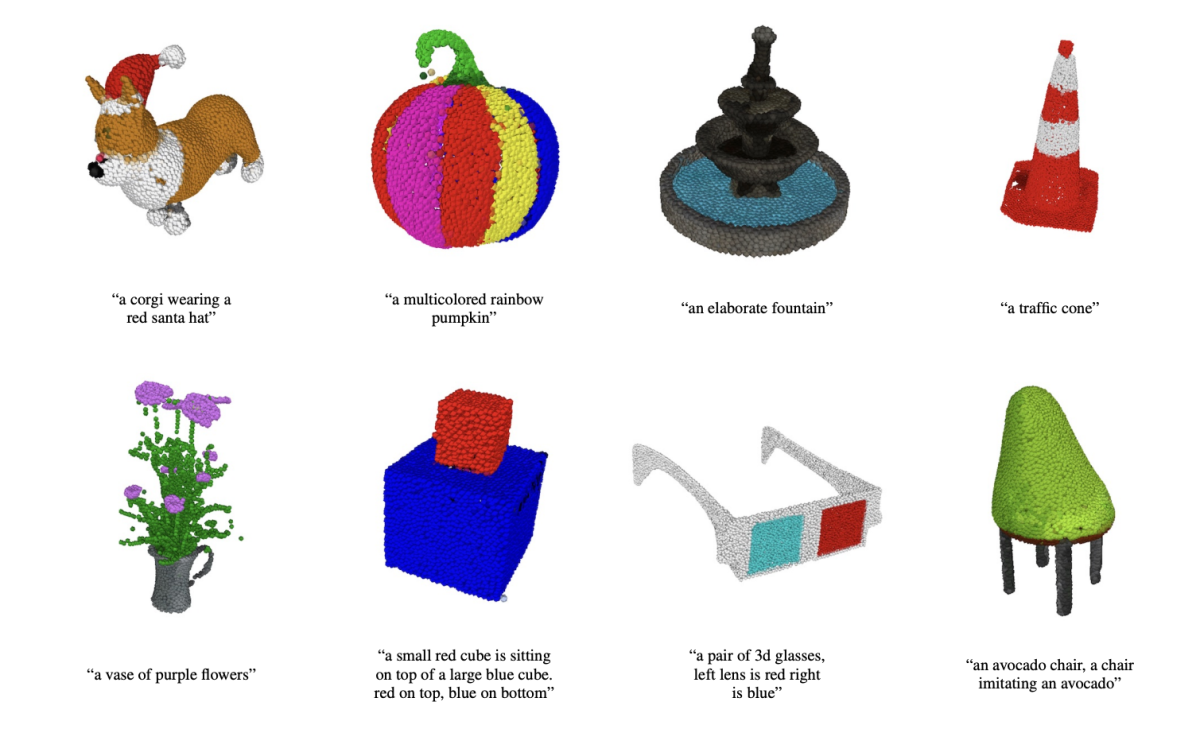

Point-E no crea objetos 3D en el sentido tradicional. Más bien, genera nubes de puntos, o conjuntos discretos de puntos de datos en el espacio que representan una forma 3D, de ahí la abreviatura descarada. (La “E” en Point-E es la abreviatura de “eficiencia”, porque aparentemente es más rápida que los enfoques de generación de objetos 3D anteriores). Las nubes de puntos son más fáciles de sintetizar desde un punto de vista computacional, pero no capturan la granularidad fina de un objeto. forma o textura: una limitación clave de Point-E actualmente.

Para sortear esta limitación, el equipo de Point-E entrenó un sistema de IA adicional para convertir las nubes de puntos de Point-E en mallas. (Las mallas, las colecciones de vértices, bordes y caras que definen un objeto, se usan comúnmente en el modelado y diseño en 3D). Pero señalan en el documento que el modelo a veces puede pasar por alto ciertas partes de los objetos, lo que da como resultado formas bloqueadas o distorsionadas.

Créditos de imagen: IA abierta

Fuera del modelo de generación de malla, que es independiente, Point-E consta de dos modelos: un modelo de texto a imagen y un modelo de imagen a 3D. El modelo de texto a imagen, similar a los sistemas de arte generativo como DALL-E 2 y Stable Diffusion, se entrenó en imágenes etiquetadas para comprender las asociaciones entre palabras y conceptos visuales. El modelo de imagen a 3D, por otro lado, recibió un conjunto de imágenes emparejadas con objetos 3D para que aprendiera a traducir de manera efectiva entre los dos.

Cuando se le presenta un mensaje de texto, por ejemplo, “un engranaje imprimible en 3D, un solo engranaje de 3 pulgadas de diámetro y media pulgada de grosor”, el modelo de texto a imagen de Point-E genera un objeto renderizado sintético que se alimenta a la imagen a imagen. modelo 3D, que luego genera una nube de puntos.

Después de entrenar los modelos en un conjunto de datos de “varios millones” de objetos 3D y metadatos asociados, Point-E podría producir nubes de puntos de colores que con frecuencia coincidían con las indicaciones de texto, dicen los investigadores de OpenAI. No es perfecto: el modelo de imagen a 3D de Point-E a veces no comprende la imagen del modelo de texto a imagen, lo que da como resultado una forma que no coincide con el mensaje de texto. Aún así, es mucho más rápido que el estado del arte anterior, al menos según el equipo de OpenAI.

Convertir las nubes de puntos Point-E en mallas.

“Si bien nuestro método funciona peor en esta evaluación que las técnicas más modernas, produce muestras en una pequeña fracción del tiempo”, escribieron en el artículo. “Esto podría hacerlo más práctico para ciertas aplicaciones, o podría permitir el descubrimiento de objetos 3D de mayor calidad”.

¿Cuáles son las aplicaciones, exactamente? Bueno, los investigadores de OpenAI señalan que las nubes de puntos de Point-E podrían usarse para fabricar objetos del mundo real, por ejemplo, a través de la impresión 3D. Con el modelo adicional de conversión de malla, el sistema podría, una vez que esté un poco más pulido, también encontrar su camino en los flujos de trabajo de desarrollo de juegos y animaciones.

OpenAI podría ser la última compañía en saltar a la refriega del generador de objetos 3D, pero, como se mencionó anteriormente, ciertamente no es la primera. A principios de este año, Google lanzó DreamFusion, una versión ampliada de Dream Fields, un sistema 3D generativo que la empresa presentó en 2021. A diferencia de Dream Fields, DreamFusion no requiere capacitación previa, lo que significa que puede generar representaciones 3D de objetos sin datos 3D.

Si bien todos los ojos están puestos en los generadores de arte 2D en la actualidad, la IA de síntesis de modelos podría ser el próximo gran disruptor de la industria. Los modelos 3D se utilizan ampliamente en cine y televisión, diseño de interiores, arquitectura y varios campos científicos. Las empresas de arquitectura los utilizan para hacer demostraciones de edificios y paisajes propuestos, por ejemplo, mientras que los ingenieros aprovechan los modelos como diseños de nuevos dispositivos, vehículos y estructuras.

Casos de falla del punto E.

Sin embargo, los modelos 3D suelen tardar un tiempo en crearse, entre varias horas y varios días. AI como Point-E podría cambiar eso si algún día se resuelven los problemas, y hacer que OpenAI obtenga una ganancia respetable al hacerlo.

La pregunta es qué tipo de disputas de propiedad intelectual podrían surgir con el tiempo. Existe un gran mercado para los modelos 3D, con varios mercados en línea, incluidos CGStudio y CreativeMarket, que permiten a los artistas vender el contenido que han creado. Si Point-E se pone de moda y sus modelos llegan a los mercados, los artistas de modelos podrían protestar, señalando evidencia de que la IA generativa moderna se basa en gran medida en sus datos de entrenamiento: modelos 3D existentes, en el caso de Point-E. Al igual que DALL-E 2, Point-E no acredita ni cita a ninguno de los artistas que podrían haber influido en sus generaciones.

Pero OpenAI deja ese tema para otro día. Ni el documento de Point-E ni la página de GitHub mencionan los derechos de autor.

Source link